Trump, Twitter e la moderazione dei contenuti online

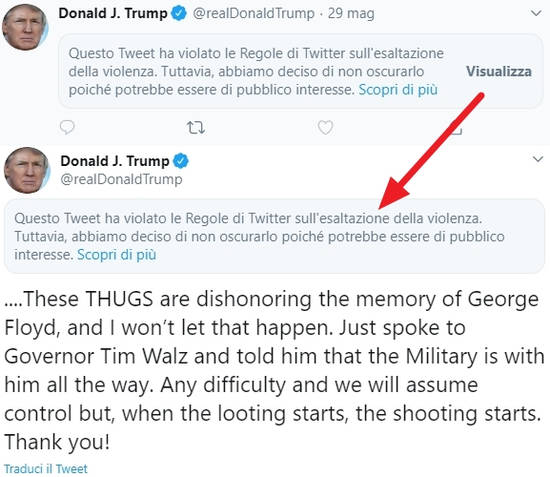

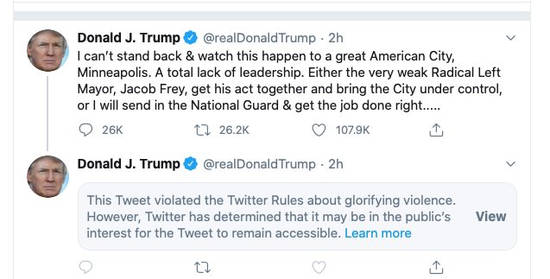

28 min letturaIl 29 maggio Twitter applica (annuncio dell’account ufficiale di Twitter) le sue regole di moderazione (fact-checking) al Presidente degli Stati Uniti d'America Donald Trump. Il tweet non è censurato (perché ritenuto di interesse pubblico), ma è aggiunta l’etichetta indicante che viola i termini di servizio del social, e occorre cliccare su "Visualizza" per leggerlo. Inoltre la diffusione del tweet viene ridotta (l'algoritmo di raccomandazione in sostanza eviterà di porlo in evidenza). In realtà già il 26 due tweet del Presidente degli Usa erano stati etichettati come “misleading” (fuorvianti).

In passato il fact-checking di Twitter è stato applicato molte volte, anche a personaggi di primo piano. A marzo Twitter ha rimosso post del Presidente brasiliano Bolsonaro e del Presidente del Venezuela Maduro, e anche del portavoce del ministero degli esteri cinese, sempre per violazione delle politiche sui contenuti. Ma fino a maggio Twitter non aveva mai applicato le sue regole al Presidente degli Usa. Fino a quel momento la vera anomalia era il favore accordato a Trump.

Poi, l’11 maggio Twitter annuncia un aggiornamento delle sue policy volte a limitare la diffusione di contenuti potenzialmente dannosi e fuorvianti in relazione alla pandemia del COVID-19. La politica di Twitter, infatti, non era stata applicata ai tweet di Trump che sostenevano, falsamente, che l’idrossiclorochina avrebbe dimostrato di trattare efficacemente il nuovo coronavirus.

In risposta alle azioni dello staff di Twitter, il responsabile per la campagna elettorale di Trump, Parscale, ha sostenuto che Twitter si nasconde dietro lo schermo dei fact checkers per fare, invece, politica attiva. E Trump stesso ha detto su Twitter che il social interferisce con la politica americana e con le elezioni del 2020. Ritiene che Twitter abbia assunto una sorta di “responsabilità editoriale” sui contenuti degli utenti che diffonde, e quindi ne dovrebbe rispondere. Per tale motivo Trump emana un ordine esecutivo dando mandato alla FCC di valutare se modificare la normativa in materia di responsabilità delle piatteforme online (Sezione 230 del Communications Decency Act). Anche se in realtà è piuttosto pacifico che una tale modifica spetta al Parlamento non certo all’esecutivo.

Di contro, il CEO di Facebook, Zuckerberg, ha affermato che nessuna società privata dovrebbe agire come “arbitro della verità” e che in particolare le piattaforme di social media non dovrebbero essere in grado di farlo. Con ciò distanziandosi dalle scelte di Twitter. In risposta alcuni dipendenti di Facebook (alcuni esempi: Jason Toff, direttore gestione prodotti; Trevor Phillippi, progettista prodotti Messenger; Nate Butler, designer) hanno criticato la posizione dell’azienda.

In realtà dal punto di vista legale non c’è molto, le affermazioni del Presidente Usa non sono state prese in considerazione dagli esperti della materia. Trump sostiene che se le aziende del web limitano “inappropriatamente” i contenuti online di fatto eserciterebbero una responsabilità editoriale, e quindi ne devono rispondere, ma non ha colto i risvolti legali della questione. Il "Primo Emendamento" è nato per limitare il potere del governo di censurare i cittadini, ma Twitter non è il governo. Inoltre qui non si parla di censura (visto che il tweet è visibile), casomai è una riduzione della visibilità del discorso del Presidente. Tutti i cittadini hanno diritto di dire la loro opinione, ma questo non vuol dire che i social debbano amplificare necessariamente tutto ciò che essi dicono. La Sezione 230 del CDA, inoltre, protegge specificamente le piattaforme del web da azioni legali per i contenuti pubblicati dagli utenti. In sostanza aumentare la responsabilità delle aziende del web per i contenti degli utenti farebbe immancabilmente aumentare anche la cancellazione dei contenuti, perché l‘azienda deve ridurre le possibili azioni legali nei suoi confronti. Ciò significa che chi ha più soldi per avviare una azione legale contro una piattaforma finirebbe per essere favorito rispetto ai normali cittadini. Insomma, la richiesta di Trump appare esattamente la richiesta di un privilegio per chi è più potente (politicamente o economicamente).

(13) Already I have gone on too long and taken the EO more seriously than it deserves. The EO is all gesture, no meaningful legal bite, but it has the destructive effect of likely wasting career FTC and FCC staff energy and brain cells. It angers me in its call for state AGs

— Danielle Citron (@daniellecitron) May 29, 2020

È da notare che in passato anche il candidato democratico Joe Biden ha avuto da ridire sulle aziende del web, sostenendo che Facebook e altri social media propagandano falsità consapevolmente e non rispondono di alcunché, ritenendo che la Sezione 230 debba essere cancellata del tutto. In sostanza, c’è un’intesa comune tra Repubblicani e Democratici per rivedere la Sezione 230 del CDA, laddove i primi ritengono che le piattaforme cancellino troppo, i secondi che cancellino troppo poco.

I critici più che altro sostengono che Trump ha preso la palla al balzo per distogliere l'attenzione dal fallimento della sua politica: 40 milioni di disoccupati, oltre 100mila morti per Covid 19 e una recessione in arrivo proprio mentre si avvia la campagna per la sua rielezione. Il punto però è un altro. Quello di Trump si presenta come un vero e proprio “avvertimento” a Twitter in vista della campagna elettorale ormai prossima.

Le piattaforme devono rispondere dei contenuti?

Come regolamentano i contenuti le piattaforme

Le piattaforme devono rispondere dei contenuti?

Tutte le piattaforme di social media sostengono di essere impegnate contro la disinformazione, l’hate speech, l’incitamento alla violenza, ecc… Se sei impegnato contro la disinformazione e la violenza dovresti bannare chi incita alla violenza oppure fa disinformazione, dicono molti, ma poi il problema si trasforma in chi diventa l’arbitro della verità. Vuoi che qualcuno decida cosa può essere pubblicato online ma non vuoi che siano i privati (i social) a farlo? La confusione è tale che spesso si invoca una sorta di responsabilità editoriale a carico delle piattaforme dimenticando che responsabilità editoriale vuol dire che è il social che sceglie cosa pubblicare e cosa no.

Le norme in materia (Sezione 230 CDA negli Usa e Direttiva eCommerce in Europa) sono nate anche per preservare l’innovazione resa possibile dalle nuove tecnologie. I legislatori dell’epoca sapevano bene che il sistema giudiziario non sarebbe stato in grado di regolamentare l’intera umanità che si riversa in rete (mentre prima tale massa era preselezionata dagli editori), e quindi studiarono un sistema per consentire alle aziende di regolamentare tali contenuti senza implicare una responsabilità da parte loro, cosa che avrebbe potuto portare a disfunzioni di vario genere: maggiore responsabilità per le aziende porta a un maggior numero di rimozioni di contenuti dubbi.

Come regolamentano i contenuti le piattaforme

Nell’era dei social media anche la libertà di espressione opera differentemente rispetto all’epoca in cui il discorso pubblico era filtrato dai giornali e dalla televisione (epoca della scarsità di risorse). Oggi la censura si manifesta non più tramite la soppressione del discorso (il filtraggio di giornali e televisioni che consentivano il passaggio solo di determinati messaggi), bensì tramite la manipolazione dell’attenzione in un ambiente inondato da messaggi (Balkin, Free Speech in the Algorithmic Society). La “censura” oggi viaggia sulle ali di campagne di odio mirate verso persone o gruppi di persone e tese a screditarle e zittirle, di epidemie di disinformazione tese a screditare fonti di valide informazioni in modo da livellare tutto il discorso pubblico a mera opinione personale. La campagna di Trump per le elezioni del 2016 era infatti centrata sull’invio di contenuti divisivi e anti-Clinton ai supporter democratici, più che di pubblicità ai propri sostenitori per convincerli a votare.

Il modello di business delle piattaforme online è basato sulla pubblicità comportamentale, per cui la struttura dei social media è realizzata per mantenere il più possibile gli utenti online, e quindi inonda letteralmente ogni singolo utente di una miriade di messaggi in base alla preferenze dell’utente stesso (ma filtrate dall’algoritmo del social). Come rilevato dagli studi, gli utenti trovano i contenuti falsi e infiammatori più condivisibili di quelli non controversi. In questo modo il social media diventa strumento per amplificare e propagare forme di contenuti estremi (Vosoughi, The Spread of True and False News Online; Crockett, Moral Outrage in the Digital Age). A ciò si aggiunge che è estremamente facile promuovere i propri contenuti (a pagamento), e la pubblicità online (Ad Tech) rende semplicissimo raggiungere gruppi di utenti in base a classificazioni quantomeno questionabili (razza, genere, età, etnia). Quindi il modello di business delle piattaforme (ma non solo, basta guardare i giornali e la televisione per notare che il modello di business è lo stesso, e gli effetti sono simili) di fatto porta a veicolare il più possibile contenuti scandalistici, fake news, contenuti complottistici, ecc...

Il narcisismo è una malattia molto diffusa, e la gente è attratta più che altro da se stessa. La pubblicità non deve fare altro che vendere alla gente un’immagine di sé (Vance Packard)

Del resto è più facile e meno costoso creare decine e decine di contenuti di questo tipo piuttosto che un'inchiesta giornalistica elaborata e realmente informativa. In questo modo molti giornali (ma anche la TV) si stanno gradualmente spostando verso un modello di business che alimenta e favorisce l’uso di contenuti scandalistici e titoli “urlati”, fino ad una vera e propria retorica “apocalittica”, con la giustificazione di dover combattere la crisi dei giornali. E questi sono i contenuti “giornalistici” che vengono veicolati tramite i social media ad alimentare un sistema di business model tossico che espone i media alla manipolazione. Questo per rimarcare che il problema non è solo dei social ma dell'intero ecosistema informativo.

Le piattaforme, anche quelle che si limitano ad ospitare contenuti degli utenti (es. YouTube) regolamentano in vari modi i contenuti online:

- Classificazione dei contenuti.

- Rimozione dei contenuti o interventi di riduzione della visibilità.

- Risposta agli inserzionisti.

La classificazione dei contenuti (ranking) e la conseguente amplificazione (aumentare o diminuire la visibilità di un post) dipende dalle norme della piattaforma (i termini di servizio, le policy, ecc…) che sono create internamente e dipendono in larga parte da scelte del consiglio di amministrazione dell’azienda. Il ranking è la regolamentazione continuativa dei contenuti e determina quali contenuti sono più rilevanti o prioritari. Molto spesso sentiamo che la mission di Facebook (“an institution committed to free expression”, il discorso è uguale per le altre piattaforme) è di connettere gli individui e cose simili, ma il fine ultimo di un’azienda è fare soldi, non di preoccuparsi dei diritti dei cittadini, per cui la classificazione dei contenuti (tramite algoritmi creati da team di ingegneri) è organizzata in modo che siano massimizzati i profitti, o quanto meno che la conseguente regolamentazione non li riduca. Così le piattaforme spendono un sacco di soldi solo per minimizzare la percezione del danno che noi abbiamo in conseguenza delle attività del social. E questo lo fanno a diversi livelli, compreso un’intensiva attività di lobbying per evitare delle regolamentazioni statali.

Però non dobbiamo dimenticare che la maggior parte dei problemi che le piattaforme affrontano nella moderazione dei contenuti sono problemi sociali (non della piattaforma), e quindi spesso la piattaforma non può fare altro che nascondere lo sporco sotto il tappeto (rimozione o degradazione dei contenuti dannosi), ma non potrà mai risolvere un problema sociale (che poi sarebbe il compito dei governi). Se anche una piattaforma dovesse trovare la formula magica per poter identificare tutti i contenuti dannosi (che dipendono dal contesto, quindi è un compito difficilissimo) e rimuoverli, probabilmente i produttori di tali contenuti si sposterebbero su altre piattaforme oppure se ne creerebbero di loro. Insomma, una soluzione solo tecnologica non esiste.

Ma se la “rimozione”, la “classificazione”, l’“amplificazione” dei contenuti sono conseguenza di specifiche scelte aziendali, l’azienda può fare molto per evitare di alimentare e amplificare i problemi sociali preesistenti. È difficile che un utente possa trovare un contenuto dannoso tra milioni, se questo non è “prioritizzato” in qualche modo. Rimane sempre il problema della definizione, è giusto che sia l’azienda a stabilire cosa è dannoso?

Infine, le piattaforme regolamentano i contenuti anche in relazione alle richieste degli inserzionisti. Poiché il loro business principale in genere è quello pubblicitario, se gli inserzionisti si lamentano di non voler vedere i loro prodotti accostati a contenuti di un certo tipo (opinabili per i loro potenziali acquirenti), le piattaforme sicuramente intervengono per non ridurre i profitti. Questo è ciò che sta accadendo proprio in questi giorni a Facebook con la campagna “Stop Hate for Profit”. La reputazione del marchio è uno dei valori più importanti al giorno d’oggi, ma questo, deve essere chiaro, non c’entra nulla con i diritti dei cittadini. Si tratta di iniziative di multinazionali nei confronti di altre multinazionali, tese a tutelare la reputazione di un marchio e quindi a ottenere un riequilibrio delle forze contrattuali in gioco.

Come interferiscono gli Stati

Dall’altro lato c’è un incentivo dei governi a regolamentare le piattaforme in quanto “nuovi editori” (nuovi media) e gatekeeper del discorso online. Ormai la maggior parte del discorso pubblico viene veicolato dalle piattaforme online (piuttosto che dagli editori tradizionali, fermo restando un ruolo ancora prevalente della televisione in molti paesi, come in Italia). Qualsiasi governo ha la necessità di realizzare forme più o meno invasive di controllo del discorso pubblico, non solo per rendere più sicura la società, ma anche per assicurarsi la propria sopravvivenza e perpetuazione. Ovviamente più un paese è democraticamente strutturato meno potrà permettersi l’invasione di campo del discorso pubblico e quindi tentativi di costruire una narrazione positiva per il governo (pensiamo alla Cina, ma anche alla Russia e agli Usa di Trump). Una maggiore regolamentazione del discorso pubblico è indice di una minore resistenza sociale all’autoritarismo. Anche in Italia notiamo sempre più spesso “spinte” normative verso un maggior controllo del discorso pubblico, come il recente emendamento che ha introdotto i filtri di default per il porno in rete (come ha sostenuto il legale Jackman «La pornografia è il canarino nella miniera di carbone della libertà di parola. È la prima a cadere»).

In tale ottica i governi tendono, a seconda del paese, a introdurre regolamentazioni che consentano un controllo almeno potenziale del discorso pubblico. Tali regolamentazioni sono molto più facili da realizzare nell’ambiente offline (giornali e televisione) piuttosto che nell'ambiente digitale, per due ragioni:

- Una presenza di un numero di attori potenzialmente infinito (blog, forum, ecc…).

- Il “peso” delle grandi piattaforme che politicamente sono in grado di dialogare ormai alla pari con i più grandi Stati.

Per risolvere il primo dei due problemi le regolamentazioni (es. direttiva copyright) tendono a introdurre delle barriere all’ingresso del mercato favorendo una concentrazione in poche grandi piattaforme, cosa che rende più semplice introdurre oneri a loro carico.

In realtà, il discorso è molto più complesso, basti accennare al fatto che regolamentazioni statali che introducono barriere all’ingresso del marcato sono anche la conseguenza della presa di coscienza dell'impatto di tali piattaforme sulla società, riducendo la possibilità dell’emersione di nuove piattaforme (che potrebbero aggravare la situazione). Allo stesso modo, la crisi finanziaria del 2008 scatenata principalmente dalle grandi banche, costrinse gli Stati (specialmente in Europa) paradossalmente a rendere più difficile l’ottenimento di licenze bancarie proprio per evitare l’ingresso nel mercato di nuove banche. Cosa che favorì le grandi banche già presenti nel mercato che videro consolidata la loro posizione dominante (Mazzucato, Il valore di tutto).

Gli Stati interferiscono con la regolamentazione dei contenuti online con i seguenti strumenti:

- Leggi.

- Soft law e moral suasion

- Ordini globali.

Le leggi che regolamentano direttamente il discorso online assegnano una particolare responsabilità alle piattaforme del web, che se risulta eccessivamente estesa (es. in assenza di effettiva conoscenza del contenuto) incentivano le piattaforme a rimuovere i contenuti utilizzando algoritmi di filtraggio. È notorio che tali algoritmi non sono in grado di comprendere il contesto, per cui ciò determina numerosi errori (rimozioni di contenuti del tutto leciti).

A ciò si aggiunge che le aziende, per evitare di dover rispondere dei contenuti degli utenti, tendono a rimuovere tutto ciò che è dubbio. Se le piattaforme con maggiori risorse economiche possono anche decidere di resistere alle azioni giudiziarie, le piattaforme con meno risorse inevitabilmente finiscono per rimuovere tutto ciò che viene considerato “illegale” o semplicemente “fastidioso” dalla persona che ne subisce gli effetti. Il giudizio quindi diventa soggettivo, e le persone con maggiori risorse economiche, che possono più facilmente avviare azioni legali contro le piattaforme, ottengono più facilmente il ripristino dei loro contenuti o la rimozione di quelli altrui. Si crea una discriminazione tra cittadini per cui chi ha più potere o soldi o popolarità ottiene maggiore spazio nel discorso pubblico. È il classico esempio di Trump che, quale Presidente degli Usa, ha un grande potere e quindi ha ottenuto per parecchio tempo un favore non accordato a nessun altro.

Soft law e moral suasion si ha quando lo Stato fa pressione verso le piattaforme per attivare forme di intervento (filtri come quelli usati tra aziende sui contenuti terroristici) e di autoregolamentazione (codici di condotta, come il Codice sull’Hate Speech europeo), talvolta minacciando propri interventi in assenza di iniziativa delle piattaforme. Ovviamente in questi casi le aziende sono fortemente spinte a ottemperare agli “inviti” statali, anche perché così l’azienda evita una regolamentazione statale che sarebbe sicuramente più stringente. Tale forma di interferenza si ha generalmente quando uno Stato non ha la capacità di intervenire su un problema oppure non ne ha una comprensione adeguata, e quindi delega al soggetto più “vicino” al problema. L’effetto è che si rafforza il potere della piattaforma che diventa di fatto il “regolatore” sostituendosi allo Stato, mentre nel contempo lo Stato può “vendere” il risultato politico alla cittadinanza (“abbiamo risolto il problema”). In realtà, in tali casi i cittadini ci perdono, perché è ovvio che un'azienda applicherà una regolamentazione che massimizza i suoi profitti limitandosi a creare la percezione di affrontare il problema, e i cittadini non hanno un reale mezzo di impugnazione delle decisioni della piattaforma. Il caso più noto è quando i processori di pagamento, compulsati dall’FBI, chiusero gli account di Wikileaks portandolo al sostanziale fallimento.

Infine, gli Stati interferiscono nella regolamentazione dei contenuti online tramite ordini globali. Ci sono stati vari tentativi (es. il ricorso della leader dei verdi tedeschi) di ottenere degli ordini di rimozione di contenuti online a livello globale. La giustificazione è che se un contenuto è illecito allora il contenuto dovrebbe essere oscurato per tutti. In realtà in tantissime materie non c’è armonizzazione di norme tra tutti gli Stati, in molti casi non c’è armonizzazione nemmeno nell’Unione europea (si pensi alla diffamazione) per cui imporre una rimozione globale a una piattaforma equivale a imporre le norme di un paese a tutti gli altri in nome di una qualche superiorità “morale”. È evidente che tale strada finirebbe per favorire i paesi più autoritari. Ad esempio la Turchia potrebbe chiedere rimozioni globali per i contenuti dissenzienti verso la politica locale (pensiamo a persone in esilio), i tribunali russi potrebbero ottenere rimozioni globali per le leggi di “propaganda” gay (qui un esempio), e l’Arabia Saudita per i contenuti “blasfemi”. L’intero discorso pubblico finirebbe per essere alla mercé di ogni singolo autocrate.

Occorre anche tenere presente che le piattaforme globali hanno un notevole incentivo ad allinearsi al potere, specialmente quello di Stati autoritari, per la propria sopravvivenza. In tal modo finiscono per diventare uno strumento per tali governi. È accaduto in Brasile, nelle Filippine, in Cambogia e Myanmar. Fino a maggio 2020 negli Usa Facebook ha costantemente ignorato o modificato i suoi termini di servizio a favore di Trump, e Twitter ha fatto lo stesso.

Quali soluzioni?

I problemi ci sono e sono importanti in quanto incidono sull’intera società, ma emergono chiaramente dei punti fermi:

- Occorre una regolamentazione dei contenuti immessi sulle piattaforme del web da parte degli utenti.

- Le piattaforme del web devono continuare a godere di una sorta di immunità (come esiste attualmente) in presenza di determinati requisiti, perché tale immunità ha permesso il nascere di numerosi attori nell’ambito digitale, e eliminare tale immunità significherebbe ingessare l’intero mercato digitale consegnandolo alle aziende dominanti e impedendo la nascita di nuovi servizi.

- Alcune delle idee di regolamentazione che sono circolate o circolano tutt’ora sono figlie di un’idea di Internet che non ha alcun riscontro reale, più che altro derivano da una visione del web come fosse una grande televisione, e porterebbero ad una castrazione letterale della tecnologia digitale favorendo i vecchi media (è anche possibile che alcuni politici vogliano effettivamente questo).

- Alcune delle idee di regolamentazione non considerano in realtà il punto di vista del cittadino, bensì il punto di vista delle aziende in concorrenza (per lo più quelle che non sono riuscite a farsi spazio nell’ambito digitale), per cui non porterebbero alcun vantaggio ai cittadini, ma si limiterebbero a creare una sorta di nuovo oligopolio tra vecchi e nuovi media.

- Molti dei problemi (cyberbullismo, hate speech, fake news) che si additano alle aziende del web sono problemi sociali, e quindi non possono essere risolti dalle aziende del web.

Inoltre, anche le aziende hanno dei diritti, in particolare esiste la libertà di impresa, costituzionalmente garantita, che impedisce di imporre alle aziende degli obblighi che non siano in qualche modo giustificati. Imporre a una azienda la pubblicazione di un contenuto non è possibile, anche le piattaforme hanno il diritto di includere o escludere dei contenuti, in particolare hanno il diritto di regolare i contenuti sulla base dei loro interessi economici. Anche l’amplificazione di un contenuto alla fine è un “diritto” dell’azienda collegato alla libertà di impresa, perché tramite l’amplificazione, il ranking e la prioritizzazione di un contenuto l’azienda guadagna o perde soldi. Ugualmente le aziende non hanno obblighi di “migliorare” la società, questo semmai è un compito del governo. E questo, ribadiamolo, non implica necessariamente una qualche forma di responsabilità editoriale (che è ex ante e legata al contenuto, mentre il ranking è ex post e indifferente al contenuto).

Vediamo alcuni degli argomenti più discussi. Chiaramente c’è una sovrapposizione tra i vari argomenti, in quanto alcuni di essi portano con sé come soluzione l’obbligo di imporre una sorta di neutralità delle piattaforme. Come per dire che esse dovrebbero veicolare tutti i contenuti senza alcun intervento (must carry).

Le piattaforme agiscono come Stati: l’idea che le piattaforme debbano essere regolamentate in quanto agiscono come Stati è suggestiva ma non ha solide fondamenta. Anche un tribunale distrettuale americano ha respinto tale idea sostenendo, piuttosto, che il Presidente degli Usa ha usato il suo account privato nell’esercizio delle funzioni statali, e in quanto soggetto pubblico che esercita funzioni statali non può bloccare i cittadini dal leggere i suoi tweet. Il tribunale ha respinto l’idea che Twitter possa essere considerato un attore statale e quindi soggetto al Primo Emendamento.

Leggi anche >> Un politico può “bloccare” i cittadini sui social media?

Le piattaforme come servizi essenziali per la comunicazione: anche tale argomento comporterebbe un obbligo di pubblicazione (must carry) da parte delle piattaforme. Alla base l’idea che le piattaforme ormai siano talmente grandi da essere diventate i veri e propri gatekeeper dell’informazione online e quindi del discorso pubblico (Franken).

Innanzitutto si parla del solo discorso online laddove esiste anche il discorso offline (giornali e televisione), in particolare la televisione è tutt’ora considerato il mezzo prevalente per la formazione delle opinioni in molti paesi (compreso l’Italia). Il problema fondamentale è che la singola piattaforma non si trova praticamente mai in una posizione “collo di bottiglia” come può accadere con un carrier (gestore telefonico) per cui un approccio a livello antitrust non è semplice né immediato. Twitter, ad esempio, non si trova certamente in una posizione dominante, perché non è l’unico social al quale ci si può rivolgere. Un utente bannato da Facebook può scrivere su Twitter, oppure su Youtube, Instagram, oppure aprirsi un blog o un forum. La realtà è che tale argomento aveva un senso quando esisteva una scarsità di risorse (es. di banda televisiva) e aprire un servizio di comunicazione era costoso. Oggi la tecnologia digitale ha completamente abbattuto ogni forma di scarsità per cui chiunque, con una spesa minima (in genere il solo costo della connessione a Internet) può esprimere la propria opinione.

Infatti, alcune delle idee di regolamentazione partono proprio dalla considerazione che occorrerebbe indurre una scarsità di risorse artificiale nell’ambiente digitale (esempio aumentare i tempi di diffusione o limitare la diffusione dei contenuti), così da ricreare la medesima situazione che riscontriamo, ad esempio, con le televisioni via etere.

L’argomento in questione è stato scartato anche dalla giurisprudenza italiana (anche una sentenza francese), che di recente si è pronunciata sostenendo che il rapporto tra utenti e social network è un rapporto regolato da fonti private (il contratto). Ciò ovviamente non vuol dire che non debbano essere considerati i valori fondamentali espressi dalle Convenzioni internazionali, in quanto anche un contratto privatistico non può essere in contrasto con tali fonti normative.

Le piattaforme come servizi essenziali (utilities): l’idea che le piattaforme siano assimilabili a servizi pubblici essenziali (come le ferrovie, i fornitori di luce e gas, ecc…) è un tipico approccio antitrust molto gettonato (Pasquale, Platform Neutrality: Enhancing Freedom of Expression in Spheres of Private Power). Negli Usa è specialmente a destra che si cerca in tale prospettiva una nuova regolamentazione delle piattaforme del web. Questo argomento, però, sostanzialmente parte da un problema per creare una soluzione. Il fatto che le piattaforme siano dei monopoli è un problema che va affrontato, non è una precondizione dalla quale partire, altrimenti stiamo solo dicendo che lo Stato è incapace di gestire le piattaforme online e quindi sostanzialmente cede loro le sue funzioni. Cosa che, intendiamoci, accade già. Pensiamo all’Italia dove lo spettro dei canali televisivi è la conseguenza dell’accettazione di una situazione di fatto parzialmente non conforme alle leggi e mai risolta. Inoltre un approccio del genere al massimo potrebbe imporre obblighi di trasmissione dei contenuti senza interferenze (must carry), quindi escludendo oneri di moderazione dei contenuti. In sostanza, il web diventerebbe un vero e proprio Far West per legge.

Responsabilità editoriale per le piattaforme: l’introduzione di una “responsabilità editoriale” per le piattaforme è un argomento molto discusso. La responsabilità editoriale (sul punto si legga Innocenzo Genna) è una forma di responsabilità diretta per le scelte compiute nella selezione dei contenuti e nell’editing degli stessi. L'editore ha interesse a pubblicare quello specifico contenuto, mentre una piattaforma non ha interesse in uno specifico contenuto quanto piuttosto nel mantenere l’utente il più possibile sulla piattaforma.

La piattaforma non opera una selezione ab origine dei contenuti, in genere per la piattaforma qualsiasi contenuto va bene (tranne quelli che è obbligata per legge e non pubblicare, tipo i contenuti pedopornografici), quindi non seleziona i contenuti da pubblicare, ma si limita a operazione di ranking in relazione non all’argomento del post ma alla viralità dello stesso. Fin quando il ranking dipende da fattori esterni al contenuti dell’articolo (il prezzo dell’inserzione, il numero di click o visualizzazione) non siamo nel campo della selezione editoriale. Anche la selezione dei video più popolari è basata non sul contenuto del video ma sulle preferenze degli utenti.

Inoltre, premettendo che qui consideriamo la “responsabilità” per i contenuti immessi dagli utenti (mentre per i contenuti prodotti dalla piattaforma questa già di per sé ne è responsabile), questi non possono essere qualificati come esercizio del diritto di cronaca giornalistica (infatti rientrano nella libertà di espressione), non essendo possibile rintracciare in essi gli estremi del carattere giornalistico dell’attività svolta e l’intento lucrativo propri di un'attività professionale. Quindi la piattaforma non può essere giuridicamente paragonabile ad un direttore di stampa.

Come già detto, però, anche il ranking, l’amplificazione, sono regolamentazioni dei contenuti, per cui l’argomento in sé è piuttosto complesso. Ma si può semplificare il tutto precisando che se dovessimo accollare alle piattaforme una responsabilità editoriale, il reale pericolo è che la eserciterebbero. Responsabilità editoriale vuol dire, infatti, che la piattaforma avrà l’obbligo (ma anche il diritto a questo punto) di scegliere cosa pubblicare e cosa no. Avremmo trasformato le piattaforme del web in megaeditori (come giornali e televisione), e sappiamo bene che su giornali e televisioni i cittadini normali non hanno praticamente alcun accesso. Insomma, l’argomento porterebbe quasi certamente a una discriminazione dei cittadini in base al potere (politico, economico) da essi detenuto: chi ha più potere avrà più voce online.

Leggi anche >> Facebook e Twitter hanno deciso che i politici sono più uguali degli altri

Più controllo agli utenti: un’altra delle soluzioni proposte è dare maggiore controllo agli utenti su ciò che vedono online. In sostanza dovrebbero essere gli utenti stessi a selezionare dei filtri in modo da oscurare persone o argomenti che non vogliono leggere. È uno degli approcci più discussi, ma in realtà non è una vera soluzione, in quanto si limita a nascondere lo sporco sotto il tappeto. Le persone continueranno a postare online hate speeh e fake news, ma io posso scegliere di non vedere tali contenuti istruendo opportunamente l’algoritmo del social per una censura selettiva. In pratica l’utente sceglie spontaneamente di erigere dei muri intorno a sé.

La “dark forest theory” ci aiuta a superare questo argomento. Nella sua trilogia di fantascienza “The Three Body Problem”, Liu Cixin spiega il moderno spazio digitale tramite la metafora della foresta oscura, dove sembra che non vi sia vita quando in realtà gli animali si nascondono, per paura, dai predatori feroci lasciando loro il campo.

Gli utenti della rete Internet, in risposta alle tantissime forme di aggressione presenti online si ritirano progressivamente in spazi chiusi. Per paura delle pubblicità troppo invasive, del tracciamento, del phishing e dei furti di identità, delle fake news, e di tanti comportamenti predatori, gli utenti normali si ritirano nelle newsletter, nei podcast, in gruppi chiusi, in chat Whatsapp, in spazi ad accesso controllato, per non doversi scontrare con i “mostri” che vivono là fuori. Sono spazi in cui è possibile una conversazione depressurizzata, e che forniscono una copertura psicologica e reputazionale, che ci permettono di essere noi stessi perché sappiamo chi è l’altro col quale condividiamo lo spazio. Lo stile di comunicazione può essere più vero rispetto al libero spazio di Internet dove c’è un alto rischio di imbattersi in troll o persone con le quali il dialogo è difficile e che quindi non offrono sicurezza emotiva. Insomma, le “brave persone” farebbero bene a ritirarsi nelle foreste oscure lasciando lo spazio del discorso pubblico ai “mostri” e ai “predatori notturni”. Ma in questo modo l’intero spazio del discorso pubblico sarebbe alla mercé di chi agisce con violenza “psicologica”, e le conseguenze sarebbero la creazione di “filter bubble”, “echo chambers” e scarsità di attenzione, finendo per alimentare i problemi che si additano in genere all'ambiente digitale.

Neutralità delle piattaforme: le piattaforme del web si muovono su due strati (layer), uno è l’infrastruttura fisica (hardware e software), l’altro è costituito dalle applicazioni (es. Facebook) che girano sull'infrastruttura (Renda, Antitrust, Regulation, and the Neutrality Trap). La struttura fisica della rete Internet non è specializzata ma è generica, potendo così trasportare qualsiasi tipo di contenuto, a differenza, ad esempio, della rete telefonica che è specializzata per contenuti “voce”. Internet, quindi, consente agli sviluppatori di non doversi preoccupare del funzionamento della rete per il trasporto di dati e servizi. In questo senso le applicazioni girano “sopra” l’infrastruttura fisica in modo indipendente da essa.

Il network layer sostanzialmente si comporta come un normale servizio di trasporto (es. ferrovie, ma anche poste), è del tutto agnostico rispetto al contenuto. In linea di massima in questo strato non è possibile discriminare i contenuti trasportati né modificarli durante il trasporto (net neutrality). Ciò ha consentito la realizzazione di una notevole diversità di prodotti e servizi, nonostante la presenza di alcuni operatori dominanti rispetto ad altri (es. Google nel search).

Leggi anche >> Internet uguale per tutti: la neutralità della rete è salva

Il layer della applicazioni, invece, incoraggia la differenziazione dei servizi. Trattandosi dello strato nel quale i bit diventano parole o immagini, è il luogo dove si realizzano le violazioni della privacy, le diffamazioni, le offese e tutte le problematiche che abbiamo osservato in Internet. Su questo livello si concentrano le norme (Direttiva eCommerce, Communication Decency Act, DMCA) che introducono regole le quali incoraggiano i fornitori di servizi online a rimuovere contenuti illegali e offensivi. Queste regolamentazioni fin dal primo momento sono state studiate proprio perché le piattaforme siano consapevoli delle problematiche che possono nascere dal diffondere contenuti immessi dagli utenti, e quindi ad occuparsi di tali problemi (all’epoca principalmente il rischio di esporre minori a contenuti pornografici). Purtroppo, specialmente negli Usa, si è osservato che tali norme sono state utilizzate spesso da parte della piattaforme per trincerarsi dietro una presunta neutralità o tutela della libertà di espressione, in tal modo rifiutando di rimuovere il più possibile i contenuti (Ardia, Free Speech Savior or Shield for Scoundrels).

La Sezione 230 del CDA contiene la Protezione del Buon Samariano (230(c)(2) “Protection for ‘Good Samaritan’ blocking and screening of offensive material”), la quale stabilisce l’immunità del provider nel caso in cui rimuova contenuti specifici (obscene, lewd, lascivious, filthy, excessively violent, harassing, or otherwise objectionable, whether or not such material is constitutionally protected), con ciò autorizzando i provider ad attivarsi nella moderazione dei contenuti (di fatto è una “discriminazione” in base ai contenuti). La regola fu introdotta proprio per rimuovere i disincentivi nello sviluppo di strumenti di moderazione dei contenuti (Stratton Oakmont, Inc. v. Prodigy Services).

Tra l’altro la giurisprudenza americana ritiene che la protezione si applichi solo nel caso in cui la piattaforma offra una spiegazione della rimozione in richiesta dell’utente. Però, a differenza del Safe Harbor di cui al DMCA la Protezione del Buon Samaritano non richiede l’effettiva rimozione del contenuto, in tal modo lasciando mani libere alla piattaforma nella regolamentazione dei contenuti (ma sempre nei limiti dei contenuti non tutelati dal Primo Emendamento). Quindi protegge gli intermediari quando adottano misure volontarie per limitare l'accesso o la disponibilità di determinati contenuti ma anche quando mancano tali contenuti e non intraprendono alcuna azione.

Invece, col DMCA (e il corrispondente istituto di cui alla direttiva eCommerce europea) la situazione è diversa. Per l’Europa, infatti, l’esenzione scatta solo se il provider poi rimuove, e quindi non basta che il provider faccia del suo meglio per rimuovere i contenuti illeciti, la norma richiede che effettivamente i contenuti illeciti siano rimossi, altrimenti il provider ne risponde. In tal senso in Europa chi adotta misure proattive è incentivato a rimuovere tutto il possibile, in particolare i contenuti incerti, mentre le piccole aziende (per le quali i sistemi di filtraggio sono un costo eccessivo) sono incentivate a non moderare i contenuti.

Inoltre, molte pratiche di takedown si sono rivelate nocive per gli utenti stessi, e in particolare per le comunità già marginalizzate. Le rimozioni si sono concentrate contro i gruppi già socialmente discriminati. Un classico esempio è la sospensione degli account dei fan di Lolita di Nabokov su LiveJournal, in risposta ad una supposta rete di pedofili (Tushnet, Power Without Responsibility: Intermediaries and the First Amendment; e Unfriending Censorschip. Insights from four months of crowdsourced data on social media censorship).

La personalizzazione è l’elemento centrale del social, senza il quale non esisterebbe. E la “personalizzazione” di fatto è una sorta di discriminazione. Qualsiasi tipo di intervento incide sulla libertà di espressione, anche se ciò non implica alcuna responsabilità editoriale.

Conclusioni

La regolamentazione dei contenuti online non può iniziare e terminare con la governance della piattaforma. Le piattaforme fanno parte di un più ampio ecosistema di media online, in cui le piattaforme più grandi non solo contribuiscono alla diffusione di contenuti illeciti, ma sono esse stesse un importante vettore di attacco (ad esempio i suprematisti bianchi armano le piattaforme per veicolare contenuti razzisti).

Una moderazione dei contenuti più responsabile sta diventando un problema reputazionale per le stesse piattaforme. Sono gli stessi utenti che chiedono a gran voce un ambiente digitale più accogliente e meno nocivo. Il problema non è solo quello di avere spazi di partecipazione, perché alla fine ce ne sono molti nell'ecosistema digitale (a differenza dei vecchi media dove sono presidiati dalle élite), ma anche di poter fare qualcosa per migliorare la società nel suo complesso, nella quale tutti viviamo. Quindi è un diritto del cittadino chiedere forme di moderazione dei contenuti che siano tese a un miglioramento della società. E questo non riguarda solo le piattaforme del web, ma l'intero ecosistema informativo, perché come una piattaforma mal regolamentata "infiamma" la società o parte di essa, lo stesso identico effetto si ha con i giornali e con la televisione, e tale effetto si riverbera sull'intera società e quindi su ognuno di noi. Da cui il diritto di dire la nostra nella regolamentazione dell'intero ecosistema informativo (non sono solo soldi di privati, insomma).

Nell'ambito della discussione sulla moderazione dei contenuti delle piattaforme, poi, c'è una diatriba tra destra e sinistra, laddove la prima tende a chiedere meno rimozioni, la seconda di più. Ma uno studio del 2016 della Oxford University (Narayanan, Polarization, Partisanship and Junk News Consumption over Social Media in the US) mostra che i contenuti “misleading” o comunque non corretti sono più spesso condivisi dai “conservatori” piuttosto che a sinistra. I sostenitori di Trump, ad esempio, hanno condiviso il 55% di tali contenuti su Twitter, e il 58% su Facebook. Un altro studio mostra che tali contenuti sono condivisi più da abitanti di piccoli centri rurali, cioè lì dove Trump ha ottenuto il maggiore sostegno nel 2016. Infine lo studio di Benkler, Faris e Roberts (Network Propaganda) evidenzia chiaramente che i media di destra veicolano contenuti di disinformazione più dei media di sinistra. Chiaramente un politico si informa tramite gli stessi media del suo elettorato, per sapere cosa lo può avvicinare al suo elettorato, quindi i media influenzano tanto l’elettorato quanto il politico stesso, in un circolo vizioso.

Di conseguenza è certamente possibile che l’elettorato di destra sia più colpito dalle politiche di moderazione delle piattaforme del web, ma ciò non è necessariamente una conseguenza di una discriminazione delle piattaforme, quanto piuttosto di una polarizzazione e dell’adesione dell’elettorato in questione a politiche identitarie, e quindi più divisive (Benkler, Faris e Roberts, Network Propaganda).

Il problema è che una moderazione responsabile è in gran parte preclusa da una regola imprescindibile al livello delle applicazioni, poiché un'ampia gamma di discorsi offensivi e dannosi è lecita in base al Primo Emendamento (negli Usa) e alle norma a tutela della libertà di espressione (in UE).

Secondo Bridy (Bridy, Remediating social media: a layer-conscious approach) l’approccio migliore potrebbe essere quello di portare a nuova vita la protezione del Buon Samaritano di cui alla Sezione 230 del Communications Decency Act, il cui scopo è di proteggere e promuovere la buona fede nella moderazione dei contenuti online. Purtroppo in Europa, dove la tutela della libertà di espressione è decisamente più debole rispetto agli Stati Uniti, non esiste un equivalente della Protezione del Buon Samaritano. Il Safe Harbor previsto dalle norme europee (Direttiva eCommerce) spinge le piattaforme a rimuovere ogni tipo di contenuti illegali. Con le pressioni sulle piattaforme che aumentano, da parte dei governi, le aziende del web hanno, infatti, acconsentito a stringere degli accordi volontari tra loro che sono sfociati in codici di condotta (2016 Codice Hate Speech).

In estrema sintesi una regolamentazione possibile dovrebbe avere queste caratteristiche. Le regole (policy) delle piattaforme dovrebbero essere:

- Applicate a tutti (compreso Trump).

- Trasparenti e comprensibili da tutti, in particolare in caso di violazione deve essere chiarito quale regola è stata violata, in modo da rendere possibile impugnare la decisione.

- Impugnabili secondo modalità semplici e poco costose (altrimenti diventano discriminatorie).

- La revisione delle decisioni affidate a esseri umani e non a algoritmi, in quanto solo gli essere umani sono in grado di comprendere il contesto.

- Sopratutto tali regole dovrebbero essere basate sulle norme a tutela dei diritti umani e non lasciate a decisioni delle aziende che finirebbero per essere prese al fine di massimizzare i profitti.

Insomma, deve esistere un quadro normativo statale che stabilisca i contorni delle policy delle aziende all’interno dei quali queste potranno poi operare. Il quadro dovrà contenere le definizioni, cosa si può rimuovere e cosa non si può rimuovere (Citron, Extremist Speech, Compelled Conformity, and Censorship Creep). È inutile chiedere la rimozione dell’hate speech se nessuno sa esattamente cosa è l’hate speech, in questo modo si delega all’azienda la decisione di cosa rimuovere e diventa del tutto soggettiva, e quindi aperta ad abusi e discriminazioni.

L’esempio più classico si ha in tema di pornografia. La giustificazione della “pornografia” è stata usata a più riprese su Facebook per censurare una marea di immagini che non avevano assolutamente nulla di pornografico (famoso il caso della Napalm Girl e quello della Venere di Willendorf), proprio perché la definizione è interna a Facebook e non ripresa da normative o leggi sui diritti umani. Una ricerca di Kate Klonich (Klonick, The New Governors: The People, Rules, and Processes Governing Online Speech) rivela come le linee guida della moderazione dei contenuti su Facebook sono rade, e i moderatori prendono decisioni in base alle proprie reazioni, con un elevata soggettività che porta a decisioni irregolari e imprevedibili.

La Protezione del Buon Samaritano, se applicata correttamente, potrebbe dare ottimi risultati. Sarebbe un incentivo alle piattaforme a moderare i contenuti, senza dover pagare prezzi eccessivi in caso di errore (sempre possibile considerata la quantità enorme di contenuti da moderare, ad esempio su Twitter ci sono 500 milioni di tweet al giorno). Ovviamente occorre che i tribunali operino un’adeguata supervisione della moderazione delle piattaforme. Nel caso in cui una decisione della piattaforma (che è presa su base contrattuale) sia impugnata dinanzi ad un tribunale, questo dovrebbe valutare una serie di elementi per stabilire se in effetti la piattaforma applica la Protezione del Buon Samaritano, come ad esempio la trasparenza delle regole e delle decisioni (quindi chiarire all’utente cosa ha violato) e così via.

Ulteriori miglioramenti sono possibili, ma deve essere chiaro che con una moderazione dei contenuti di questo tipo gli errori saranno sempre di più, in proporzione alla enorme quantità di contenuti immessi dagli utenti sui social network. Questo implica da un lato una maggiore tollerabilità agli errori commessi dai social (da cui la Protezione del Buon Samaritano) laddove la prova della “buona fede” del social dovrebbe impedire conseguenze verso la piattaforma (quindi solo il ripristino del contenuto). Dall’altro lato occorre anche introdurre obblighi di responsabilità da parte dei terzi che segnalano i contenuti alla piattaforma (vedi anche Keller, SESTA and the Teachings of Intermediary Liability). Se a seguito di una richiesta di revisione l’utente porta all’attenzione di un tribunale la contesa, e il giudice trova che il contenuto non doveva essere rimosso, è evidente che colui il quale ha segnalato il contenuto dovrà risarcire i danni all’utente (se danni ci sono stati ovviamente). Deve, quindi, essere introdotto anche un disincentivo a segnalare i contenuti per mere ritorsioni o per alimentare campagne di odio verso persone o categorie di persone.

Immagine in anteprima via Pixabay.com