Rischi e problemi nella lotta al terrorismo nell’era degli algoritmi

10 min letturaLa Commissione europea ha da poco pubblicato le linee guida (Countering illegal content online) in base alle quali gli Stati dell’Unione devono regolamentare i contenuti illeciti online. Principalmente si riferiscono a contenuti terroristici, ma le medesime regole e gli stessi strumenti si possono applicare a diversi tipi di contenuti. In particolare la Commissione sostiene che le piattaforme online devono rimuovere i contenuti estremisti entro un’ora dalla segnalazione del contenuto.

L’approccio della Commissione europea alla regolamentazione del terrorismo è sintomatico di un percorso ormai stabile nelle strategie dell’Unione europea.

Combating terrorism

Nel dicembre del 2015 (dopo gli attacchi di Parigi) la Commissione europea propone un progetto di direttiva sulla lotta al terrorismo (on combating terrorism). Il processo legislativo della direttiva è particolarmente celere, al punto che meno di un anno dopo, il 17 novembre del 2016, il Consiglio dell’Unione europea, il Parlamento e la Commissione, avevano già concluso il “trilogo”, cioè quel dialogo a tre che porta al testo finale, prima della formale adozione.

Il 16 febbraio 2017 il Parlamento adotta il testo senza ulteriori emendamenti (nonostante ne fossero stati proposti parecchi). Il 15 marzo 2017 viene adottato il testo finale. Trattandosi di una direttiva occorre che sia recepita dai vari Stati.

Al di là della necessità di strumenti per la prevenzione e la repressione del terrorismo, di una armonizzazione delle norme e della regolamentazione della cooperazione tra Stati e autorità di polizia, la direttiva in questione evidenzia numerose problematiche che si riverberano sui diritti fondamentali dei cittadini. E, considerate le ultime pubblicazioni delle massime istituzioni europee, come la Communication on Online Platforms e la recentissima Recommendation on the surveillance and filtering of the internet by online companies della Commissione europea, appare ovvio quale sia la strada che l’Europa vuole perseguire. Si tratta di un percorso iniziato anni fa col progetto CleanIt, basato sul dialogo pubblico-privato: per in Internet più “pulito”.

Tra l’altro la direttiva è stata anticipata da un Codice di condotta siglato dalle principali aziende del web, probabilmente proprio per cercare di evitare una regolamentazione più stringente.

Il testo manifesta una decisa anticipazione della tutela, criminalizzando gli atti preparatori come la formazione e il viaggio all’estero a fini terroristici, nonché l’aiuto, il favoreggiamento, l’istigazione e il tentativo di atti terroristici. Inoltre, vi è un esplicito riferimento alla necessità di punire tali condotte se poste in essere attraverso Internet, inclusi i social network (Considerando 6). La presenza di tale riferimento ad Internet appare strano, in quanto i reati penali dovrebbero essere neutrali rispetto alla tecnologia. Anche il semplice ricevere un addestramento a fini terroristici integra un reato, compreso l’auto-apprendimento anche attraverso Internet. La consultazione di materiale online potrebbe essere assimilato ad un atto terroristico.

Per distinguere tra reato (es. consultazione a fini terroristici) o comportamento innocuo (es. consultazione a fini didattici) è fondamentale la finalità. L’intenzionalità deve applicarsi a tutti gli elementi costitutivi dei reati, e “il carattere intenzionale di un’azione o di un’omissione può essere dedotto da circostanze materiali oggettive”. Nel caso, suggerisce il testo, occorre avere presente il materiale consultato e la frequenza della consultazione (Considerando 11).

Sul fronte online la direttiva sancisce che gli Stati debbano prevedere meccanismi per la rimozione di contenuti costituenti “pubblica provocazione per commettere un reato di terrorismo”. Tali misure potrebbero essere basate sull'azione legislativa o l’azione volontaria avviata dal settore di Internet (Considerando 22 e 23).

Accordi volontari

Le disposizioni della direttiva appaiono in alcuni punti generiche (non c’è una definizione di terrorismo) e non ben definite. In particolare la distinzione tra la commissione di un reato e un’attività lecita potrebbe essere lasciata all’interpretazione di chi applica la norma. In tal senso sembra possibile che ne derivino discriminazioni sulla stregua dell’identità delle persone coinvolte (un arabo, una persona di pelle scura con barba, rispetto ad un bianco) imputandogli una finalità invece di dedurla da fatti obiettivi.

Quello che però ci interessa evidenziare è l’approccio ai contenuti online. Anche qui, come in altre regolamentazioni, si parla espressamente di rimozioni online attraverso anche accordi volontari. Si tratta del medesimo approccio della direttiva copyright in discussione in questi mesi e di altre normative europee.

Leggi anche >> In nome del copyright si rischia la censura online affidata ad aziende private

L’Unione europea, infatti, si è incamminata da tempo sulla strada della privatizzazione delle regolamentazioni online, in tal modo delegando alle aziende private, le principali piattaforme che fungono da gatekeeper del web (Google, Facebook, Twitter, Microsoft), l’attività di controllo e soppressione di contenuti online. Questo approccio è ormai standardizzato per i contenuti in (presunta) violazione del copyright e viene progressivamente esteso a tutte le altre problematiche che sorgono.

Già di per sé le generiche definizioni possono portare facilmente ad abusi. Ad esempio, nella definizione di “pubblica provocazione” può facilmente farsi rientrare un dibattito politico, una polemica, un dissenso radicale. In tal modo questo strumento può essere utilizzato per silenziare il dissenso politico. La “Dichiarazione congiunta sulla libertà di espressione e le 'fake news', la disinformazione e la propaganda”, coordinata dall’Ocse, sancisce che la tutela della libertà di espressione deve includere invece anche le informazioni e le idee che possono scioccare, offendere e disturbare. La libertà di manifestazione del pensiero, infatti, si connota fin da subito per la sua dimensione politica e "antagonista", perché sono le idee antagoniste che hanno davvero bisogno di tutela, non quelle comunemente diffuse.

Il fatto, poi, che tale valutazione sia demandata a un'azienda che si preoccupa per lo più dei propri interessi economici (e non dei diritti dei cittadini) amplifica il problema, in quanto l’azienda tenderà a rimuovere il più possibile piuttosto che rischiare di doverne pagare le conseguenze*. Un esempio di possibili ricadute sulla libertà di espressione lo abbiamo avuto in Francia nel 2015, dove un sedicenne fu indagato per “apologia del terrorismo”, avendo pubblicato “un personaggio con un giornale Charlie Hebdo, crivellato da proiettili, il tutto accompagnato da un commento ironico”. Anche un ragazzo di soli 8 anni fu coinvolto in un’indagine per aver fatto dei commenti a scuola.

Leggi anche >> TwitterJokeTrial, il dissenso sociale e le leggi speciali per regolamentare la Rete

A tal proposito ricordiamo che la Carta dei diritti fondamentali dell’Unione europea, oltre a essere molto vaga, si applica alle misure attuate dalla Commissione europea e agli Stati che applicano il diritto dell’UE, non alle misure imposte “volontariamente” dalle società private. Cioè un intermediario della comunicazione ben potrebbe, in base ai suoi termini di servizio (policy), rimuovere contenuti online senza tenere in considerazione tali diritti.

Il monitoraggio generale non è generale

Altro aspetto interessante è che la direttiva sancisce espressamente che la rimozione di contenuti online che costituiscono una pubblica provocazione “non dovrebbe pregiudicare le disposizioni della direttiva 2000/31/CE del Parlamento europeo e del Consiglio. In particolare, non dovrebbe essere imposto ai fornitori di servizi alcun obbligo generale di sorveglianza sulle informazioni che trasmettono o memorizzano né di ricercare attivamente fatti o circostanze che indichino la presenza di attività illecite. Inoltre, i fornitori di servizi di hosting non dovrebbero essere considerati responsabili a condizione che non siano effettivamente a conoscenza del fatto che l’attività o l’informazione è illecita e non siano al corrente di fatti o di circostanze che rendono manifesta l’illegalità dell’attività o dell’informazione”.

In sostanza la direttiva non dovrebbe eliminare l’esenzione di responsabilità a favore degli intermediari della comunicazione.

In realtà, la medesima situazione si riscontra con la direttiva copyright (qui il link al testo di compromesso del Parlamento europeo) che include l’obbligo di attivare un sistema di filtraggio a carico delle piattaforme online. Questo strumento dovrebbe verificare i contenuti caricati dagli utenti della piattaforme e bloccare quelli che i titolari del copyright segnalano. Di fatto è un monitoraggio generale in contrasto con la direttiva eCommerce (2000/31/CE).

Leggi anche >> Internet e filtri: una forma di censura che mette a rischio le democrazie

Il testo di compromesso della direttiva copyright sostiene che il controllo di tutti i caricamenti degli utenti per stabilire se sono identici all’opera protetta da copyright di un particolare detentore di diritti non costituisce un monitoraggio “generale” ma sarebbe “specifico”. Questo perché, appunto, la normativa europea vieta il monitoraggio generale (come stabilito anche da due sentenze della CGUE), ma lo ammette in casi specifici (Considerando 47 e 48 della direttiva eCommerce). Il considerando 48 consente agli Stati di prevedere “doveri di diligenza” al fine di individuare e prevenire determinati tipi di attività illegali, come sancito anche dalla IPRED (direttiva 2004/48/CE, sul rispetto dei diritti di proprietà intellettuale), che impone agli Stati membri di garantire che i tribunali possano emettere ingiunzioni nei confronti di intermediari per prevenire le infrazioni.

Con la riforma della direttiva copyright si tende a valorizzare il Considerando 48, ignorando che l’articolo 15 della direttiva eCommerce è chiara nello stabilire un divieto di controlli generalizzati, come quelli che si vorrebbero prevedere. E non è che dire che è “specifico” fa diventare un monitoraggio generale “specifico”.

Leggi anche >> La sorveglianza di massa in Europa è illegale

Con la direttiva sul terrorismo, quindi, abbiamo lo stesso problema, cioè la possibile delega tramite accordi volontari alle piattaforme del web, che rimuoveranno i contenuti “terroristici” in base alle loro policy e non in base a norme giuridiche. In tal caso, quindi, non avranno l’obbligo di rispettare i diritti fondamentali dei cittadini. Infatti, nella direttiva non sono previste né salvaguardie né rimedi effettivi per la violazione dei diritti fondamentali e questo filtraggio dei contenuti (che ovviamente sarebbe attuato tramite algoritmi software principalmente) di fatto è un monitoraggio “generalizzato” in contrasto con la direttiva eCommerce.

Firma terroristica

Un altro aspetto che ci preme evidenziare è che l’approccio alla ricerca dei terroristi oggi è completamente diverso rispetto al passato.

Con il passaggio a sistemi di ricerca e indagine basati su algoritmi, oggi per identificare un terrorista basta una semplice “firma”. Venendo meno, nell'attività algoritmica, l’obbligo di avere un obiettivo identificato (target), con la "datificazione" del terrorista quello che si prende di mira è la “firma” (signature).

Quindi non sono presi di mira degli individui identificati (target) preventivamente, bensì il comportamento di soggetti osservati per giorni, senza conoscerne l’identità. Se il loro comportamento si adatta allo schema ritenuto tipico di un terrorista, si stabilisce di essere in presenza di un’organizzazione terrorista e si prendono i provvedimenti del caso, compreso l’uccisione di persone senza sapere chi realmente siano (signature strike).

Ad esempio, se delle persone sono viste con armi in prossimità di un luogo frequentato da terroristi, oppure se sono viste comunicare con terroristi, o dare ordini a terroristi. È anche possibile che l’algoritmo confonda e riunisca in un unico individuo il comportamento di più soggetti che abitano lo stesso appartamento.

Gli attacchi in base alla “firma” rendono impossibile sostenere che si è fatto tutto il possibile per verificare che si stia attaccando solo obiettivi militari, proprio perché tali obiettivi non sono identificati. Diventa alto, quindi, il rischio di ferire o uccidere civili.

Un terrorista oggi non è più una persona, quanto un modello (type) ricavato dalla "datificazione" di una serie di comportamenti tipici di soggetti ritenuti terroristi. I dati (comportamenti) da estrarre sono selezionati dai programmatori del modello, quindi alla fine il modello di terrorista non descrive affatto un terrorista quanto piuttosto come un terrorista è visto dal programmatore. La costruzione di un modello ideale non si basa sulla realtà ma è un'approssimazione di un fenomeno dinamico, la traduzione in una quantità di numeri trattabili da un software.

In tal senso la costruzione di un modello di terrorista (ma anche di altre tipologie) non è l’estrazione di dati dalla realtà (raw data), quanto la costruzione di dati a partire dall’osservazione della realtà (cooked data). E, come tale, è soggetta a molteplici errori e fenomeni discriminatori.

Sorveglianza e controllo

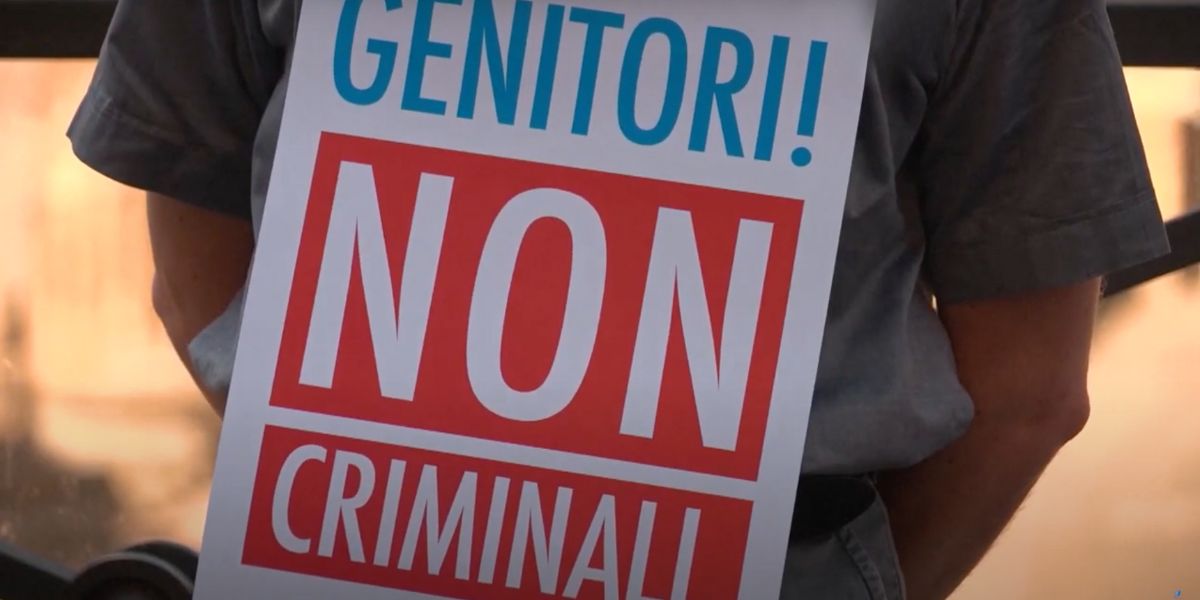

La direttiva sul terrorismo, quindi, oltre a espandere eccessivamente il concetto di “terrorismo”, inglobando comportamenti innocui che vengono però criminalizzati in base all’“intenzione”, finisce per limitare notevolmente i diritti dei cittadini e in particolare la libertà di manifestazione del pensiero online, consentendo la rimozione di contenuti di protesta e di disobbedienza civile.

È pacifico che il contrasto a fenomeni criminali e terroristici, ovviamente, non può che affievolire le libertà dei cittadini, ma è altrettanto evidente che non può portare a un'indiscriminata compressione di tali libertà e a un controllo capillare e generalizzato delle informazioni che fluiscono in rete. Occorre ricordare che Internet è solo uno strumento, utilizzato anche per la commissione di delitti, ma non è né la causa né la proliferazione degli stessi. Il fenomeno terroristico non dipende tanto dalla propaganda online quanto piuttosto dal controllo militare di determinati territori.

Paradossalmente focalizzare l’attenzione sull’aspetto digitale finisce per affievolire l’attenzione sulle condotte reali e sulle reali cause delle stesse. Una regolamentazione focalizzata sulla rete Internet, distrae la popolazione dai “problemi”, facendo in modo che il legislatore si presenti attivo e preoccupato per i cittadini, così ottenendo la giustificazione di forme di controllo della rete funzionali ad una repressione del dissenso politico.

Inoltre, l’uso di algoritmi, sia come filtri di contenuti online che come software di “ricerca” di terroristi è ampiamente soggetto a errori. Nel primo caso si finisce per rimuovere anche ciò che è perfettamente lecito e legale, nel secondo caso si incarcerano o addirittura uccidono persone che non hanno commesso alcun crimine.

L’approccio odierno si basa non più su un modello punitivo ex post (repressione del reato) quanto sull’applicazione di un modello di prevenzione ex ante, caratterizzato dalla sorveglianza capillare del web e il filtraggio dell’attività degli utenti in rete. Laddove tale sorveglianza e filtraggio sono poi delegati alle aziende private.

Si tratta di un modello di regolamentazione che evidenzia numerosi problemi:

1) Regolamentazione fissata senza dibattito democratico, a porte chiuse, in un dialogo pubblico-privato che si trasfonde nelle policy delle aziende (non negoziabili).

2) Sostanziale privatizzazione delle regole, con possibile compressione dei diritti civili (si rimuove spesso senza vere e proprie valutazioni e senza offrire rimedi a tutela dei diritti), e lesione della norme anticoncorrenziali (gli oneri di rimozione costituiscono barriere all’ingresso del mercato delle piattaforme online).

3) Sopprimendo discorsi online si eliminano occasioni di dibattito e discussione, che sono il vero sale delle crescita sociale.

4) Cancellazione di elementi utili alle indagini.

*Nota:

In merito alle rimozioni di contenuti in presunta violazione del copyright esistono evidenze che tali rimozioni portino a cancellare numerosi contenuti leciti. Secondo un rapporto del 2016 Google riceve richieste di rimozione per 24 milioni di collegamenti a settimana per il suo motore di ricerca web. Ciò equivale a 1,25 miliardi di collegamenti all'anno. Google rimuove circa il 97,5% dei link richiesti per la rimozione. Tuttavia, uno studio su un campione di richieste di rimozione ha rilevato che oltre il 28% dei collegamenti segnalati potrebbero non essere illeciti. Il 4,2% dei link segnalati indicavano contenuti completamente estranei all'opera protetta da copyright in questione, un gran numero di link segnalati era molto probabilmente protetto da eccezioni al copyright, e alcuni dei link segnalati non sono mai esistiti. Considerate che il 28% si traduce in circa 350 milioni di link a contenuti legittimi rimossi in un anno. E il numero di link segnalati per la rimozione aumenta esponenzialmente ogni anno.

Foto via Christiaan Colen/Flickr (CC BY SA 2.0)