Il riconoscimento facciale e delle emozioni: pseudoscienza in contrasto con i diritti umani

10 min letturaIn India, la capitale dell’Uttar Pradesh, Lucknow, ha un problema con i crimini contro le donne. Nel 2018 la città, definita orgogliosamente “la città d’oro dell’Est” e “la Costantinopoli d’India”, luogo multiculturale di poesia e musica, risultava al primo posto tra le città del paese nei dati del National Crimes Record Bureau del 2018, con una media di sette crimini contro le donne al giorno. Crimini in constante crescita, del 10% l’anno negli ultimi due anni, in cui peraltro erano coinvolti anche amministratori locali e politici del BJP, il partito nazionalista del primo ministro Narendra Modi — si legge in un articolo di The Wire a gennaio 2020.

Anche nel 2019 la regione si è confermata la più pericolosa per le donne in tutto il paese, ha scritto il Times of India. Non esattamente un bel biglietto da visita per un corpo di polizia che vanta “una gloriosa tradizione nel mantenere comunità e società in armonia”, all’insegna del consueto slogan nazionalista del “law and order”.

Il governo è così corso ai ripari. Prima, nell’ottobre del 2020, lanciando un programma di sicurezza apposito per il contrasto dei crimini contro le donne, chiamato “Mission Shakti”, che ha portato a 14 condanne a morte per crimini contro donne e bambini. E poi, nei giorni scorsi, sostanziandolo con l’aiuto di quella che sempre più appare la soluzione, o presunta tale, a ogni problema sociale: l’automazione.

Algoritmi contro lo stalking: il piccione e la scacchiera

L’annuncio è toccato al commissario di polizia, Dhruv Kumar Thakur: saranno algoritmi di riconoscimento facciale a estirpare, una buona volta, il problema alla radice. Equipaggiati sulle videocamere di sorveglianza in 200 postazioni in tutta la metropoli (oltre 3,5 milioni di abitanti) e considerate, sulla base dei crimini passati, a rischio, saranno in grado di riconoscere le espressioni delle donne che verrano inquadrate. E, nel caso si tratti di espressioni del volto che indicano “pericolo” o “infelicità”, anche di allertare immediatamente la più vicina stazione di polizia, “prima ancora che possano estrarre il telefono e comporre il 110 o il 112”, dice Thakur. “Le telecamere si attiveranno non appena l’espressione del volto di una donna in pericolo cambi”.

Il progetto riguarderà inizialmente solo cinque delle telecamere utilizzate, ma secondo il commissario ciò consentirà, nel tempo, di rendere (finalmente) Lucknow una “città sicura per le donne”. Ma è così?

Diversi esperti in India ne dubitano. Il docente del Center for Policy Studies dell’IIT di Bombay, Anupam Guha, ha espresso tutta la sua disapprovazione in un durissimo thread su Twitter in cui ha sostenuto di ritenere l’idea, “come scienziato che si occupa di AI” e anzi “come essere umano”, “talmente idiota, talmente errata, e talmente potenzialmente dannosa” da affermare che “anche solo rispondervi da accademico è impossibile”. Sarebbe “come cercare di giocare a scacchi contro un piccione che sta defecando sulla scacchiera”.

Le ragioni che motivano un giudizio tanto severo, in effetti, sono chiare, e condivise da diversi colleghi interpellati dalla stampa indiana. Prima di tutto, non si capisce come farebbe il sistema a distinguere espressioni infelici o di pericolo dovute a possibile stalking o altri crimini da quelle suscitate, invece, da qualunque altro aspetto della vita di una donna. “Potrei stare parlando con un amico, potrei arrabbiarmi per qualunque ragione” (una questione professionale, un litigio col partner), dice Anuskha Jain, della no profit Freedom Foundation, aggiungendo inoltre che “non sappiamo nemmeno quali espressioni”, più precisamente, “stiano venendo tracciate” e dunque attivino il sistema.

Allo stesso modo, non si capisce nemmeno bene quali uffici di polizia deterranno quali dati, in che modo e secondo quali regole, vista l’assenza di una normativa dedicata in materia — sollevando dunque anche questioni di tutela di dati personali tra i più sensibili in assoluto. Una questione anche più delicata in un paese in cui le forze di polizia dispiegano tecnologie di riconoscimento facciale — insieme a blackout indiscriminati di Internet — per contrastare le proteste degli agricoltori in corso da mesi nel paese, identificando e punendo i manifestanti.

Ma le obiezioni di fondo sono ben più profonde, e hanno radici insieme scientifiche e geopolitiche. Perché l’idea che sta al fondamento dell’intervento della polizia di Lucknow non è solo sistematicamente errata secondo ogni evidenza a nostra disposizione dalla letteratura accademica: è anche errata nel modo in cui è errata una precisa idea di “armonia sociale”. Quella cinese.

Mostra che senti e ti dirò chi sei: il rapporto di Article 19 sul modello cinese

Per comprenderlo davvero, ci viene in aiuto uno splendido e inquietante rapporto appena pubblicato dalla no profit Article 19, che ha studiato — in oltre 70 pagine — come il riconoscimento delle emozioni, che viene presentato come una inevitabile “evoluzione” del riconoscimento facciale, abbia il suo motore propulsivo in Cina.

Nel rapporto, intitolato ‘Emotional Entanglement: China’s emotion recognition market and its implications for human rights’, si precisa infatti fin dal principio il duplice ed esiziale errore che affligge ogni tentativo di mettere a frutto tecnologie di riconoscimento delle emozioni. Riporto parola per parola, nella mia traduzione, quanto riassume Article 19, perché è straordinariamente chiaro:

“Le tecnologie di riconoscimento emotivo sono basate su due assunti fondamentali.

Il primo è che sia possibile valutare le emozioni interiori di una persona dalla loro espressione esteriore.

La seconda è che tali emozioni interiori siano sia discrete che espresse in modo uniforme in tutto il mondo.

In entrambi i casi, è vero l’opposto.

Le espressioni facciali non sempre riflettono le nostre emozioni interiori. Restare impassibili o sorridere quando si è tristi sono prassi comune. In altre parole, le persone mascherano o reprimono spesso le loro emozioni, perciò le espressioni facciali possono dirci molto poco rispetto a quanto siano realmente felici, sorprese, disgustate, tristi, arrabbiate o impaurite.

In secondo luogo, le emozioni sono varie, sfumate e complesse quanto le persone. Le norme culturali e sociali le influenzano alla radice. Per esempio, se in una cultura la nudità può essere fonte di vergogna o disgusto, in un’altra può essere elevata a forma d’arte. Per questo, le espressioni facciali assumono significato quando sono mediate dalla cultura.

Affermando di inferire i “veri” stati interiori, e prendendo decisioni sulla base di queste inferenze, le tecnologie di riconoscimento emotivo finiscono per consolidare assunti arbitrari circa gli individui, facendone verità fondanti”.

E tutto questo trova conferma a livello scientifico, ricorda un ottimo pezzo di Rest of World, in studi su studi, tra cui una meta-analisi che giunge alle stesse conclusioni dopo averne valutati “oltre mille”. Insomma, se negli anni ’60 le teorie di Paul Ekman sulle “micro-espressioni”, risposte subitanee a stimoli che avrebbero dovuto rivelare le reali emozioni di un soggetto, potevano ancora avere un qualche fondamento, oggi sembrano definitivamente contraddette, sostiene il rapporto di Article 19.

Naturalmente tutto questo non impedisce a chi voglia servirsene per motivi di propaganda e controllo sociale, e dunque politicamente e per comunicare al mondo un’immagine di sé innovativa e “smart”. Non a caso i ricercatori della no profit inglese sottolineano più volte il ruolo che i media cinesi giocano nella diffusione di presupposti errati, ma utili a sostenere la vulgata del regime di Xi Jinping secondo cui l’armonia della società passa necessariamente per l’AI, i Big Data e la sorveglianza digitale pervasiva.

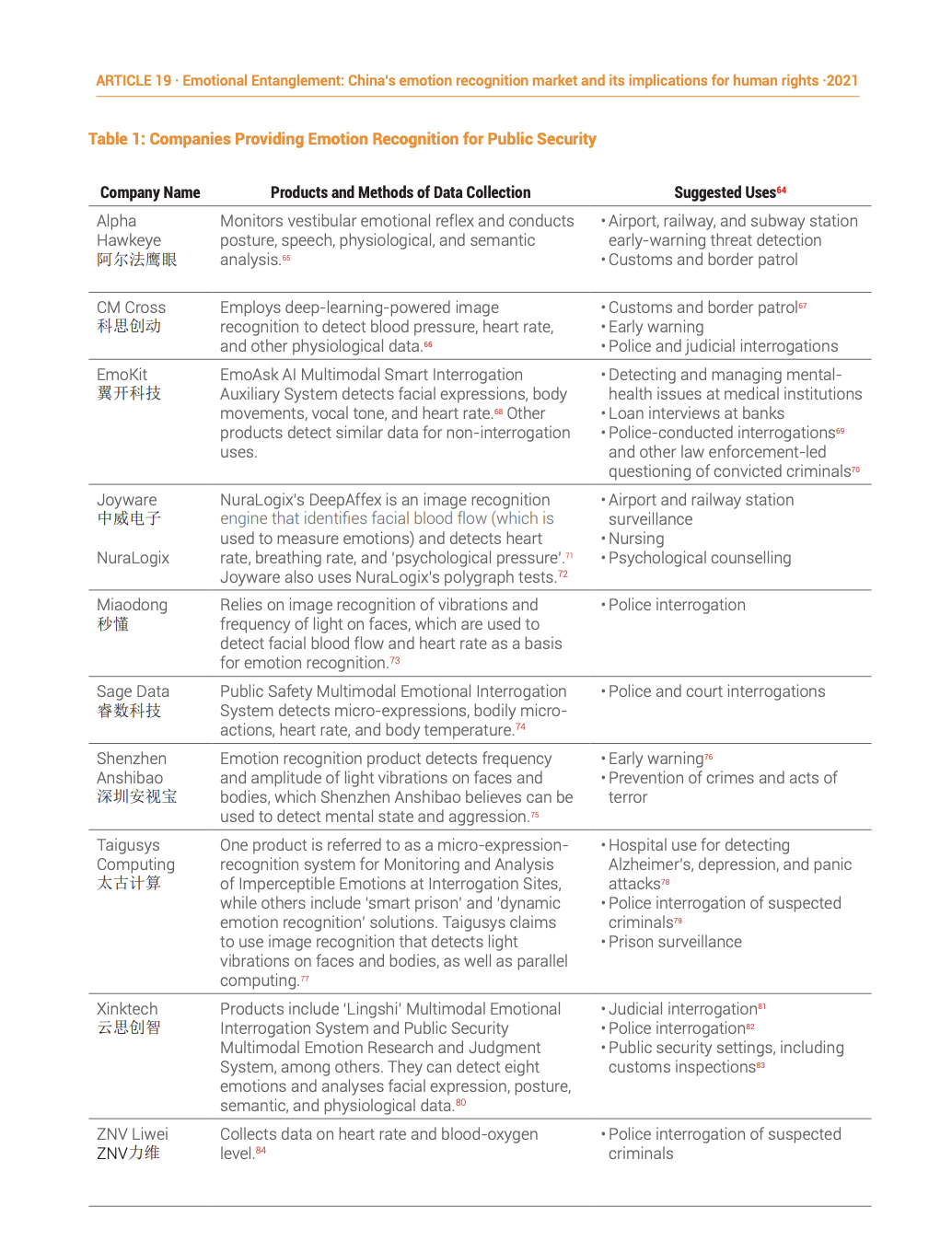

Si moltiplicano così, nonostante i sistemi siano essenzialmente basati su pseudoscienza, gli usi: per la sicurezza pubblica, portando per esempio all’arresto di “153 cosiddetti “criminali””, scrive Article 19, alla stazione ferroviaria di Yiwu già tra il 2014 e il 2015. Ma gli usi ipotizzati, anche solo in materia di sicurezza, sono molteplici:

Diversi sono poi gli usi anche per quanto riguarda il settore assicurativo. Sistemi di riconoscimento delle emozioni stanno venendo equipaggiati sulle automobili, si legge, così da poter fornire alle compagnie assicurative un resoconto dello stato emotivo e delle emozioni espresse dal guidatore in caso di incidente. Il sistema DRVR (Driving Risk Video Recognition) di Ping An Group, per esempio, afferma di essere in grado di identificare “colpi di sonno, fumare, giocare con lo smartphone, cambiare corsia senza prestare attenzione, ed eccessi di velocità”.

Alcuni sistemi di questo tipo sono anche predittivi, sostenendo per esempio di essere in grado di predire dalle “micro-espressioni” dei guidatori quali avranno maggiore probabilità di tentare di non pagare la tariffa autostradale, e perfino di fornire una “early detection” di quali potrebbero rappresentare una minaccia per gli operatori al casello.

Ma sono le applicazioni nel sistema educativo e scolastico a rappresentare la più forte ragione di preoccupazione — in molti casi, perfino per i cittadini cinesi, che non hanno mancato di sollevare voci critiche e di protesta. Già prima che il COVID-19 popolarizzasse i software di proctoring che trasformano ogni studente in una cavia da sorveglianza continua anche in Occidente, in Cina erano in corso diversi esperimenti per misurare livelli di concentrazione e attenzione degli alunni in classe, con tanto di sistemi a punteggio algoritmici, e per riconoscere le emozioni manifestate durante le lezioni — e trarne le debite conseguenze.

Taigusys Computing, per esempio, fornisce una piattaforma di interazione docente-studente che allerta in caso di studenti tristi o impauriti — il tutto tramite un software che viene impiegato in prigione e per gli interrogatori con criminali veri e propri, nota il rapporto.

I software si spingono fino a sostenere di essere in grado di proteggere gli studenti dalle emozioni sbagliate, e a fornire ai genitori degli alunni un modo per verificare che gli insegnanti siano in grado di fare il loro lavoro come si deve — dando loro l’illusione che se il sistema classifica un alunno come felice o integrato, allora lo sia davvero; e cercando di diffondere l’ulteriore illusoria nozione che l’insegnamento sia questione di pura efficienza, qualcosa di inevitabilmente e infallibilmente quantificabile. Non solo: diffonde l’idea che non siano gli algoritmi di riconoscimento, le vere e proprie “black box” inconoscibili, ma le classi; e che siano queste ultime a dover diventare un flusso ininterrotto e trasparente di dati, e non gli algoritmi stessi, che invece possono rimanere opachi e controllati solo dai produttori.

Tutto questo, come si può vedere dalla (contestata) sperimentazione in un liceo di Hanghzou, protagonista lo Smart Classroom Behaviour Management System del colosso del settore Hikvision, porta già ad alcune modificazioni comportamentali inquietanti negli studenti. Alcuni, si legge secondo loro stesse dichiarazioni, cominciano a temere le proprie reazioni emotive, nel terrore che qualcuna possa essere giudicata non conforme dal sistema, e dunque risultare in una penalizzazione dal punto di vista del rendimento scolastico. “Da quando sono stati installati gli “occhi intelligenti” in classe”, si legge in una dichiarazione di uno studente, “non ho più osato distrarmi mentalmente”.

Bene, se si pensa che gli studenti siano macchine da voti; male, se li si considera esseri umani.

Qualcuno, in effetti, ha protestato; sistemi simili sono ancora l’eccezione, non la norma; e alcuni istituti, per esempio a Shenzen, si sono rifiutati di adottare sistemi di questo tipo sulla base di considerazioni di privacy.

Ma è improbable che questo tipo di opposizione riesca a impedire davvero che si diffondano, in un futuro prossimo. Troppe, scrive il rapporto, sono le opportunità di mercato, troppo il prestigio ancora associato all’idea di stare innovando per primi; e troppo ingenti i sussidi da governi locali desiderosi di godere del ritorno d’immagine.

Riconoscimento emotivo contro diritti umani: perché va fermato subito

Il punto fondamentale del rapporto di Article 19, e che si lega al caso illustrato per la democrazia indiana, è che questi sistemi non sono solo fondati su pseudoscienza (e un sacco di hype tecnologico orientato al marketing molto prima che al benessere sociale), ma sono anche e soprattuto in “fondamentale contrasto” con i diritti umani.

E non solo in termini di privacy. I sistemi di riconoscimento emotivo limitano anche la libertà di espressione degli individui, costretti a comportarsi come si aspettano gli algoritmi di riconoscimento emotivo — o patire le conseguenze della loro difformità ai loro arbitrari assunti: “L’idea di essere non solo visti e identificati”, come fa il riconoscimento facciale, “ma anche giudicati e classificati, funge da meccanismo intimidatorio”, si legge nel rapporto, “per rendere gli individui conformi alle “buone” forme di auto-espressione” incastonate nei software di controllo, “a meno che non si voglia finire classificati come “sospetti”, “rischiosi”, “addormentati” o “disattenti””.

Come visto in India, sistemi di questo tipo possono facilmente portare a repressione del diritto alla protesta e alla libera riunione, nonché stravolgere il principio per cui non si può essere costretti ad auto-incriminarsi, per esempio perché rimanere in silenzio potrebbe non bastare per impedire a un sistema algoritmico di formulare la nostra colpevolezza sulla base delle reazioni o “micro-reazioni” del nostro volto durante un interrogatorio.

Da ultimo, e come per il riconoscimento facciale in genere, le discriminazioni — e contro le categorie già maggiormente discriminate — non sono ipotesi, ma certezza: “Questa tecnologia”, scrive Article 19, “è pronta per portare a discriminazioni, dato che gli individui che non si conformano alle norme che guidano le sue fondamenta pseudoscientifiche (per esempio, persone di colore, transgender, e individui non-binary) finiranno per essere sorvegliati, tracciati e giudicati in maniera sproporzionata”.

Che fare di fronte a tutto questo? Per noi europei, un primo passo sarebbe non fungere da modello, come invece avvenuto (pur se ipocritamente, dato che in Cina è stato raccontato come caso di successo quando invece non lo è affatto) per il sistema iBorderCtrl, che pur se in via sperimentale accoppiava riconoscimento facciale ai confini con un lie detector a punteggio algoritmico.

Molto meglio seguire le recentissime indicazioni del Consiglio d’Europa, che in materia di riconoscimento facciale ed emotivo ha recentemente emesso delle linee guida che chiedono, molto semplicemente, che questi sistemi siano messi al bando:

“L’uso di sistemi di riconoscimento facciale per lo scopo esclusivo di determinare il colore della pelle di una persona, il suo orientamento religioso o in materia di altre credenze, il suo sesso, la sua origine etnica o razziale, la sua età, la sua condizione di salute o sociale dovrebbe essere proibito a meno che non siano fornite adeguate salvaguardie di legge in grado di prevenire qualunque rischio di discriminazione”.

“Allo stesso modo”, si legge ancora, “sistemi di riconoscimento delle emozioni (“affect recognition”) si possono realizzare attraverso tecnologie di riconoscimento facciale per provare a riconoscere tratti della personalità, emozioni interiori, stati mentali o coinvolgimento di un lavoratore. Collegare questa attività di riconoscimento a emozioni, per esempio in processi di assunzione (come realmente avvenuto, ndr), nell’accesso a sistemi assicurativi o educativi può porre rischi che arrecano grande preoccupazione, sia a livello individuale che sociale, e dovrebbero essere proibiti”.

Una posizione, quella del Consiglio d'Europa, su cui è ragionevole ritenere stia avendo un peso anche la campagna di attivismo in corso a livello europeo, "Reclaim Your Face", che lega espressamente l'uso per sorveglianza di massa biometrica di tratti comportamentali ed emotivi alla perdita di dignità dei cittadini europei e alla loro disumanizzazione, e di conseguenza ne chiede la messa al bando.

Alle stesse conclusioni era già giunto un rapporto di AI Now a dicembre 2019, oltre a quello estesamente citato di Article 19, che è perfino più secco nella formulazione:

“Mettete al bando progettazione, sviluppo, vendita e uso delle tecnologie di riconoscimento emotivo con effetto immediato”.

In un mondo in cui perfino una rivista del gruppo Nature, Scientific Reports, pubblica paper che sostengono di poter risalire da un’immagine del volto a un orientamento politico, si tratta di una priorità di policy assoluta.

Immagine anteprima © Andrey Popov - Dreamstime.com