I problemi e i rischi del riconoscimento facciale tra Cina e resto del mondo

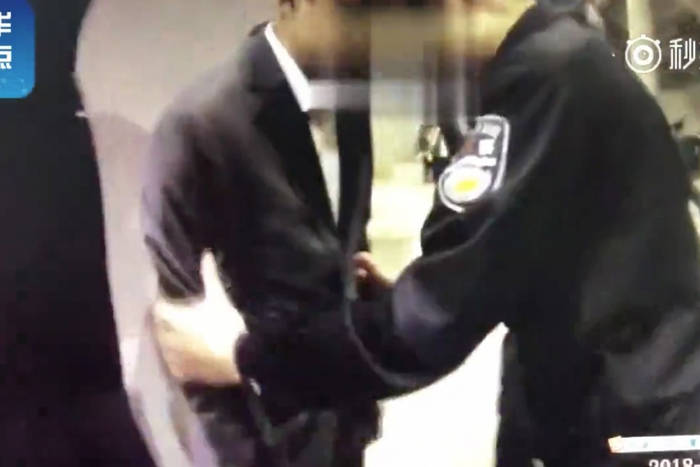

16 min letturaJiangxi, Cina sud orientale. 7 aprile 2018. Ao ha guidato per circa 100 chilometri per seguire, insieme alla moglie, il concerto dell’idolo pop Jacky Cheung. È tranquillo perché sa che all’International Sports Center di Nanchang ci sarà tantissima gente. È buio quando inizia il concerto, e Ao è seduto a godersi lo spettacolo: un'orchestra live di 31 elementi, 30 ballerini ed acrobati, e un palco visibile a 360 gradi.

Mentre il pubblico intona insieme a Cheung il ritornello di un pezzo romantico, un paio di agenti si fanno largo tra le persone accalcate con passo deciso. Si avvicinano al trentunenne Ao e lo afferrano. L’uomo è visibilmente sorpreso. Forse un errore? No, sanno perfettamente chi è e che è ricercato per crimini economici. E lo hanno scovato tra 60mila persone. Di notte.

Sharp Eyes

Il sistema di riconoscimento facciale della Megvii Inc. è la tecnologia che ha consentito l’arresto del trentunenne cinese (accusato di non aver pagato un carico di patate) nonostante egli si sentisse relativamente sicuro in una vasta folla. Ma non è l’unico già attivo in Cina. Una delle aziende più quotate del settore è SenseTime (Shangtang in cinese), la startup di intelligenza artificiale più promettente, stimata nel 2018 circa 4,5 miliardi di dollari. Un “unicorno”, cioè un’azienda con valutazione superiore al miliardo, con una crescita del 400% in appena tre anni.

La sede principale di SenseTime si trova a Pechino. Gli uffici sono eleganti. All’ingresso un pannello funge da specchio digitale, una telecamera analizza il tuo viso per stimare l’età e assegnare un rating di attrattiva. Un secondo schermo trasforma il tuo viso come un filtro, snellisce la figura, allarga gli occhi, e così via. Un terzo schermo mostra le immagini del vicino incrocio stradale. Alle persone e ai veicoli sono sovrapposte delle etichette: maschio, adulto, pantaloni grigi, ecc… . Il personale non usa badge, le telecamere riconoscono lo staff e aprono le porte automaticamente. L’intero edificio sembra una prova di ciò che dovrebbe essere la Cina del futuro.

SenseTime lavora a stretto contatto con il governo. Il sistema utilizza milioni di foto per riconoscere in tempo reale le persone in the wild, cioè in situazioni “non collaborative”, per capirci nella vita reale quando non si mettono “in posa”. Ma il sistema non si limita alle persone, analizza anche i veicoli. Su uno schermo vengono sovrapposti i dettagli riconosciuti alle immagini. Il software può abbinare un sospetto con un database criminale, e se il livello di somiglianza supera una certa soglia il soggetto può essere arrestato direttamente.

SenseTime non si occupa solo di riconoscimento facciale (SenseFace), ma esplora le varie possibilità dell’AI: SenseMedia è una piattaforma in grado di moderare video e immagini inappropriati, SenseFoundry è una piattaforma dedicata per Smart City, SenseDrive una soluzione per la guida autonoma.

SenseTime è considerata uno dei campioni nazionali, una delle cinque aziende cinesi più importanti. In Cina ci sono oltre 180 milioni di telecamere. L’idea è di porre il riconoscimento dei volti al centro di tutti i sistemi, da quelli di sicurezza a quelli di acquisto: non è necessario avere un documento di identità, non serve avere denaro con sé, né una carta di imbarco, tutto quello che occorre è mostrare il proprio volto.

Il governo cinese e i funzionari di polizia sperano di utilizzare la tecnologia di riconoscimento facciale non solo per rintracciare i sospetti, ma anche per prevenire i reati, perfino per prevederli. Il punto di arrivo sarà un sistema di sorveglianza totale che tracci costantemente e in tempo reale i movimenti di 1,4 miliardi di cinesi, negli aeroporti e nelle stazioni, per le strade, nei negozi, nei centri commerciali, anche nei bagni pubblici. I poliziotti saranno dotati di occhiali con tecnologia di riconoscimento facciale. Questo è Sharp Eyes (Xue Liang in cinese), “occhi acuti”, come nello slogan del partito comunista: il popolo ha gli occhi acuti.

È la base del sistema di credit score cinese, un sistema di controllo pervasivo ed onnisciente che raccoglierà i dati dei database criminali, medici e accademici, dei PNR (prenotazioni di viaggio), degli acquisti, dei commenti sui social media, tutti riuniti in un unico profilo con i dati anagrafici e comportamentali dell’individuo. Tracciare chiunque, dovunque: dove sono, con chi sono, cosa fanno, cosa pensano.

L’essenza di Sharp Eyes è la riprovazione sociale. Un cittadino appicca il fuoco a un cumulo di rifiuti, una telecamera lo riprende e un altoparlante gli ordina di spegnere l’incendio. Il suo nome poi verrà pubblicato sugli schermi agli incroci più trafficati. Tutti sapranno chi è il colpevole, così non oserà farlo di nuovo. L’obiettivo è di ridurre i reati, eliminare la corruzione. Ma ovviamente il rischio è di colpire i dissidenti, le voci fuori dal coro. La sorveglianza a livello locale è facilmente abusata, diventa una forma di controllo sociale. Parteciperesti ad una protesta di piazza sapendo che il tuo volto sarà scansionato e registrato e inserito nei database della Polizia? Anche i cittadini che attraversano la strada quando non devono (jaywalker) vedono i loro nomi pubblicati sui tabelloni di riprovazione. E nei bagni pubblici il sistema è utilizzato per impedire il furto della carta igienica.

Un altro punto di Sharp Eyes sta nel mobilitare i comitati di quartiere, residenti che possono accedere alle telecamere dai loro televisori oppure dagli smartphone, e fungere da occhi per il governo stesso. Nel caso, possono allertare la polizia direttamente. Una rivisitazione tecnologica del “See something, say something” americano, la campagna del Dipartimento di Homeland Security basato sulla “responsabilizzazione” dei cittadini, incitandoli a controllare gli altri. A denunciare gli altri.

Far West

Perché se in Cina il sistema di sorveglianza e controllo è voluto e regolamentato direttamente dal governo, ed è palese per quali scopi il governo lo usa, in altri paesi il riconoscimento facciale è utilizzato ugualmente. Ma talvolta senza regole certe, senza una “direzione” dall’alto, senza trasparenza.

Il primo arresto di un americano basato esclusivamente sul riconoscimento facciale è del 2013. Nel febbraio aveva rapinato un uomo su un treno della Chicago Transit Authority, e il suo volto era stato catturato dalle telecamere di sorveglianza, e poi confrontato con il database del Dipartimento di Polizia di Chicago. Infine, riconosciuto dai testimoni è stato condannato a 22 anni di carcere per rapina a mano armata.

Il riconoscimento facciale nasce come tecnologia militare, ed è stato testato dagli americani in Afghanistan e Iraq. I dati biometrici di oltre 1,5 milioni di afghani sono stati inseriti in banche dati gestite da americani. In Iraq è stata registrata una fetta ancora più ampia della popolazione.

L’FBI americano utilizza almeno dal 2011 il riconoscimento facciale per confrontare le immagini delle scene del crimine con un database nazionale di foto segnaletiche. Le forze di polizia degli Stati Uniti utilizzano software di AI da diversi anni per allocare le risorse e prevedere i crimini, e da qualche anno tali sistemi sono affiancati da software di riconoscimento facciale. L’NSA americana almeno dal 2010 estrae immagini dal flusso Internet che poi utilizza nel suo sistema di riconoscimento facciale. A tali immagini vengono associate delle informazioni, ad esempio se il soggetto si trova nelle NoFly list, lo status del passaporto, i visti, eventuali associazioni con sospetti o legami terroristici, oltre i report delle agenzie di intelligence. L’Autorità Portuale di New York e gli altri azionisti del World Trade Center hanno installato un sistema di sorveglianza di grado militare, incluso sistemi di riconoscimento facciale, scanner e telecamere automatizzate per rilevare “movimenti insoliti” e prevenire attentati. Il riconoscimento facciale è stato usato per le persone che si trovano fuori i cancelli della Casa Bianca.

Anche nel settore privato questa tecnologia sta facendo proseliti. I casinò di Las Vegas sono stati tra i primi ad abbracciare le tecnologie di sorveglianza, le telecamere sono presenti anche nelle camere di AirBnb. Nel 2018 la cantante Taylor Swift ha usato il riconoscimento facciale durante i suoi concerti.

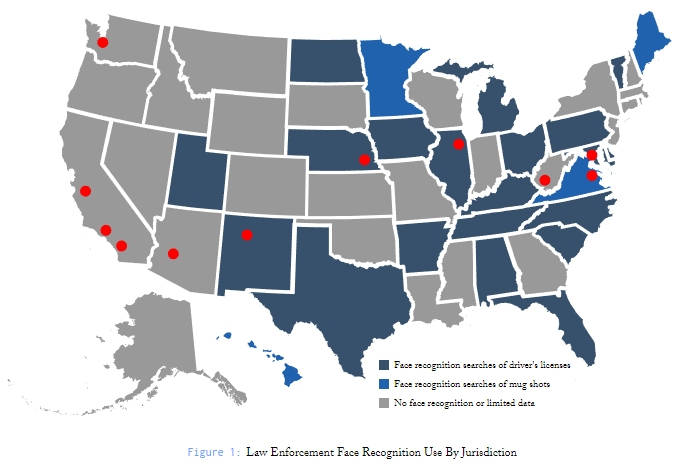

Nel 2016 gli USA potevano contare su circa 62 milioni di telecamere di sorveglianza, secondo l’ACLU 9mila nella sola Lower Manhattan. Uno studio del 2016 del Center on Privacy & Technology della Georgetown Law evidenzia come 18 Stati degli Usa consentono all’FBI di utilizzare tecnologie di riconoscimento facciale. Non solo, i dipartimenti di polizia statale e locale stanno costruendo i propri sistemi di riconoscimento facciale, dei quali si sa ben poco. Non si sa come affrontano i problemi di accuratezza, non si sa come influenzano le minoranze etniche e razziali. Il riconoscimento facciale delle forze di polizia influisce su oltre 117 milioni di americani ed è per lo più non regolamentato.

Negli USA, però, il riconoscimento facciale suscita forti discussioni nell'opinione pubblica, da parte dei sostenitori dei diritti civili, fino a dibattiti al Congresso sulle problematiche di privacy, e di tutela dei diritti dei cittadini. Addirittura a San Francisco hanno vietato l’uso di questa tecnologia, nonostante la fiera opposizione della polizia. Ma non è chiaro quali ne siano i limiti. Quando i dati biometrici possono essere utilizzati per scovare dei sospetti? Quando sono sufficienti per arrestare persone? E nel settore privato, quando le aziende possono utilizzare tali tecnologie? La tendenza è ad aprire la strada allo sviluppo di enormi database di immagini, casomai con associate informazioni contestuali per identificare meglio le persone. La giustificazione è che senza i dati contestuali il riconoscimento sarebbe meno accurato e potrebbe portare ad identificazioni erronee. Il resto lo fanno le aziende private sviluppando una tecnologia sempre più precisa, sempre più efficace, sempre più intrusiva.

Negli Usa le attuali norme sono definite da una serie di casi, a partire dal famoso Katz vs. Stati Uniti dove la Corte Suprema ha dichiarato che ciò che accade in pubblico o viene consapevolmente esposto al pubblico non è soggetto alla protezione del Quarto emendamento. Quindi, una persona che cammina per strada, in un parco pubblico, in aree soggette al pubblico, non può ragionevolmente aspettarsi di non essere osservato. La posizione è stata confermata poi da altri casi, come Sherman contro Stati Uniti.

Insomma, non ci sono praticamente regole che proibiscano alla polizia o agli enti privati di raccogliere, archiviare, o trasmettere liberamente immagini catturate da una telecamera di videosorveglianza. Il mondo della sorveglianza digitale è ancora una sorta di selvaggio West dove ognuno può fare (quasi) quello che gli pare. Non c’è modo di sapere se si è controllati. Anche molte aziende usano questa tecnologia, si scambiano anche i database di immagini collegate al sistema, per impedire che un taccheggiatore possa fare danni in altre catene di negozi. E il pubblico spesso non ne è a conoscenza. È una sorta di credit score. Solo che la gente non lo sa.

Il riconoscimento facciale è in rapida espansione dovunque. Anche in Europa, nonostante il quadro normativo renda più difficile l’utilizzo di questa tecnologia, la tendenza è di incrementarne l’uso, quanto meno a fini di sicurezza e di ordine pubblico, quindi lotta al terrorismo e prevenzione dei reati. È utilizzato dalla polizia del Galles. In Gran Bretagna hanno utilizzato il sistema giapponese NeoFace Watch della NEC per individuare un ricercato in mezzo alla folla. Secondo la British Safety Industry Authority (BSIA) nel 2013 nel Regno Unito erano attive 5,9 milioni di telecamere di sorveglianza. In Germania sono stati avviati i primi test per l’utilizzo del riconoscimento facciale nelle stazioni ferroviarie. Per il momento in Francia il CNIL ha autorizzato il riconoscimento facciale solo negli aeroporti di Orly e Roissy, e presso la Gare du Nord per l'imbarco a bordo dell'Eurostar, ma una proposta di legge del 2016 ne suggerisce l’utilizzo per la lotta al terrorismo.

La tecnologia di riconoscimento facciale è in pieno boom. Secondo un rapporto del 2016 di Frost & Sullivan il mercato di riferimento varrà 6,15 miliardi di dollari nel 2019. NEC stima che nel prossimo decennio raggiungerà i 20 miliardi di dollari.

Un mito creato da Hollywood

Si tratta, però, di una tecnologia ancora soggetta ad errori. Se i successi vengono enfatizzati, come in Cina, a dimostrarne l’efficienza, in realtà ci sono molti casi nei quali la tecnologia ha fallito. I primi problemi sono venuti a galla dalla caccia all'uomo per gli attentatori della maratona di Boston.

Video dalla telecamera di sorveglianza di un rivenditore vicino a Copley Square

I presunti colpevoli, Dzhokhar e Tamerlan Tsarnaev, erano entrambi nel database, ma il sistema non è riuscito a trovare alcuna corrispondenza, almeno fino a quando non sono stati identificati con altri mezzi. Poi ci sono i tanti casi di falsi positivi, quando a delle persone viene erroneamente attribuita un’identità, casomai di un criminale (studente americano identificato erroneamente come terrorista).

Nel 2011 un’interrogazione del sistema con un’immagine di Osama Bin Laden portò a identificare quattro persone, ma nessuna di loro era Bin Laden, col quale condividevano solo la barba. Secondo uno studio di Big Brother Watch del 2018 sull’uso del riconoscimento facciale nel Regno Unito, le percentuali di errore arrivano, in certi casi, fino al 98%. La polizia comunque acquisisce e conserva la foto delle persone erroneamente identificate. In un recente rapporto, la Homeland Security americana si è vantata del fatto che il sistema di riconoscimento facciale ha confermato biometricamente "oltre 7000" persone che hanno lasciato il paese dopo la scadenza del visto. Su 2 milioni di passeggeri, si tratta di un tasso di successo di circa lo 0,0035 percento.

Il riconoscimento facciale non è un processo magico come ci ha erroneamente portato a credere Hollywood. I film glorificano i detective che salvano l'umanità catturando i cattivi col riconoscimento facciale, rendendo la tecnologia “cool”. Ed è più che altro l’immagine hollywoodiana di questa tecnologia, infallibile, precisa, affidabile, veloce, che poi viene venduta dalle aziende ai governi e agli enti locali, polizie in primis. La scintillante promessa di facile identificazione, che rende non più necessario il contatto tra poliziotto e cittadini, è molto appetibile. Si risparmia tempo, lavoro, e non occorre nemmeno adoperarsi per formare delle relazioni umane con le comunità. Alla polizia basta guardare un asettico schermo. Così il riconoscimento facciale da ai governi la sensazione di poter raggiungere il massimo livello di controllo sulla vita delle persone.

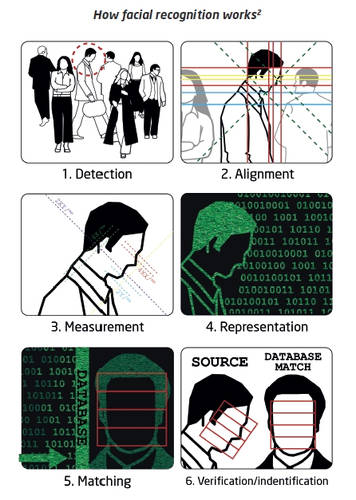

Ma una telecamera, posta generalmente in posizione elevata, riprende una persona dall’alto, mentre si sta muovendo, casomai con gli occhiali, forse sotto la pioggia. L’illuminazione dell’ambiente, l’angolazione della telecamera, i riflessi e l’espressione facciale possono compromettere il processo di riconoscimento. La foto deve essere elaborata se non è presa, come spesso accade, di fronte. Occorre eliminare le sfocature, gli artefatti, occorre ruotare l’immagine per poterla poi mettere a confronto con le foto contenute nel database, in genere prese di fronte. Il software poi cercherà di identificare le caratteristiche facciali da utilizzare come punti di riferimento per estrarre il faceprint, l’impronta facciale. Il centro del naso, gli occhi, gli angoli della bocca sono generalmente i punti utilizzati, e se il sistema non è in grado di rilevarli occorre l’intervento di qualcuno che glieli indichi. A mano. Una volta impostati i punti di riferimento il software finalmente “normalizza” l’immagine per poterla poi mettere a confronto col database al quale accede. Il risultato è una percentuale che indica il livello di corrispondenza (matching).

La donna invisibile

La tecnologia ha fatto grandi passi in avanti negli ultimi anni, grazie alle migliorate capacità di calcolo, e ai sistemi di intelligenza artificiale che si occupano automaticamente delle varie fasi, ma la capacità di riconoscimento dipende ancora da troppi fattori, dall’angolazione, dalla luce, dalla risoluzione. Anche dalla razza.

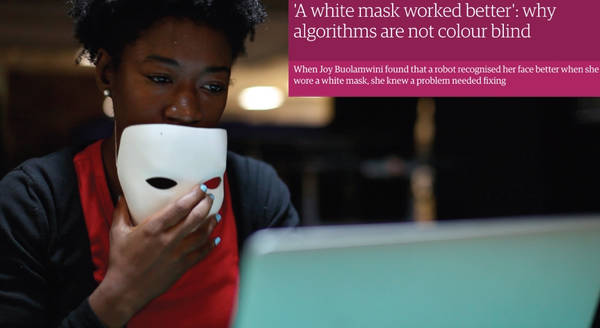

Joy Buolamwini è una ricercatrice del MIT di Boston quando scopre che un software di riconoscimento facciale non è in grado di rilevare il suo volto. Il software funziona sui compagni di classe, sulle altre persone, per lo più di pelle chiara, ma non su di lei.Studiando il software, Buolamwini scopre che se indossa una maschera bianca il sistema riesce a “vedere” il suo volto. I sistemi di intelligenza artificiale “imparano” attraverso le immagini fornite durante la fase di addestramento. Se tali immagini sono esclusivamente o principalmente di persone di pelle chiara, il sistema imparerà a riconoscere i bianchi, ma farà fatica a identificare o differenziare i volti con tonalità differenti della pelle. Allo stesso modo, se il sistema viene addestrato su maschi, avrà difficoltà nell’identificare delle donne.

Buolamwini e i colleghi del MIT realizzano uno studio sui principali programmi di riconoscimento facciale dell’epoca: Microsoft, IBM e Face++ (cioè la Megvii cinese). Pur con le loro differenze, i sistemi si sono rilevati tutti con un’accuratezza non troppo elevata con riferimento alle persone di colore e alle donne. Prima di rendere pubblica la ricerca, Buolamwini ha inviato i risultati alle aziende. IBM ha risposto immediatamente, cercando di risolvere i problemi. Il risultato è stato un enorme miglioramento. L’accuratezza del sistema nel riconoscere i maschi neri è passata dall’88% al 99,4%, per le donne nere dal 65,3% all’83,5%, per le donne bianche dal 92,9% al 97,6%. Per i maschi bianchi l’accuratezza è rimasta invariata al 97%. Buolamwini ha commentato affermando che ciò che era cambiato è che il problema era diventato una priorità dell’azienda. Forse prima non lo era.

Anche l’FBI, in uno studio congiunto, ammette che il riconoscimento facciale potrebbe essere meno accurato sugli afroamericani. Inoltre, i sistemi che si basano su database di foto segnaletiche includono probabilmente un numero sproporzionato di afroamericani (come gli attivisti, i partecipanti alle proteste), ed è difficilissimo ottenere di essere cancellati dal database. Nonostante ciò, non esiste un regime di test indipendenti per i tassi di errore razziale.

Perché proprio il database delle immagini con le quali vengono confrontate le immagini riprese dalle telecamere, è un elemento essenziale per una corretta identificazione. Da dove sono state prese quelle immagini? Le foto inserite nei database spesso sono risalenti nel tempo, le persone cambiano col passare degli anni. La foto di uno dei due attentatori di Boston risaliva ai suoi 16 anni, ma un ragazzo cambia velocemente la struttura facciale, per questo non era stato riconosciuto. Le immagini contenute nel database di controllo potrebbero provenire da una serie di fonti differenti, e non includere solo immagini di persone con precedenti penali o persone sospettate di illeciti penali. Ad esempio potrebbe includere le immagini di persone che sono semplicemente venute a contatto con le forze dell’ordine per controlli di routine, potrebbero venire dalle registrazioni delle manifestazioni di piazza o di proteste pacifiche, potrebbero provenire dai social media, ecc.

Chi è il criminale?

Il riconoscimento facciale non è accurato come l’utilizzo di altri dati biometrici, ad esempio le impronte digitali. Tuttavia il volto è considerato l’indicatore più importante nella nostra società, è il volto che campeggia sui passaporti, sulle carte di identità, sulle patenti e gli altri documenti. È il volto che troviamo sui profili dei social. Generalmente nella società non è considerato accettabile coprire il volto, in alcuni paesi è addirittura illegale.

Questo perché se fino al XXI secolo i governi usavano l’identificazione biometrica in modo discreto, mirato nei confronti di individui specifici, e quindi trasparente necessitando della cooperazione della persona, oggi la tecnologia biometrica è usata per identificare le persone da lontano (Remote Biometric Identification) in modo non collaborativo, senza il loro consenso, senza trasparenza. Il volto è catturato dalle telecamere quando cammini, anche se non ti accorgi della loro presenza.

L’utilizzo delle tecnologie di riconoscimento facciale segna, quindi, un cambiamento radicale nelle forme di sorveglianza consentendo un controllo continuo e generalizzato su tutti gli individui, anche se non sospettati di alcun crimine. In maniera invisibile. Questo impatta particolarmente sulle minoranze o sulle categorie normalmente discriminate. Sia perché tali categorie sono da sempre soggette a maggiori controlli, ed arresti, sia perché i sistemi di intelligenza artificiale hanno maggiori problemi nell’identificare persone appartenenti a tali categorie (perché addestrati sulla maggioranza, bianchi, maschi, ecc...). Il dataset Labeled Faces in the wild (LFW), utilizzato da molti sistemi di riconoscimento facciale, contiene più di 15mila immagini, di cui solo il 7% di persone di colore. All’epoca della realizzazione, ai primi del 2000, il dataset rispecchiava le posizioni di potere dei media e le celebrità. Per lo più bianche.

Il gigante cinese IT e delle telecomunicazioni Huawei afferma che la tecnologia Safe Cities ha già aiutato il Kenya a ridurre i tassi di criminalità urbana. Ma chi è un criminale?

I documenti del progetto Police Cloud cinese elencano i “petizionisti”, le persone che si lamentano del governo per le ingiustizie percepite, e in genere chiunque “mina la stabilità” o ha “pensieri estremi”. Altri documenti indicano come sospetti alcuni comportamenti, come il “non socializzare coi vicini”, oppure le minoranze etniche (es. gli Uiguri dello Xinjiang, un gruppo minoritario musulmano) come soggetti di controllo. La tecnologia di riconoscimento facciale integrata nelle reti di telecamere di sorveglianza, riporta il New York Times, guarda agli Uiguri esclusivamente in base al loro aspetto, etichettando le persone per etnie, e tiene traccia dei loro movimenti. La pratica rende la Cina un pioniere nell'applicare questa tecnologia per controllare i suoi cittadini, potenzialmente inaugurando una nuova era di razzismo automatizzato.

Clare Garvie, del Centro di privacy e tecnologia della Georgetown Law, ha detto: «Prendi l'applicazione più pericolosa di questa tecnologia, e ci sono buone probabilità che qualcuno la proverà». L’utilizzo del sistema di sorveglianza digitale non si ferma al riconoscimento facciale ma può andare molto oltre, rilevando i comportamenti, e tutto ciò che è deviazione dalla “normalità”, anche nel camminare (gait analysis). Una persona che utilizza un telefono non suo, che si allontana dal normale percorso casa-lavoro, tutti i comportamenti che sono reputati non normali possono finire per costituire micro-indizi da registrare in un profilo del cittadino. Le telecamere non possono rilevare i reati economici e dei colletti bianchi, in genere registrano, invece, i comportamenti devianti e i reati minori. Maggiore sicurezza, quindi, vuol dire riduzione dei reati, oppure controllo sociale?

Il cittadino, etichettato come “deviante” (studio sul riconoscimento del comportamento umano anomalo), può essere sottoposto a interrogatorio senza alcun reale motivo, senza diritti, senza risarcimenti in caso di maltrattamenti. Per il momento accade in Cina (ed è spesso comunque in violazione delle leggi), ma è la tecnologia stessa che consente tali abusi. E la tentazione è forte, anche per i paesi ritenuti più “democratici”. Controllare tutti i comportamenti di routine per inferire comportamenti anomali, devianti, può essere facilmente giustificato con la necessità di prevenzione dei reati e di attentanti terroristici (come effettivamente succede in Cina). Il passo verso l’abuso è breve.

Il punto di vista del giardiniere

È la cooperazione tra esseri umani che ha portato a tantissime conquiste in tutti i campi, dalla tecnologia all’economia. Più si allarga la base di condivisione e cooperazione, più si allarga la varietà della base, e quindi delle possibili idee, più si alimenta il flusso di informazioni tra i soggetti, maggiori sono i benefici. Per tutti. Eppure, nonostante il numero di crimini sia in diminuzione praticamente ovunque (grafici relativi agli Usa), sia i governi che le aziende, che alcuni politici, enfatizzano costantemente il problema della sicurezza, con campagne di vero terrore verso i propri cittadini, obiettivo, il diverso, lo straniero, il migrante.

L’utilizzo delle tecnologie di riconoscimento facciale a fini di “sicurezza” potrebbe invertire il processo di cooperazione tra le persone e di mettere in comune le idee e le soluzioni, alimentando le “paure” verso gli “altri”. Ciò favorirebbe il governo in carica, e massimizzerebbe i profitti delle aziende tecnologiche e della sicurezza, soldi e potere. Ma nel contempo potrebbe avere un catastrofico impatto sul resto della società.

Lo spostamento del controllore dietro ad uno schermo, l’utilizzo di forme di sorveglianza remote, erode il legame tra controllore e controllato e alla lunga la stessa moderazione comportamentale. Tutto quello che rimane è la visione di guerra del giardiniere (Neil Renic, A Gardener's Vision: UAVs and the Dehumanisation of Violence) che lotta contro i parassiti. Non si tratta di una visione estrema da applicare solo agli scenari di guerra con droni e tecnologie automatizzate, ma un rischio concreto in tutti quei casi nei quali coloro che sono soggetti a un’azione sono separati dall’attore stesso. Senza la comunicazione, la connessione, l’empatia, si finisce per trattare i “soggetti al controllo” come separati, differenti, diversi, meno umani. Superato quel sottile confine, tutto è permesso.

Altri articoli sulle problematiche degli algoritmi e sistemi di intelligenza artificiale:

Gli algoritmi e i mostri della tecnologia

L’algoritmo che prevede chi commetterà un crimine, tra poca trasparenza e pregiudizi

Il potere degli algoritmi sulle nostre vite

Algoritmi, intelligenza artificiale, profilazione dei dati: cosa rischiamo davvero come cittadini?

Immagine in anteprima via MIT Media Lab