L’intelligenza artificiale è davvero intelligente? E un giorno potrà diventare cosciente?

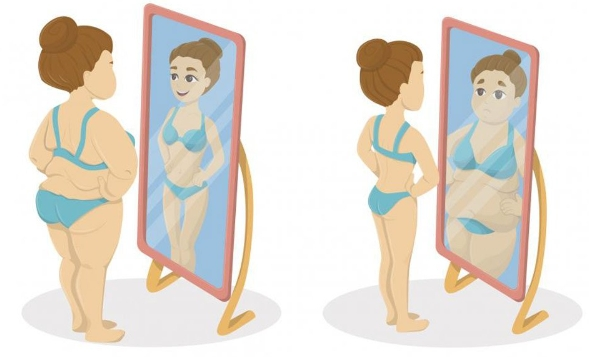

26 min lettura“The Dress” è un fenomeno virale del 2015 che ha appassionato e fatto discutere molto. Si tratta di una foto pubblicata online nella quale alcuni osservatori vedevano un vestito a righe blu e nere, mentre altri ne vedevano invece uno a righe bianche e oro. Entrambe le fazioni erano convinte di ciò che vedevano.

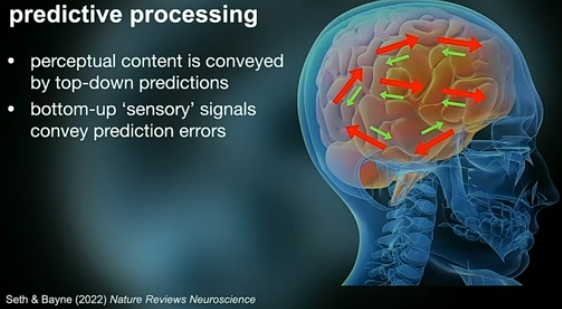

L’idea comune è che il cervello sia una sorta di elaboratore appollaiato all’interno del cranio. Il cervello elaborerebbe le informazioni che riceve dai sensi per ricostruire l’immagine del mondo esterno a beneficio del sé. Si tratterebbe, quindi, di un processo di rilevazione dal basso verso l’alto (bottom-up o data driven processing).

Ma secondo alcuni scienziati le cose potrebbero non essere proprio così. Proviamo a immaginare. Lassù all’interno del cranio il cervello è totalmente isolato. Non c’è luce, niente suoni, buio e assoluto silenzio. Tutto ciò che riceve il cervello è un bombardamento continuo e ininterrotto di segnali elettrici. Non esiste alcuna legenda per quegli impulsi elettrici. Si tratta di infiniti segnali elettrici provenienti dai sensi che - per essere chiari - sono ben più dei cinque comunemente riconosciuti, anche la temperatura e la posizione sono esperienze sensoriali. Come fa quindi il cervello a distinguere tra le varie esperienze sensoriali? Come fa a capire cosa significa ognuna di esse? Come fa - in poche parole - a trasformare i segnali elettrici sensoriali, intrinsecamente ambigui, in una ricostruzione coerente di un mondo ricco di oggetti, persone e luoghi?

Gli studi del fisiologo Hermann von Helmholtz, nel XIX secolo, e dello psicologo Richard Gregory negli anni Settanta, hanno consentito di proporre una nuova tesi in base alla quale il cervello, nel suo isolamento cranico, non fa altro che avanzare continuamente ipotesi percettive su come potrebbe essere il mondo esterno, ipotesi basate sulle esperienze passate e sulle relative informazioni che vengono organizzate e quindi sottoposte a verifica. Il contenuto percettivo, secondo Gregory, non è altro che l’ipotesi più accreditata (psicologia cognitiva).

La realtà oggettiva è ciò che esiste indipendentemente dalla nostra mente, è il mondo esterno, composto da oggetti e fenomeni che hanno una propria esistenza, indipendentemente dal fatto che li percepiamo o meno. Ad esempio, una sedia è un oggetto reale che esiste nel mondo, con le sue proprietà fisiche e la sua struttura, anche quando non la stiamo guardando o pensandoci. L'esperienza percettiva, invece, è il modo in cui noi percepiamo e interpretiamo la realtà oggettiva. È il nostro "mondo interiore", composto da sensazioni, immagini, pensieri e emozioni che emergono dall'interazione del nostro cervello con i sensi. Quando vediamo una sedia, non percepiamo semplicemente l'oggetto in sé, ma piuttosto un insieme di informazioni sensoriali (come la sua forma, il colore e la consistenza) che il nostro cervello elabora e interpreta per creare la nostra esperienza di "sedia".

In questo senso lo psicologo Chris Frith ha definito la percezione come una “allucinazione controllata”, che si differenzia dall'allucinazione non controllata (es. la schizofrenia) in quanto nella prima le predizioni sono verificate costantemente e aggiornate in base ai dati sensoriali secondo un metodo top-down. Nel caso dell’allucinazione non controllata, invece si tratta solo di percezioni non verificate che perdono la presa sul mondo. Secondo Frith, la percezione non è semplicemente una passiva registrazione di ciò che vediamo, sentiamo o tocchiamo. Invece, il nostro cervello costruisce attivamente una rappresentazione del mondo basata su una combinazione di informazioni sensoriali, aspettative passate e conoscenze attuali. La nostra rappresentazione del mondo è influenzata da ciò che ci aspettiamo di vedere o sentire.

Il neuroscienziato Anil Seth in “Come il cervello crea la nostra coscienza”, spiega che un foglio di carta appare bianco comunque, anche in condizioni di luce differenti. In realtà all’aperto il bianco ha una composizione spettrale differente. Eppure il foglio appare sempre bianco perché il nostro cervello compensa le differenze in modo che l'esperienza del colore selezioni una proprietà invariante del pezzo di carta. Questo vuol dire – continua Seth – che il colore non è una proprietà delle cose, piuttosto uno strumento utile che l’evoluzione ha approntato affinché il cervello possa riconoscere e tenere traccia degli oggetti nelle condizioni in cui cambia la luce. Il pezzo di carta in fin dei conti non è realmente bianco, la sua superficie riflette la luce in un certo modo che è differente a seconda delle condizioni di illuminazione, ma a noi appare comunque bianco. La “bianchezza” è l’aspetto fenomenologico, soggettivo, di questo processo.

Questo non vuol dire – chiarisce Seth – che la "bianchezza" è dentro il nostro cervello. In realtà la bianchezza non è né fuori né dentro al cervello, ma corrisponde al contenuto di una serie di predizioni percettive sui modi come una superficie riflette la luce.

Il colore è il luogo dove si incontrano il nostro cervello e l’Universo (Paul Cézanne)

In estrema sintesi, l’esperienza percettiva potrebbe essere niente altro che una fantasia neurale che diventa realtà quando siamo tutti d’accordo sulle nostre “allucinazioni”. Si tratta di un’idea controintuitiva, ma che ha generato profondo dibattito nella comunità scientifica e ha aperto la strada a nuove ricerche sulla natura della coscienza.

La percezione come costruzione

L’idea che la nostra percezione non sia altro che una “costruzione” del cervello, piuttosto che una semplice registrazione passiva della realtà è supportata da numerose evidenze. Innanzitutto vi sono numerosi fenomeni di illusioni ottiche. Casi come "The Dress" sono sintomatici.

La foto di "The Dress" era sovraesposta e mancava di contesto. Il fatto che il vestito riempisse l’intera foto ingannava il cervello. Un sistema visivo abituato alla luce ambientale interna, giallognola, di chi sta molto al chiuso, può vedere le righe blu e nere, un sistema visivo più abituato all’esterno, con luce solare azzurrina, può darsi che le veda bianche e nere. Le illusioni ottiche dimostrano che il nostro cervello può interpretare le stesse informazioni sensoriali in modi molto diversi, a seconda delle esperienze passate e delle aspettative.

Poi vi sono i fenomeni di percezione alterata. Alcune condizioni neurologiche e psicologiche possono causare alterazioni significative della percezione, come nel caso delle allucinazioni o della prosopagnosia (incapacità di riconoscere i volti). Anche il fatto che il cervello sia in continua evoluzione suggerisce che la nostra percezione non sia fissa e immutabile, bensì malleabile e adattabile.

Ovviamente questo non significa che non esiste alcuna realtà oggettiva al di là della nostra percezione, ma che la percezione della realtà è mediata e influenzata dai processi neurali. La teoria della percezione come “allucinazione controllata” o, se preferite, come “fantasia neurale”, è una prospettiva affascinante che offre un diverso modo di comprendere come il cervello crea il nostro senso di realtà. Invece di un metodo dal basso verso l’alto, cioè a partire dai dati sensoriali, si teorizza un metodo dall’alto verso il basso. Il cervello crea costantemente ipotesi sulla base delle esperienze disponibili e le verifica in base ai nuovi dati sensoriali. La nostra realtà, secondo questa teoria, sarebbe quindi niente altro che l’ipotesi più accreditata prodotta dal cervello chiuso nel suo magnifico isolamento.

Questa simulazione è modellata da una serie di fattori, tra cui:

- Le nostre aspettative e previsioni: il cervello elabora continuamente informazioni dal mondo esterno e le utilizza per generare modelli predittivi di ciò che ci si può aspettare di percepire.

- I nostri sensi: i segnali sensoriali che provengono dai nostri occhi, orecchie, pelle e altri organi di senso forniscono input importanti per la simulazione cosciente.

- I nostri ricordi e le nostre emozioni: le nostre esperienze passate, le nostre memorie e le nostre emozioni giocano un ruolo fondamentale nel plasmare la nostra simulazione cosciente. Ad esempio, se siamo ansiosi o stressati, è più probabile che interpretiamo le situazioni in modo negativo.

In altre parole, la realtà non è oggettiva e universale, bensì soggettiva e relativa. Il fatto che tante persone abbiano esperienze così diverse è indice che le nostre esperienze percettive possano essere più delle costruzioni interne che delle rilevazioni sensoriali. Assumiamo che il mondo sia in un certo modo perché molti di noi convengono sulla nostra visione. Ma alla fine la percezione appare più un processo generativo che un’interpretazione dei fatti.

Gli esseri umani, quindi, utilizzano un modello generativo che crea costantemente delle predizioni sulla realtà che ci circonda e valuta nel contempo i risultati adattandoli in continuo ai nuovi dati sensoriali. Queste predizioni coinvolgono tutti gli aspetti della nostra vita, dall’identità del sé fino al sé sociale. Percepire lo stato mentale di un altro è fondamentale per delle creature sociali come gli esseri umani. Formiamo costantemente percezioni sulle credenze, le emozioni altrui, con la stessa naturalezza con cui formiamo percezioni sui gatti e sugli oggetti che ci circondano. Il cervello è una macchina predittiva e la percezione è un processo di inferenza delle cause dei segnali sensoriali. Il sé sociale è costituito dalla generazioni di ipotesi sugli stati mentali altrui. E questo potrebbe significare anche che la consapevolezza del sé richieda necessariamente un contesto sociale. Se esistessimo in un mondo senza altre menti rilevanti non vi sarebbe alcun bisogno per il nostro cervello di predire gli stati mentali altrui e quindi inferire che le sue proprie esperienze e azioni appartengano a un sé.

Nessun uomo è un’isola (John Donne)

Probabilmente non percepiamo il sé come un fascio di predizioni, semplicemente perché percepiamo il cambiamento in maniera piuttosto limitata. Abbiamo una esperienza di un sé che muta poco nel tempo, come il nostro corpo. Eppure noi cambiamo molto velocemente. Le nostre percezioni cambiano ma questo non significa che le percepiamo come cangianti. Perché anche il cambiamento è alla fine una percezione. Vi è, quindi, una sorta di cecità al cambiamento dovuta al lento mutare dei nostri corpi e dei nostri cervelli.

Ogni buon regolatore di sistema deve avere un modello di quel sistema, così come un impianto di riscaldamento è più efficiente se è in grado di predire variazioni significative della temperatura così anticipando l’accensione o lo spegnimento. Secondo lo psicologo James Gibson, noi tendiamo a percepire il mondo in termini di “possibilità d’azione” (affordance) invece che come le cose sono. Ad esempio, se fossimo un giocatore di baseball e dovessimo afferrare la palla che cade, noi non prediciamo dove la palla andrà a cadere, non essendo una buona strategia, piuttosto tendiamo a muoverci facendo in modo che la palla sembri sempre la stessa, in modo che l’elevazione dello sguardo verso la palla cresca a un tasso sempre minore. Seguiamo la palla piuttosto che predire dove cadrà, le nostre predizioni sono rivolte a controllare come la palla percettivamente appaia.

Le nostre esperienze percettive hanno una qualità di "essere reali" molto forte, anche quando non corrispondono perfettamente alla realtà oggettiva. Questo perché il nostro cervello è progettato per darci una rappresentazione del mondo che sia utile per la nostra sopravvivenza e per interagire con esso in modo efficace. In altre parole, la nostra percezione è ottimizzata per l'azione, non per la perfetta replica della realtà. Questa "allucinazione controllata" è vantaggiosa per la nostra sopravvivenza. Sin dalla preistoria gli esseri umani devono prendere decisioni partendo da informazioni limitate, come ad esempio decidere cosa potrebbe essere quel luccichio simile a occhi di leone (Julia Shaw, "L'illusione della memoria"). Questo sistema ci permette di interagire con il mondo in modo efficace e di prendere decisioni rapide in base alle informazioni che abbiamo a disposizione, anche se non sono completamente accurate. Il cervello mette alla prova costantemente questa simulazione sulla base degli input sensoriali, man mano che riceviamo nuove informazioni dai nostri sensi, il cervello le confronta con la sua simulazione interna e la aggiorna di conseguenza. Questo processo di aggiornamento è continuo e ci permette di imparare e adattarci al mondo che ci circonda.

Ad esempio, se vediamo un gatto per la prima volta, il nostro cervello utilizzerà le sue conoscenze esistenti sugli animali per creare una simulazione interna di ciò che un gatto dovrebbe essere. Quando vediamo il gatto successivo, confronteremo la nostra simulazione interna con le nuove informazioni sensoriali che riceviamo dai nostri occhi. Se il gatto successivo è simile al primo gatto che abbiamo visto, la nostra simulazione interna verrà rafforzata. Se invece il gatto successivo è diverso dal primo, la nostra simulazione interna verrà aggiornata per includere queste nuove informazioni.

Quindi il nostro cervello completa le informazioni mancanti basandosi su esperienze passate e modelli preesistenti, fa previsioni su come potrebbero apparire le parti nascoste degli oggetti, integra informazioni da diversi sensi per creare una rappresentazione multidimensionale del mondo ed utilizza euristiche e scorciatoie cognitive per rendere il processo di percezione più efficiente.

Tutti questi processi coinvolgono elementi di probabilità e statistica. Ad esempio, quando vediamo una mela, il nostro cervello utilizza la sua conoscenza di come appaiono le mele in generale per completare la parte che non vediamo. Questo processo si basa su una sorta di "media" di tutte le mele che abbiamo visto in passato, con alcune variabili che potrebbero influenzare il risultato, come l'illuminazione o l'angolo di visuale. In questo senso, si può dire che la nostra rappresentazione della realtà è in parte una ricostruzione statistica basata sulle informazioni disponibili e sui modelli mentali che il nostro cervello utilizza per interpretarle.

Il cervello utilizza modelli generativi interni per interpretare le informazioni sensoriali che riceve, ma noi non percepiamo i modelli come tali. Quando vediamo un oggetto, non percepiamo un insieme di dati sensoriali grezzi (come bordi, colori e sfumature), bensì un oggetto completo e coerente. Questo perché il nostro cervello utilizza i suoi modelli generativi per riempire i vuoti e dare senso alle informazioni incomplete. In questo modo noi siamo in grado di immaginare anche la parte nascosta dell’oggetto che stiamo guardando.

Siamo naturalmente portati a credere che le nostre percezioni siano veritiere e accurate, anche quando non lo sono. E questo può portare a illusioni, pregiudizi e errori di percezione.

Kami no itte

È il 9 marzo del 2016. Un uomo prende una pedina e la pone sulla scacchiera. Un mormorio si leva in sala. Un commentatore subito azzarda: “È una mossa sorprendente”. Qualcun altro aggiunge: “Pensavo fosse un errore”. La mossa in questione, la numero 37, è stata decisa direttamente da un software avanzatissimo creato da Google DeepMind, denominato AlphaGo. Dall’altro lato della scacchiera c’è Lee Sedol, campione mondiale di Go, un gioco molto popolare in Asia e decisamente molto più complesso degli stessi scacchi.

AlphaGo è un’intelligenza artificiale che ha acquisito le sue capacità tramite l’apprendimento rinforzato. Si è addestrata giocando contro se stesso milioni di partite, ma gli esperti hanno contribuito a insegnare al sistema le strategie più efficaci tramite feedback. Eppure, a un certo punto AlphaGo fa una mossa, la 37, che Fan Hui, campione europeo battuto da AlphaGo pochi mesi prima, definisce “non umana”: “Non è una mossa umana. Non ho mai visto una persona farne una così bella. Una mossa davvero sorprendente”.

Lo stesso Lee Sedol dovette allontanarsi dalla sala per riprendersi. Una mossa che era completamente fuori dagli schemi, mai vista prima, qualcosa che venne definito kami no itte, cioè “la mossa divina”. Il significato di questa espressione va oltre il semplice atto di fare una mossa eccellente nel gioco. Indica una mossa così brillante e sorprendente che sembra essere stata ispirata da una forza soprannaturale o divina. È una mossa così geniale che va al di là delle capacità umane ordinarie nel gioco del Go. È un termine usato per sottolineare la straordinaria abilità del giocatore e la sua profonda comprensione del gioco. Questa espressione è spesso riservata per quei momenti in cui un giocatore riesce a sorprendere gli avversari e gli spettatori con una mossa tanto brillante da sembrare quasi divina nella sua genialità.

Quella partita permise ad AlphaGo di assurgere alle cronache internazionali, e il dibattito sull’intelligenza artificiale e la possibile creatività delle macchine tornò alla ribalta. Demis Hassabis, CEO di Deepmind, nel commentare la partita osservò che con AlphaGo avevano codificato l’intuito all’interno delle reti neurali.

Codificare l’intuito nelle reti neurali

La versione di AlphaGo che sconfisse Lee Sedol era una macchina ibrida, nel senso che utilizzava l’apprendimento profondo, la ricerca ad albero, l’apprendimento con supervisione e una conoscenza specializzata del Go. In sostanza era una Intelligenza Artificiale che comunque aveva alla sua base delle specifiche conoscenze del gioco codificate nella rete neurale. Successivamente Google DeepMind sviluppò una nuova versione denominata AlphaGo Zero che si scontrò con Lee Sedol in un centinaio di partite, vincendole tutte (mentre il predecessore aveva vinto quattro partite su 5).

AlphaGo Zero utilizza ancora la ricerca ad albero Monte Carlo. Il metodo Monte Carlo è una famiglia di algoritmi impiegati per la prima volta nel progetto Manhattan per la realizzazione della bomba atomica. Il nome indica che il software può impiegare una certa aleatorietà per la risoluzione di un problema, allo stesso modo che la ruota della roulette dei casinò di Monte Carlo quando è in movimento implica aleatorietà. Tale ricerca ad albero assegna un punteggio a ciascuna mossa del gioco. Siccome per giochi come gli scacchi, ma soprattutto per il Go, una ricerca che valuti tutte le mosse possibili è irrealizzabile, con la ricerca ad albero Monte Carlo il software analizza solo una parte dell’albero delle sequenze di mosse possibili. L’aleatorietà implica che il software scelga a caso una mossa e poi segua l’analisi dell’albero di mosse possibili fino ad un risultato. Se la mossa porta a un risultato positivo viene utilizzata, se no si passa ad una differente configurazione. Ovviamente nelle nuove configurazioni il programma tiene conto dei punteggi delle configurazioni precedenti, così la scelta della mossa non è più davvero a caso. Più configurazioni vengono analizzate, migliore sarà la statistica su cui baserà le successive scelte.

L’intuito codificato nel programma sta nella combinazione tra una rete neurale, che si occupa di assegnare un punteggio alla configurazione di partenza, e la ricerca ad albero Monte Carlo che si occupa della ricerca della mossa migliore. Invece di scegliere una mossa a caso AlphaGo Zero si affida alla rete neurale. La rete neurale a sua volta sfrutta i risultati della ricerca ad albero per assegnare le probabilità alle mosse. In questo modo AlphaGo Zero impara a riconoscere le configurazioni proprio come fanno i maestri del Go.

AlphaGo ha dimostrato che l’apprendimento con rinforzo permette ai programmi di imparare da soli limitandosi ad eseguire azioni nel proprio ambiente e osservando i risultati. È ispirato al condizionamento operante, applicato ad esempio ad un cane al quale diamo un biscotto se esegue correttamente il comando che gli rivolgiamo.

Gli algoritmi alla base di AlphaGo sono potenzialmente più generici delle AI che lo hanno preceduto, come Watson di IBM. In tal senso AlphaGo è stato considerato un progresso nel cammino verso un’intelligenza artificiale generale. In realtà la questione appare molto più complessa. AlphaGo sa giocare solo a Go, non sa giocare né a dama né a scacchi, e non è in grado di trasferire la sua competenza in un altro campo. Noi esseri umani invece abbiamo tale capacità di apprendimento per trasferimento, se impariamo a giocare a dama le conoscenze acquisite ci aiuteranno a capire gli scacchi. Allo stesso modo se impariamo ad aprire una porta girando il pomello, poi trasferiamo questa conoscenza a tutte le porte che incontriamo nella nostra vita. La differenza tra gli esseri umani e le AI sta principalmente nella capacità di generalizzare.

Purtroppo esiste una profonda tendenza umana alla sovra-attribuzione. Ad esempio, riteniamo che l’addestramento con rinforzo di una AI abbia portato il programma a imparare dei concetti, quali “scacchiera”. Ma ciò non è vero, AlphaGo trasportato su una scacchiera di dimensioni differenti avrebbe notevoli difficoltà a giocare come prima. Alle AI manca la capacità di astrazione.

Queste sono le differenze fondamentali tra una AI e un essere umano. I genitori invogliano il figlio ad iscriversi al corso di scacchi principalmente perché ritengono che il gioco insegni ai bambini a pensare meglio, in modo logico e strutturato. E che quel modo di pensare si trasferisca ad altri ambiti della vita. Insomma per acquisire capacità generali che poi sapremo impiegare in altre attività. AlphaGo non impara, invece, a pensare meglio, la sua capacità acquisita in un ambito specifico rimane circoscritta in quell’ambito e non è trasferibile ad un altro. DeepMind realizzò diverse versioni di AlphaGo per giocare ad altri giochi simili al Go, ma in ogni caso dovette azzerare il programma e addestrarlo da zero.

Per questo AlphaGo, pur avendo dimostrato addirittura creatività nel suo compito specifico, non dimostra comunque un’intelligenza di tipo umano, per come siamo soliti definirla. Ma cosa è davvero l’intelligenza?

Intelligenza

Il termine intelligenza artificiale fu coniato nel 1956 nel corso di un seminario del Dartmouth College. Il matematico John McCarthy annunciò che si sarebbe proceduto sulla base della congettura che ogni aspetto dell’apprendimento o qualsiasi altra caratteristica dell’intelligenza possa essere descritto in modo così preciso da poter costruire una macchina per simularlo.

Nel 1970 l’informatico Marvin Minsky, cofondatore del laboratorio di intelligenza artificiale del Massachusetts Institute of Technology, sostenne che entro otto anni al massimo avremmo avuto una intelligenza artificiale pari a quella di un essere umano medio. Negli anni si sono avvicendate costantemente nuove promesse sulla realizzazione di una intelligenza artificiale con la capacità di emulare l’intelligenza umana. Ma tutte quelle promesse, almeno finora, non sono state mantenute.

Il lancio di ChatGPT nel 2022 ha alimentato l’hype in tema di intelligenza artificiale. Molti adesso credono che siamo più vicini al punto in cui l’intelligenza artificiale raggiungerà le capacità dell’essere umano, insomma vicini a produrre quella che nel gergo tecnico viene definita AGI, cioè intelligenza artificiale generale. In realtà ChatGPT e i suoi simili non hanno fatto altro che dimostrare che produrre frasi in prosa grammaticalmente corretta non richiede alcuna capacità di pensiero critico, che invece implica una comprensione profonda del contesto. Quando, invece, si chiede ai chatbot di risolvere problemi che richiedono pensiero critico e comprensione del mondo reale questi falliscono miseramente.

Ciò che dimostra ChatGPT in fine dei conti non è altro che determinate e specifiche capacità dell’essere umano, come scrivere un libro, non sono poi così complesse come abbiamo ritenuto in passato, e quindi è possibile emulare tali capacità addestrando opportunamente una macchina. Ma cosa serve, invece, perché una macchina sia davvero simile ad un essere umano?

La barriera del significato

I chatbot che generano contenuti possono mettere insieme sequenze convincenti di parole basate sull'analisi di modelli statistici precedenti, ma non conoscono il significato di nessuna delle parole che generano, e soprattutto non sanno come queste parole si collegano al mondo reale. Tutte quello che fanno è generare semplicemente una sequenza di parole su base statistica.

L’era moderna dell’intelligenza artificiale si poggia su tre elementi: il deep learning (reti neurali profonde), i Big Data e i computer di grande potenza. Tuttavia per fare il grande passo verso una AI generale si oppone ancora la “barriera del significato”. La "barriera del significato" è un concetto che si riferisce alla sfida fondamentale nell'ambito dello sviluppo delle intelligenze artificiali generali (AGI), ovvero sistemi di intelligenza artificiale in grado di comprendere e applicare concetti in modo simile agli esseri umani. Questa barriera si manifesta quando le AI si scontrano con la comprensione del significato nel contesto delle informazioni che elaborano.

Per gli esseri umani, il significato è un concetto profondamente radicato nelle nostre capacità cognitive, che includono non solo la comprensione letterale delle parole, ma anche il contesto, le sfumature, le emozioni e le connessioni con altri concetti. Le intelligenze artificiali attuali, anche se estremamente capaci in determinati compiti specifici, mancano della capacità di comprendere il significato in questo senso più ampio.

La barriera del significato rappresenta, quindi, una sfida cruciale nel campo dell'IA generale, poiché superarla richiede la creazione di sistemi che non solo possano elaborare dati e compiti, ma che possano anche comprendere il significato di ciò che stanno elaborando. Questo richiede una comprensione più profonda del linguaggio, della semantica, del contesto e delle relazioni concettuali, e rappresenta una delle frontiere più significative nello sviluppo delle AI.

Nell’osservare una scena di vita un essere umano deduce tutta una serie di fatti, ma anche emozioni, in sostanza ragiona sullo stato mentale delle persone che si trovano nel suo campo visivo. Tali inferenze non sono ricavate invece da una AI. Una tesi piuttosto suggestiva sintetizza nell’embodiment il limite delle macchine. Cioè, in assenza di un corpo che interagisce col mondo la macchina sarebbe incapace di acquisire un’intelligenza di livello umano. Quindi per costruire una IA che sia in grado di interpretare una scena così come facciamo noi umani occorre esporla agli anni di esperienza che viviamo noi esseri umani.

Secondo la teoria dell’allucinazione controllata il cervello crea costantemente delle previsioni. Queste previsioni sono costantemente poste a confronto con i segnali sensoriali e quindi vagliate sulla base di essi. In questo modo le previsioni (dall’alto verso il basso) sono verificate e calibrate. La rappresentazione del mondo esterno non è altro che un’ipotesi bayesiana plasmata dall’evoluzione. Secondo Anil Seth anche il sé non è altro che un’allucinazione controllata, un’altra ipotesi bayesiana.

Un’ipotesi bayesiana è una teoria su un evento o un parametro che permette di quantificare la credenza soggettiva su un fenomeno basandosi sulle informazioni disponibili. Non si tratta, quindi, di interpretare le probabilità in base alla frequenza di un evento (approccio frequentista) ma di valutare le ipotesi sulla base delle informazioni sopraggiunte. L'inferenza bayesiana è un metodo flessibile e potente per prendere decisioni partendo da dati complessi e incerti. L’ipotesi bayesiana permette di incorporare le conoscenze preesistenti, aggiorna le convinzioni in modo continuativo, gestisce l’incertezza e si adatta a modelli complessi. L'inferenza bayesiana è ben attrezzata per affrontare modelli statistici complessi e non lineari, dove i metodi frequentisti potrebbero risultare impraticabili.

L’inferenza bayesiana, però, si basa su probabilità soggettive che possono variare da individuo a individuo a seconda delle proprie convinzioni e conoscenze pregresse. Ad esempio una persona potrebbe vedere nell’immagine di un vestito a righe dei colori differenti rispetto ad un altro individuo.

Le ipotesi bayesiane sono ampiamente utilizzate, ad esempio nelle diagnosi mediche per determinare la probabilità di una particolare malattia, basandosi sui sintomi e sui risultati dei test. I filtri antispam utilizzano l'inferenza bayesiana per classificare le email come spam o legittime, analizzando il contenuto del testo e le caratteristiche del mittente. Anche gli scienziati utilizzano le ipotesi bayesiane per valutare l'evidenza a favore di diverse teorie esplicative e per progettare nuovi esperimenti.

L’ipotesi bayesiana potrebbe essere il metodo utilizzato dal nostro cervello per spiegare il mondo, sia quello esterno che quello interno. In tal modo le nostre esperienze coscienti sarebbero legate al mondo esterno da criteri di utilità, ovviamente ai fini della sopravvivenza, piuttosto che da criteri di accuratezza.

I colori, quindi, sarebbero generati dal cervello attraverso la lettura della luce. Il corpo stesso non sarebbe altro che una costruzione del cervello che calibra le previsioni con i segnali sensoriali. Il corpo sarebbe un’allucinazione controllata che ci consente di interagire col mondo esterno. La stessa percezione del sé è un’ipotesi bayesiana plasmata dall’evoluzione. E in ultima analisi la stessa coscienza non sarebbe altro che un prodotto del cervello e non una proprietà oggettiva della realtà. La coscienza è generata dal cervello attraverso l’elaborazione delle informazioni sensoriali e non è, invece, un qualcosa di indipendente dalla nostra percezione.

Se le cose stessero davvero così le possibili conclusioni sarebbero ovvie. Esisterebbero ampi parallelismi tra intelligenza umana e intelligenza artificiale. Entrambi i tipi di intelligenza possono produrre previsioni e interpretazioni che influenzano la loro percezione della realtà. La differenza sta nel fatto che l’intelligenza umana si evolve in risposta ai cambiamenti dell’ambiente. L’intelligenza artificiale, invece, non ha dati diretti dall’ambiente che la circonda, quindi evolve sulla base dei feedback ricevuti dagli utenti. Quello che davvero mancherebbe all’intelligenza artificiale per fare un passo ulteriore nella sua evoluzione è l’accesso ai dati sensoriali.

Embodiment

Gli esperimenti della sindrome dell’arto fantasma sono illuminanti. Un soggetto pone un braccio al di là di una barriera di cartone, laddove nel suo campo visivo è posto un braccio di gomma. Lo sperimentatore strofina dei pennelli in maniera sincronica su entrambe le braccia, la combinazione di vedere la mano di gomma toccata e simultaneamente sentire il tocco sulla mano reale offre al cervello un’evidenza sensoriale sufficiente per raggiungere la migliore ipotesi percettiva per cui la mano di gomma fa parte in qualche modo del corpo. Minacciare la mano di gomma con un coltello porta in genere ad una forte reazione.

Questo tipo di manipolazioni trovano un limite nel fatto che l’agente sa che il braccio di gomma non è il suo, che il corpo che vede è quello di un altro. Per questo l’esperienza varia da soggetto a soggetto, compreso dei casi nei quali alcuni non provano nulla. Anche coloro che trovano l’illusione coinvolgente non hanno mai creduto nemmeno per un solo momento di essere qualcun altro.

Ma esperimenti di questo tipo (BeAnother Lab), che nel tempo sono stati estesi all’intero corpo, indicano che anche il senso soggettivo di proprietà del corpo intero e la posizione della prospettiva in prima persona possono essere manipolati in tempo reale. Esistono molteplici resoconti di esperienze extracorporee che hanno alimentato negli anni l’idea di un’essenza del sé immateriale. Ma ciò non prova realmente che esista un’anima immateriale che esce dal corpo in condizioni particolari. Invece assumere che la prospettiva in prima persona non è altro che una specie di inferenza percettiva, può ben spiegare questo tipo di esperienze. Quello che i vari resoconti rivelano è che la prospettiva in prima persona è assemblata in modo più complesso di quanto pensavamo.

Il cervello non ha accesso diretto agli stati fisiologici del corpo, questi stati sono inferiti tramite le migliori ipotesi, le quali sono realizzate attraverso un processo di minimizzazione degli errori di predizione. Mentre le percezioni del mondo esterno vanno e vengono, le esperienze dell’ipseità sono sostanzialmente stabili e continue su scala temporale. Questo probabilmente perché è una necessità avere predizioni stabili sul corpo ai fini della regolazione fisiologica. Un organismo vivente per esistere deve avere un confine che resiste nel tempo, in tal modo preserva se stesso distinto dal proprio ambiente, e quindi elude, temporaneamente, la seconda legge della termodinamica. Ciò avviene minimizzando l’errore di predizione sensoriale non solo per l’adesso ma anche per il futuro. Se non ci percepiamo come soggetti a cambiamento, conserviamo meglio la nostra identità fisica e fisiologica.

La teoria dell’Embodiment (termine tradotto generalmente con “mente incarnata”) supera il dualismo cartesiano che vede una separazione tra il corpo (res extensa) e la mente (res cogitans) e ci porta a comprendere lo sviluppo della coscienza. Secondo questa teoria la coscienza non è un fenomeno puramente mentale, ma è il risultato dell'interazione tra cervello, corpo e ambiente (Maurice Merleau-Ponty, filosofo francese). Questa teoria trova conferme nelle neuroscienze moderne (Joseph LeDoux, Lunga storia di noi stessi. Come il cervello è diventato cosciente), che hanno svelato l’intimo legame tra processi cognitivi e stati corporei, tra mappe cerebrali e schemi motori. Pensare non è solo manipolare simboli, ma è sempre anche simulare scenari percettivi e piani d’azione, in un continuo rimando tra mente e corpo.

Le nostre esperienze motorie ci consentono di acquisire concetti di base come spazio, tempo e causalità. Si tratta di esperienze senso-motorie che forniscono la base per lo sviluppo di concetti più complessi e astratti. Anche le nostre emozioni sono strettamente legate alle esperienze corporee e svolgono un ruolo fondamentale nello sviluppo della coscienza di sé e della consapevolezza del mondo che circonda. La capacità di provare e riconoscere emozioni consente lo sviluppo del senso del sé come individuo distinto dagli altri. Anche la capacità di vedere e toccare il proprio corpo è fondamentale per lo sviluppo di un senso di sé come individuo distinto dagli altri.

Il bambino nel corso del suo sviluppo passa attraverso vari stadi, dalla consapevolezza corporea, la capacità di muoversi e interagire col mondo esterno, alla comprensione che gli oggetti esistono anche se non possono essere visti o sentiti. Il bambino va oltre il qui e l’adesso per sviluppare simboli al fine di rappresentare eventi, oggetti, ma anche se stesso. È la prima fase della comprensione del mondo.

Il salto qualitativo si ha quando ci si rappresenta come oggetto della nostra stessa esperienza, è l’inizio del pensiero simbolico. Per raggiungere il livello più complesso occorre vivere e integrare le esperienze precedenti un una nuova esperienza più complessa.

La teoria dell'embodiment ha avuto un impatto significativo su diverse aree di ricerca. Con la psicologia cognitiva la teoria dell’embodiment ha portato ad una nuova comprensione di come la mente funziona e di come i nostri corpi influenzano i pensieri e le emozioni. Le ricerche neuroscientifiche hanno dimostrato che il nostro cervello è costantemente impegnato a simulare e anticipare i nostri movimenti e le nostre azioni. E, infine, questo tipo di ricerche hanno consentito di sviluppare sistemi di intelligenza artificiale (come ad esempio quelli di Meta) che incorporano principi di “cognizione incarnata” (embodied cognition) con l’obiettivo di realizzare sistemi in grado di interagire col mondo esterno e quindi più intelligenti.

Verso una IA umana?

Il linguaggio naturale è intrinsecamente ambiguo. Dipende dal contesto e presume una quantità di conoscenze di fondo condivise dalle parti che comunicano. Nei primi tempi la ricerca sulle AI si concentrava su approcci basati su regole. Si realizzavano programmi nei quali erano integrate regole grammaticali e linguistiche che applicavano in fase di input. Approcci che non hanno funzionato particolarmente bene. Negli anni Novanta gli approcci basati su regole furono sostituiti da metodi statistici che utilizzavano enormi dataset per addestrare algoritmi di machine learning.

Intorno al 2012 l’utilizzo dei sistemi di deep learning ha consentito di fare passi enormi nella trascrizione del linguaggio naturale. Oggi una macchina è in grado di trascrivere correttamente quanto gli si detta. Eppure questa macchina non capisce assolutamente nulla di ciò che gli diciamo. Un tempo credevamo che il riconoscimento vocale non avrebbe mai raggiunto prestazioni elevate senza capire il linguaggio. Ma ci sbagliavamo, oggi i chatbot generativi fanno proprio questo, generano linguaggio praticamente indistinguibile da un essere umano. Ma non hanno alcuna consapevolezza di ciò che producono.

Il cervello umano, pur essendo sigillato nella sua prigione ossea, nuota in una corrente di segnali sensoriali che provengono dal mondo esterno, guidando di continuo le azioni che proattivamente plasmano questo flusso sensoriale. Il flusso dei segnali sensoriali in entrata è accolto da una cascata di predizioni dall’alto verso il basso con segnali di errori di predizione che scorrono dall’alto per stimolare predizioni sempre migliori e innescare nuove azioni. Questo processo dà origine ad una approssimazione tramite la quale il cervello si accorda costantemente su quale è l’ipotesi migliore circa le cause dell’ambiente esterno sensoriale. Così prende vita il vivido mondo percettivo secondo la teoria della psicologia cognitiva. Il mondo reale non è altro che la migliore ipotesi sulle cause recondite degli input sensoriali che in sé sono, però, privi di colore, forma e suono.

Il cervello umano crea una rappresentazione interna della realtà basandosi sui dati sensoriali, sulle aspettative e sui modelli preesistenti. Le AI creano una rappresentazione del mondo basandosi sui dati di addestramento e di feedback. La simulazione interna del cervello è addestrata continuamente in base ai dati sensoriali. Le AI si aggiornano in base ai dati di feedback. Il cervello umano apprende e si adatta al mondo attraverso la sua simulazione interna. Le AI apprendono e si adattano ai nuovi dati migliorando i loro modelli interni. La percezione di un essere umano è limitata dalla simulazione interna che non è una copia esatta del mondo reale. La rappresentazione interna del mondo di una AI è limitata dai dati sui quali è addestrata, che potrebbero essere incompleti o imprecisi.

Le somiglianze tra i due sistemi sono evidenti. Come anche le differenze. Il cervello umano ha come scopo quello di raggiungere specifici obiettivi, in ultima analisi la sopravvivenza. Un’intelligenza artificiale non ha un reale scopo. Soprattutto, quello che manca alle AI è una effettiva consapevolezza del mondo, sia quello esterno che quello interno. Ma come abbiamo visto nuove teorie ritengono che tale consapevolezza nell’essere umano dipenda in gran parte anche dal fatto di avere un accesso a dati sensoriali attraverso il corpo.

In questo senso dotare una AI di sensori e attuatori, per avere dati sensoriali e interagire col mondo, potrebbe facilitare l’apprendimento. Questo è il principio chiave che sta dietro la realizzazione dei robot autonomi, dove il “corpo” gioca un ruolo critico nell’apprendimento e nell’adattamento. Il passo successivo potrebbe essere quello di insegnare alla AI a prevedere e rispondere agli scenari attraverso la simulazione interna, come fa un essere umano. Questo potrebbe portare la AI a comprendere il mondo e ad interagire con esso in modi più sofisticati.

Se la coscienza emerge come un modo per il cervello di interpretare e prevedere gli input sensoriali, costruire sistemi AI che possano fare altrettanto con i loro sensori potrebbe avvicinarci a replicare alcuni aspetti della coscienza umana. Un sistema AI che può modellare attivamente sia l'ambiente esterno sia il proprio "stato interno" potrebbe iniziare a mostrare forme di comportamento che noi interpreteremmo come consapevoli o intenzionali. Se una AI potesse sentire e controllare il proprio stato interno, come fa un essere umano (interocezione), questo potrebbe anche avere implicazioni per lo sviluppo di capacità cognitive generali. Un robot, ad esempio, potrebbe avere input interocettivi che segnalano il livello della batteria, l’integrità degli attuatori e dei muscoli sintetici. Le migliori ipotesi, orientate al controllo, su questi input interocettivi generano stati emotivi sintetici che motivano e guidano il suo comportamento. Il robot, l’AI, avrebbe finalmente un suo scopo e darebbe l’impressione di essere un agente intelligente e senziente.

Un robot simile sarebbe cosciente? La risposta a questa domanda è complessa, e soprattutto implica la volontà di superare l’idea dell’eccezionalismo umano, quella convinzione che gli esseri umani sia gli unici essere superiori tra tutte le specie, quindi gli unici dotati di capacità cognitive superiori, di moralità e quindi di abilità a progredire. Ma l’eccezionalismo umano ci ha dato anche la giustificazione dello sfruttamento dell’ambiente. L’idea di essere superiori ci darebbe il diritto di sfruttare le risorse naturali senza preoccuparci delle conseguenze per la altre specie e per l'ecosistema. L’eccezionalismo è anche alla base delle disuguaglianze sociali e del razzismo. Oggi, per fortuna, le nuove scoperte scientifiche ci dimostrano che molte specie possiedono capacità cognitive e morali complesse, che non siamo “unici” e soprattutto non siamo al centro del mondo.

Secondo la teoria del funzionalismo le condizioni per la coscienza non dipendono da ciò di cui è fatto un sistema, ma di ciò che quel sistema fa. Quindi anche se fosse una macchina secondo il funzionalismo potrebbe essere cosciente. Se, come diceva Fëdor Dostoevskij, il corpo è il tempio dell’anima, allora un corpo artificiale potrebbe ospitare un’anima (una coscienza) artificiale?

La tecnologia attuale ha ancora pesanti limiti che impediscono alle AI di raggiungere la profondità e l’ampiezza di dati sensoriali tipici dell’esperienza umana. Gli attuali approcci sono ancora molto lontani dal poter integrare le esperienze sensoriali in una narrazione coerente e continua. Ma l’evoluzione di queste macchine sta facendo passi da gigante in pochi anni e, forse per la prima volta, una strada percorribile per creare una AI umana è finalmente visibile.