DeepSeek, l’intelligenza artificiale, la Cina, Socrate e quello che non sappiamo di non sapere

19 min letturaCrediamo che con il progressivo sviluppo della sua economia, la Cina debba gradualmente diventare un contributore netto di innovazione anziché continuare sempre a “scroccare il viaggio” come ha fatto fino ad adesso. Nei passati trent'anni di rivoluzione informatica, in pratica non abbiamo partecipato a nessuna vera e propria innovazione tecnologica. Siamo stati abituati a considerare la Legge di Moore come se piovesse dal cielo, restando sul divano ad aspettare 18 mesi in attesa che arrivassero hardware e software più potenti, affidandoci alla Scaling Law per ottenere risultati sempre migliori[…] Ma in realtà tutto questo è stato reso possibile solo attraverso gli sforzi incessanti di intere generazioni di comunità tecnologiche occidentali. È solo perché in passato non abbiamo partecipato a questo processo che ne abbiamo ignorato l’esistenza. […] Di fronte a tecnologie dirompenti, i “fossati” (moat) creati dal codice chiuso (closed source) sono temporanei. Persino l’approccio chiuso di OpenAI non può impedire ad altri di recuperare il divario. Per questo leghiamo il nostro valore soprattutto alla squadra: i nostri colleghi crescono attraverso questo processo, accumulano know-how e formano un’organizzazione e una cultura capaci di innovare. Questo è il “fossato” (moat) di innovazione che tutela il nostro valore aggiunto e la nostra proprietà intellettuale. […] La scelta di rendere open source e pubblicare articoli, in realtà, non ci costa nulla. Per un talento tecnico, vedere altri che seguono la tua innovazione dà un grande senso di soddisfazione. In effetti, l’open source è più un comportamento culturale che commerciale, e contribuire a esso ci fa guadagnare rispetto. Per un’azienda, inoltre, c’è anche un’attrattiva culturale nel farlo. […] Quello che manca alla nostra innovazione non è certamente il capitale, ma la fiducia e la conoscenza di come organizzare talenti ad alta densità per realizzare un’innovazione efficace. Riteniamo che l’intelligenza artificiale (AI) cinese non possa trovarsi per sempre nella posizione di chi insegue. Spesso diciamo che tra l’AI cinese e quella degli Stati Uniti ci sia un divario di uno o due anni, ma il vero gap è tra originalità e imitazione. Se questa situazione non cambia, la Cina sarà sempre soltanto un follower — e quindi è inevitabile intraprendere nuove esplorazioni.

(Intervista a Liang Wenfeng, fondatore di DeepSeek)

Nessuno aveva mai sentito parlare di DeepSeek finché di colpo tutti hanno sentito parlare di DeepSeek. Si tratta di una azienda cinese di intelligenza artificiale molto giovane, è stata fondata solo nel maggio 2023. DeepSeek si era fatta notare con il suo modello DeepSeek V3, uscito a dicembre per via alcune ottimizzazioni come il Mixture of Expert (MoE) e il Multihead Latent Attention (MLA), progressi molto importanti, ma non certo tali da tenere l'opinione pubblica con il fiato sospeso.

Le newsletter specializzate sull’Intelligenza Artificiale si riferivano a DeepSeek come alla “misteriosa azienda venuta dall’oriente” quasi fosse un film di Kung Fu. Non che fosse l’unico modello pubblicato dal paese del Dragone, anzi. La famiglia Qwen del colosso Alibaba è un ospite fisso nei benchmark dei chatbot di intelligenza artificiale, ma ce ne sono molti altri, come Ernie di Baidu, Doubao di Bytedance, modelli promettenti, ma la cui vita è resa difficile dalle restrizioni statunitensi all’export dei vitali chip per l’intelligenza artificiale, restrizioni che rendono il processo di addestramento dei modelli ancora più ostico di quanto già non sia. Quanto la Cina riesca effettivamente ad aggirare il blocco dei chip deciso da Washington è materia di intensa discussione.

A rendere più interessante DeepSeek è anche il profilo del fondatore Liang Wanfeng, uno che ha fatto molti soldi con gli hedge funds prima di lanciarsi anima e corpo in questa nuova avventura, che ha avviato con fondi propri. A differenza di molti suoi connazionali del ramo, Liang Wanfeng sembra ambire più al sogno di ottenere l’Artificial General Intelligence (AGI) che non all’immediato ritorno economico. L'AGI, o Intelligenza Artificiale Generale, ha molte definizioni (tra cui di recente anche una economica) ma può essere definita come una forma di intelligenza artificiale in grado di apprendere e svolgere tutti i compiti intellettuali alla portata di un essere umano.

Questa passione per l’AGI ha portato DeepSeek a scelte peculiari per una start up del genere, come puntare sulla ricerca di base e sulla filosofia open source anziché sulle applicazioni dal più rapido ritorno economico. Altre scelte, come quella di puntare sui giovani talenti sfornati ormai in grande quantità e qualità dalle università cinesi sembrano invece più in linea con l’attuale Zeitgeist, almeno da quando la prima amministrazione Trump ha stretto alcune viti all’ottenimento del visto per i ricercatori cinesi. Comunque DeepSeek era solo una delle tantissime start up ancora sconosciute che si stanno occupando di AI in quella che è ormai diventata una vera e propria corsa all’oro. Questo, in verità, si sarebbe anche potuto dire di moltissime altre realtà poi diventate fondamentali come Anthropic o Mistral, senza citare proprio OpenAI.

Il mondo dell’AI è così: prima non sei nessuno, poi di colpo sei sulla bocca di tutti, come ChatGPT a Novembre 2022. Sembra incredibile, ma tutto questo filone del quale ormai si parla notte e giorno è nato poco più di due anni fa, in seguito all’applicazione con una certa potenza di calcolo di alcuni risultati di ricerca e innovazioni scientifiche.

DeepSeek V3 nei test “outperforms” (supera), come si dice in gergo, non solo Llama (il competitor di Meta) e Qwen (il già citato modello di Alibaba), ma persino GPT4o di OpenAI. Tutto bello e interessante, ma questi modelli non di punta si superano abbastanza spesso nelle retrovie, come nei gran premi di Formula 1 tra la decima e la ventesima posizione accadono spesso molte cose spettacolari, ma alla fine l’unica cosa che conta davvero è chi arriva primo, e i modelli di punta di OpenAI sembravano ancora imbattibili (senza citare i vari Gemini di Google e così via).

A fine gennaio, però, succede qualcosa. DeepSeek rilascia R1, un modello che – come o1 e o3 di OpenAI – appartiene alla famiglia dei “reasoning model”, ovvero modelli che non solo simpatici affabulatori come Gpt4o, ma che sono in grado di seguire una catena di pensiero logico e spiegare l’origine dei loro pensieri. Per questo a differenza di Gpt4o, che inizia quasi immediatamente a concionare, Reasoning Models come o1 si prendono invece il loro tempo, a volte anche un minuto, per fornire poi di colpo una risposta ragionata con una catena di pensieri. Non che siano risposte infallibili – anche i reasoning models prendono cantonate colossali, ma almeno riescono a spiegare in dettaglio il filo logico del perché hanno detto corbellerie, mentre un LLM tradizionale ti può dire che i maiali volano con enorme scioltezza come fossero la cosa più naturale del mondo (le famose “allucinazioni”), salvo poi ritrattare senza colpo ferire quando glielo fai notare (“Chiedo scusa, in effetti i maiali non volano. Gli asini volano”).

Come spiegato nel technical paper di accompagnamento, R1 usa “large scale reinforcement learning” e altre ottimizzazioni come il “cold start” e una tecnica chiamata “distillation”, che rendono l’addestramento (training) e l’utilizzo del modello (inference) estremamente efficiente. Cosa vuol dire in soldoni? Che appunto il modello sembra si lasci addestrare con molti meno “soldoni”. Se addestrare un modello di punta sembra costare svariati miliardi tra elettricità e hardware, DeepSeek R1 (e il V3 da cui eredita le scelte architetturali) sembra si sia lasciato addestrare con 6 milioni di dollari di investimento, su un hardware abbastanza vecchio da non essere incorso nelle sanzioni statunitensi contro i chip di AI forniti alla Cina.

Questa notizia è arrivata il giorno dopo che Sam Altman, insieme al nippo-coreano Masayoshi Son di Softbank e la vecchia volpe Larry Ellison di Oracle, si erano presentati dal presidente Trump con un colossale progetto di infrastruttura di Intelligenza Artificiale, chiamato Stargate. Stargate è un nome che ci piace immaginare ispirato alla omonima serie televisiva influenzata da un antico Egitto in salsa fantascientifica, e che forse proprio per questo prevede investimenti faraonici in infrastrutture a dir poco stellari: oltre 500 miliardi di dollari, praticamente il PIL del Belgio.

A questo progetto Elon Musk aveva replicato acidamente: “Non avete i soldi, non siete coperti, me l’ha detto un amico”, trattenendosi a stento dall’aggiungere uno “gne gne” finale, sicuramente gonfio di gelosia per aver visto l’amichetto Trump così vicino all’odiato arcirivale Altman. Tuttavia, Musk non si era neppure sognato di dire: “Aspettate, forse non servono quattro centrali nucleari per addestrare l’intelligenza artificiale”. Musk magari avrebbe semmai detto che 500 miliardi erano pochi e ne servivano mille miliardi di dollari di investimento con otto centrali nucleari (il progetto Stargate non menziona l’origine dell’energia investita, la menzione delle centrali nucleari qui è da intendersi come espediente retorico). Con la sua start up di intelligenza artificiale xAI Musk sta cercando di fare qualcosa di simile per potenza installata: nel suo supercomputer Colossus, Musk ha installato oltre 100.000 chip Nvidia Blackwell H200 in soli 19 giorni, una impresa che normalmente richiederebbe un anno e che pertanto il CEO di Nvidia Jensen Huang ha definito “superumana”. Musk si guarda bene dal mettere in discussione la Scaling Law, ovvero una legge empirica che lega le prestazioni di un modello a fattori chiave come numero di parametri, la dimensione del set di dati di addestramento e le risorse computazionali. Più potenza, più dati, più energia = migliori risultati.

Nessuno insomma prima di DeepSeek sembra aver davvero sfidato i requisiti mostruosi in termini di hardware ed energia richiesti dall’addestramento di questi modelli, né il fatto che bisogna mettere sempre più parametri e risorse per il loro addestramento. Microsoft, pure una azienda solitamente attenta alle tematiche ambientali, ha di recente fatto riattivare un reattore nucleare per usare la sua energia nei propri data center. Se pensiamo che il cervello umano pur riuscendo ad apprendere praticamente tutto, consuma in stato di veglia tra i 10 e i 20 watt, ovvero come una piccola lampadina, capiamo che gli attuali paradigmi di apprendimento dell’Intelligenza Artificiale offrono ancora margini di sostanziale miglioramento.

Essendo più efficiente da utilizzare, DeepSeek non solo è molto più economico degli altri modelli analoghi, ma rilascia persino una versione da scaricare liberamente e da far girare sul proprio computer (qui una delle possibili guide a riguardo). Per far girare R1 serve hardware discretamente potente e più costoso di quello che in genere abbiamo noi a casa, si stima che un computer da 6.000 dollari possa essere sufficiente, forse non proprio alla portata di tutti, ma di sicuro rispetto ai 500 miliardi di dollari di Stargate o alla centrale nucleare di Microsoft sembrerebbe comunque un bel risparmio [nda, Non sono le stime di tutti, Amodei di Anthropic sostiene che l’addestramento di Claude Sonnet sia estremamente più economico, anche se non abbiamo ancora prove a riguardo].

Questo è il gancio del KO finale: nonostante l’aggettivo “open” nel nome, da tempo OpenAI non pubblica i suoi modelli di punta. Non è possibile scaricare GPT4o o o1 ed eseguirli sul proprio computer, modalità che ha il vantaggio di garantire l’assoluta riservatezza dei nostri dati (al modello può essere impedito l’accesso diretto alla rete). A questi modelli si può avere accesso, infatti, solo attraverso l’infrastruttura fornita da OpenAi (il sito openai.com o chatgpt.com, adesso diventato chat.com) oppure tramite un fornitore cloud di fiducia di OpenAI come Azure (il cloud di Microsoft). Il loro accesso non è propriamente a buon mercato: se il modello OpenAI o1 (quello raggiunto per prestazioni da DeepSeek) può essere utilizzato tramite abbonamento base a ChatGPT (circa 20 dollari al mese), per il modello di punta OpenAI o3 (ancora imbattuto) serve un abbonamento Pro da 200 dollari al mese.

DeepSeek R1 può essere utilizzato con maggiore risparmio in cloud, anche se l’applicazione fornita da DeepSeek risulta attualmente bloccata dal garante per la privacy (probabilmente per gli stessi motivi di riservatezza dei dati e di GDPR che portarono al blocco di OpenAI qualche tempo fa). In ogni caso, si può utilizzare la versione gestita da altri fornitori del servizio, oppure direttamente quella “Open Source”. Qui si richiede una necessaria delucidazione: quando si parla di applicazioni di Intelligenza Artificiale come questa, raramente i concetti dell’informatica tradizionale come “Open Source” possono essere utilizzati direttamente. Come ci ricorda lo studioso Daniele Gambit, sarebbe più corretto dire che DeepSeek R1 è un modello “open weights”, sono stati pubblicati i “pesi” della rete neurale, liberamente scaricabili ed utilizzabili. Ma non sono stati rilasciati né il programma esatto con cui questi pesi sono stati ottenuti e soprattutto non i dati su cui il modello è stato addestrato.

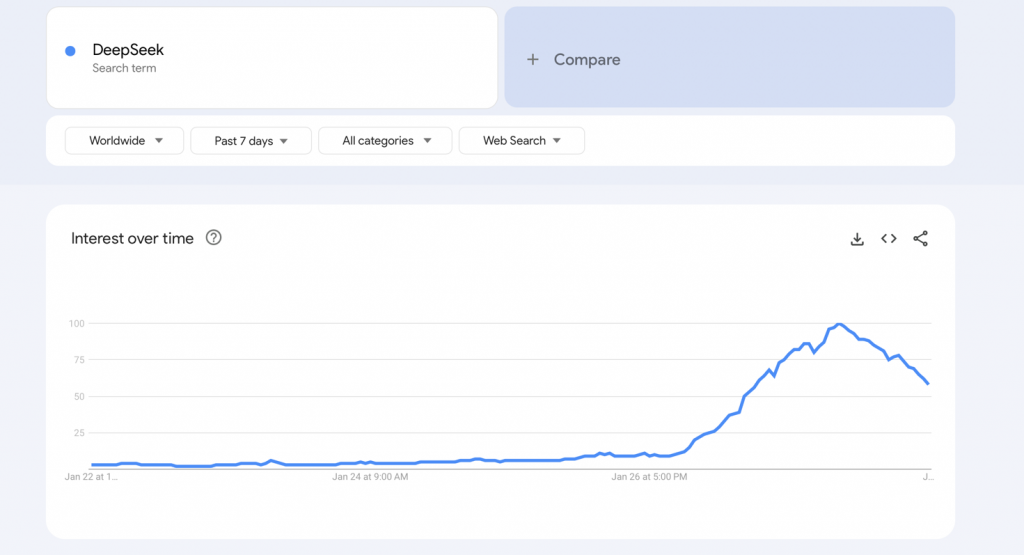

Ma questi sembrano dettagli, rispetto all’entusiasmo senza precedenti che DeepSeek ha scatenato. L’entusiasmo è stato al di là di qualunque aspettativa. Quando Valigia Blu mi ha proposto di scrivere un articolo divulgativo su DeepSeek, pensavo che quattro giorni di tempo fosse un lasso di tempo breve ma sufficiente a svolgere le necessarie ricerche sul tema: rileggere le interviste alla mente dietro DeepSeek sfogliate qualche settimana prima, riguardare il paper tecnico con le tecniche di ottimizzazione effettuate, magari confrontare qualche benchmark per avere numeri affidabili sulle prestazioni di DeepSeek. Mi sbagliavo. Già un giorno dopo la proposta, martedì scorso, la mia timeline era completamente intasata di commenti su DeepSeek. Chiunque conoscessi sembrava avere scritto un post al riguardo. X, Facebook, giornali online, giornali cartacei. Tutte le principali testate del paese ospitavano numerosi commenti sul tema.

Si parlava solo di DeepSeek. Credo che questo dica molto più di noi che di DeepSeek. Eppure non sono stati certo tempi avari di nuovi annunci riguardanti l’AI. OpenAI durante tutto il mese di dicembre ha fatto una specie di calendario dell’avvento presentando ogni giorno risultati molto importanti. Venerdì scorso, en passant, erano stati mostrati gli Operator di Open AI, un robusto passo avanti verso l’Agentic AI.

In realtà non c’è stato un giorno senza annunci dirompenti sull’AI, tra cui anche un tweet di OpenAI: “Bene adesso sappiamo come fare l’AGI”. Sam Altman, uno molto abile nelle pubbliche relazioni, si è congratulato con il team di DeepSeek. Anche Mark Chen, Chief Research Officer di OpenAI si è felicitato con i colleghi di DeepSeek. Non sono tutte rose e fiori: presto tra le due compagnie potrebbero volare anche stracci. Microsoft e OpenAI stanno verificando se DeepSeek abbia utilizzato in modo improprio la proprietà intellettuale di OpenAI per l’addestramento dei propri modelli.

Questa settimana c’è stato poco da festeggiare nella Silicon Valley: le quotazioni di borsa dei principali titoli sono crollate. Nvidia, famosa per avere quasi il monopolio dei chip utilizzati per l’AI, ha perso circa 600 miliardi di dollari di capitalizzazione, il 17%. Se sarà possibile addestrare questi modelli con così tanto risparmio, ci potrebbero essere in futuro molti meno chip dedicati da vendere, e le prospettive di fatturato potrebbero essere meno rosee. Questi mercati vivono di aspettative, si sa: comunque il titolo ha recuperato subito. Quello che non si è ancora recuperato è il senso di sicurezza che i colossi americani avevano prima di DeepSeek, la sicumera di avere tra le mani questa partita strategica dell’Intelligenza Artificiale, di averla praticamente già vinta.

Marc Andreessen, leggendario investitore della Silicon Valley attualmente molto vicino al governo Trump, ha parlato di “momento Sputnik” per l’intelligenza artificiale. Il momento Sputnik è un momento paragonabile alla reazione al lancio del satellite sovietico Sputnik da parte degli americani, quando il paese a stelle e strisce prese atto di un divario tecnologico a proprio spese con il rivale strategico sovietico.

L’espressione è piuttosto sfortunata perché si trova originariamente nel testo di Kai-Fu Lee “AI Superpowers”. Kai-Fu Lee utilizzò questa definizione quando AlphaGo di Google sconfisse il migliore giocatore umano nel tradizionale gioco cinese del Go, e la cosa fece realizzare al paese del Dragone i suoi ritardi nel settore e l’impellente bisogno di recuperare il divario in questo ambito così importante. Purtroppo però “AI Superpowers” è anche uno dei libri che ha contribuito a creare l'area di competizione strategica in un campo che pur così male si sarebbe prestato a una sfida del genere.

A modesto giudizio di chi scrive, questi modelli statistici di apprendimento mal si prestano alla concettualizzazione in termini di guerra fredda / corsa allo spazio / corsa agli armamenti che ne sta venendo fatta a tutti livelli. Pare una forzatura: si tratta di applicazioni, algoritmi, scoperte nel campo dell’ottimizzazione, della ricerca operativa, della statistica inferenziale, che richiedono pubblicazioni dei dati, ingegno, audacia, in cui un team di 50 persone può sbaragliare colossi enormi, come ha fatto OpenAI con Google due anni fa (anche se Google ha recuperato) e come sembra aver fatto adesso DeepSeek con OpenAI (vedremo come reagiranno).

Il paragone con la corsa spaziale, con Los Alamos e la bomba atomica, ovvero opere scientifiche e tecnologiche colossali, risulta forse improprio. In un settore in cui c’è ancora tanto da scoprire, queste metafore sono importanti e condizionano le narrazioni e la percezione del fenomeno, specie in un campo come questo dell’AI in cui l’effettivo modello di business non è ancora del tutto chiaro e le pochissime applicazioni che fanno veramente soldi sono quelle superspecializzate tipo GitHub Copilot (un assistente tramite AI allo sviluppo software, un'applicazione tanto interessante quanto di nicchia). In realtà, sappiamo tremendamente poco, i dati non sono di pubblico dominio: non sappiamo quanto costi davvero a OpenAI gestire il servizio ChatGPT, anche se vediamo la sua perenne sete di finanziamento. Mentre per salvare il pianeta stiamo giustamente attenti a non consumare troppi bicchieri di carta per il caffè, non abbiamo idea di quanta CO2 provochi veramente l’addestramento di un Large Language Model di punta, anche se si presagisce davvero poco di buono al riguardo.

Ci sono molte, troppe cose che sappiamo bene di non sapere. Eppure anziché affidarci a un esercizio socratico di modestia, umiltà e curiosità, preferiamo indossare l’elmetto. Vi invito a un gioco, leggete il testo in corsivo qui sotto.

I controlli sulle esportazioni hanno uno scopo vitale: mantenere le nazioni democratiche all'avanguardia nello sviluppo dell'intelligenza artificiale. Per essere chiari, non sono un modo per evitare la competizione tra Stati Uniti e Cina. Alla fine, le aziende di AI negli Stati Uniti e in altre democrazie devono avere modelli migliori di quelli cinesi se vogliamo prevalere. Ma non dovremmo concedere al Partito Comunista Cinese vantaggi tecnologici quando non è necessario. Data la mia attenzione ai controlli sulle esportazioni e alla sicurezza nazionale degli Stati Uniti, voglio essere chiaro su una cosa. Non vedo DeepSeek come un avversario e il punto non è quello di prenderli di mira in particolare. Nelle interviste che hanno rilasciato, sembrano ricercatori intelligenti e curiosi che vogliono solo creare una tecnologia utile.

Ma sono legati a un governo autoritario che ha commesso violazioni dei diritti umani, si è comportato in modo aggressivo sulla scena mondiale e sarà molto più libero in queste azioni se sarà in grado di eguagliare gli Stati Uniti nell'AI. I controlli sulle esportazioni sono uno dei nostri strumenti migliori per prevenire tutto questo, e l'idea che la tecnologia sempre più potente, che ha un maggior rapporto qualità-prezzo, sia un motivo per eliminare i nostri controlli sulle esportazioni non ha alcun senso.

Chi ha scritto questo testo? Un falco neocon residuato bellico dell’era Bush e riciclato tardivamente in salsa tecnologica, oppure Dario Amodei, il CEO di Anthropic, un geek con il dottorato di Fisica a Stanford? Se avete detto Amodei, purtroppo avete indovinato.

Crediamo nell'America perché l'America crede nell'innovazione. Chips, dati, energia e talento sono le chiavi per vincere sull'IA -e questa è una gara che l'America può e deve vincere. C’è una stima di 175 miliardi di dollari in fondi globali in attesa di investimenti in progetti di IA. Se gli Stati Uniti non attireranno questi fondi, essi confluiranno in progetti sostenuti dalla Cina progetti sostenuti dalla Cina rafforzando l'influenza globale del Partito Comunista Cinese. Le norme e i regolamenti per lo sviluppo e l'uso dell'IA dovrebbero essere basati sui valori democratici che il Paese ha sempre sostenuto. Ciò che noi vogliamo è una Intelligenza Artificiale Democratica”.

Questo invece cos’è secondo voi? Un pamphlet elettorale di Donald Trump pieno di fucili, crocifissi e hamburger oppure il documento dal sapore nazionalista “AI in America” rilasciato da OpenAI qualche settimana fa? La seconda, purtroppo.

Non che ormai Silicon Valley e politiche nazionaliste “America First” siano distinguibili. Anche senza citare il ruolo ormai fin troppo discusso di Elon Musk nell’attuale amministrazione della Casa Bianca, lo spettacolo dei CEO tecnologici allineati e coperti durante la cerimonia di inaugurazione della presidenza Trump aveva più il sapore del bacio della pantofola del sovrano che non di un normale rito democratico.

Forse il giubilo di molti per DeepSeek si spiega proprio per la svolta in chiave patriottardo-reazionaria di molti tecno-imprenditori. Non a caso a quelle latitudini si registrano anche reazioni di incredulità. Palmer Luckey, imprenditore tecnologico attivo prima nella realtà virtuale e adesso all’azienda di difesa AI Anduril e tradizionalmente associato alla destra americana ha scritto:

DeepSeek è oggettivamente impressionante, ma il livello di isteria in giro lascia pochi dubbi. La cifra di 5 milioni di dollari per l’addestramento è falsa. È promossa da un hedge fund cinese per rallentare gli investimenti nelle startup americane di intelligenza artificiale, far abbassare il valore di borsa contro i titani americani come Nvidia e nascondere l'evasione delle sanzioni. L'America è un terreno fertile per operazioni di propaganda psicologica come questa perché il nostro apparato mediatico odia le nostre aziende tecnologiche e vuole vedere fallire il presidente Trump.

Dose rincarata dall’esperto di Machine Learning ed ex dipendente Nvidia, Bojan Tunguz:

Quindi mi state dicendo che un hedge fund cinese ha rilasciato un LLM con affermazioni assolutamente non verificabili sul suo training, affermazioni che hanno finito per spazzare via trilioni di dollari nel mercato azionario statunitense, e noi dovremmo credere che non c'è nulla di losco in giro?

In effetti nessuno ha verificato l’addestramento di DeepSeek R1, non sappiamo su quali risorse sia stato effettivamente fatto girare, non sappiamo se le sanzioni siano state aggirate o meno. Si potrebbe dire che non sappiamo nemmeno come sono stati addestrati gli altri language models di punta, ma c’è da dire che loro, a onore del vero, non rilasciano proprio informazioni di questo tipo. DeepSeek R1 potrebbe avere utilizzato dieci volte le risorse computazionali di OpenAI, o un decimo. Possiamo verificare solo quello che gira in locale, che in effetti, almeno in fase di inference, ovvero utilizzo, è piuttosto efficiente e risparmioso. Noi sappiamo di non sapere, ed è inutile far finta di sapere.

Si farebbe meglio a fare come Andrej Karpathy, che loda il risparmio di risorse senza negare che la potenza computazionale superiore possa servire. O come fa uno dei padri del Deep Learning Yann LeCun, che vede in questo risultato non una vittoria della Cina, quanto una vittoria dell’Open Source, un modello sempre da lui attivamente supportato. Anche grazie all’impegno di LeCun dobbiamo il fatto che Meta abbia sempre rilasciato alla comunità i propri modelli da scaricare e provare liberamente.

Nel momento in cui anche il presidente Trump si è sentito in dovere di metterci in guardia da DeepSeek, molti utenti si sono concentrati sul fatto che non è possibile fare domande ai language models di DeepSeek su temi politicamente scottanti in Cina come la condizione degli Uiguri, i fatti di Tienanmen o fargli esprimere una critica sull’operato del presidente Xi Jinping. Se posso essere sincero, stupirsi di queste cose mi sembra un esercizio abbastanza provinciale. I modelli cinesi sono verificati per la conformità “politica” di alcuni risultati, conformità che rende il modello rilasciabile. Ostinarsi a chiedere a un modello cinese di Tienanmen è come andare a visitare la città santa di La Mecca alla ricerca di alcool, lamentandosi di non averne trovato. I modelli cinesi hanno queste “safety guidelines”. Dal loro punto di vista ha senso averli, visto che gli LLM sono anche degli Information Retrieval Systems. Se i motori di ricerca cinesi sono censurati, perché non dovrebbero esserlo anche i Large Language Models cinesi, che spesso svolgono la stessa funzione?

Non sto assolutamente difendendo l’indifendibile censura o sostenendo che questo sia giusto, non lo è: mi stupisce solo lo stupore generale. Ci sono altre safety guidelines dei modelli occidentali di cui nessuno giustamente si scandalizza, ma che seguono lo stesso concetto. Un LLM non dovrebbe dirti come produrre una bomba, per esempio. È in ogni caso quasi sempre possibile aggirare queste impostazioni di sicurezza del modello facendolo girare in locale.

Ci sono talmente tante cose che si possono chiedere a un LLM: forse è proprio questo a rendere il discorso così interessante. È la prima tecnologia con cui è possibile dialogare. Non si dà un comando a un prompt, non si clicca, si sostiene una conversazione cercando di estrarre conoscenza, si fa come faceva Socrate. Si dialoga e si prova a estrarre il sapere all’interno, come la famosa arte “maieutica”, l’arte della levatrice, la conoscenza che è nascosta dentro il modello. C’è talmente tanto che sappiamo di non sapere, e ancora di più che non sappiamo di non sapere. La comparsa di DeepSeek andrebbe presa non come l’occasione per levare minacciosi tamburi di guerra, ma come un'epifania, una rivelazione.

Dovremmo farci domande, fare come Socrate, interrogarci.

Una America che si riscopre neoimperiale e assertiva, può davvero basare il suo progresso e la sua prosperità solo su queste tecnologie? Come fa questa imponente forza soggiogatrice di “Groenlandie” e “Canali di Panama” ad avere una crisi di coscienza così devastante quando dieci nerd cinesi scoprono un nuovo algoritmo più ottimizzato? Durante la guerra fredda quando un matematico sovietico dimostrava un nuovo teorema non è che qualcuno a Washington aveva una crisi di panico come sta avvenendo adesso.

Eppure qui le reazioni, come giustamente le definisce di nuovo Andreessen, sono state isteriche. Ma una ragione c’è. Si fa un grande parlare del robusto stato di salute dell’economia americana, rispecchiata dall’andamento delle quotazioni di borsa. Si omette spesso però di notare che oltre metà della performance nel 2024 dell’indice americano S&P 500 è dovuta ai guadagni registrati dai colossi del settore tecnologico come Google, Amazon, Microsoft, Meta, Nvidia, Apple e Tesla.

Ma non è scolpito nella pietra che l’addestramento delle intelligenze artificiali debba per forza avvenire con le metodologie dominate da Nvidia, ovvero il calcolo matriciale, eredità dal rendering 3d dei videogiochi. Magari si scopriranno nuove metodologie di calcolo e nuovi chip con un design completamente diverso e più efficiente, come ad esempio le LPU di Groq, o qualcosa di ancora diverso. Non lo sappiamo.

Non sappiamo se l’approccio scelto da Tesla per ottenere il Full Self Driving, l’FSD, ovvero la macchina a guida autonoma, esclusivamente basato sulla visione sia quello più efficiente. Magari funzionerà meglio quello basato su nuovi LIDAR più economici. Non lo sappiamo. Forse l’attuale approccio ai Large Language Models basato su modelli autoregressivi, in cui – ipersemplificando - ogni “token” viene emesso sulla base della probabilità precedente, hanno davvero dei limiti invalicabili, come hanno provato a dirci Yann LeCun, Ilya Sutskever e persino il genio universale Stephan Wolfram ai tempi.

Nell’intervista che ho riportato all’inizio ho riportato in grassetto la parola “Moat”, recinto di difesa. Non è un caso: sono le parole di un memo interno di Google trapelato alla stampa in cui si analizzava che nel campo dell’Intelligenza Artificiale sembrano non esserci “Moat”, fossati invalicabili a difesa di un monopolio come può averlo Google sulle ricerche su internet. Se addestriamo sugli stessi dati e con gli stessi algoritmi, otterremo più o meno gli stessi risultati, con qualche piccola differenza. Alla fine se non è zuppa, è pan bagnato, e se otteniamo il pan bagnato con un metodo più efficiente come ha fatto DeepSeek non cambia la sostanza del discorso.

Quel memo, rivelatosi profetico, anticipava proprio la vittoria dei modelli open source di cui DeepSeek V3 e R1 sono esponenti, come ci ricordava anche Yann LeCun, che su questa battaglia ha investito tutto. Quindi anziché batterci maschiamente il petto e suonare i tamburi di guerra collezionando autotreni di microchip, imitiamo i Large Language Models e facciamoci anche noi delle domande. Il vero successo di DeepSeek e la relativa vittoria tattica cinese, è stato mostrare con relativamente pochi mezzi la debolezza dell’avversario, indurre un mancamento che però è rivelatore, sarebbe saggio cogliere questi segnali.

Si sfrutti questo momento per una riflessione. Forse, come dice in una intervista l’economista di Harvard Dani Rodrik: “L’America non è nemmeno lontanamente potente come si immagina Trump”. Se vogliamo dare ragione a Andreessen, forse DeepSeek potrebbe davvero essere il momento Sputnik dell’America contemporanea. Solo che stavolta – come ha scritto lo storico Niall Ferguson – potremmo esserci noi occidentali nei panni di quella che fu l’Unione Sovietica.

Immagine in anteprima via medium.com