Attuazione direttiva copyright e art. 17 tra pressione delle lobby, filtri preventivi, rimozione dei contenuti e diritti dei cittadini

18 min letturaUna regolamentazione complessa e difficile

Dopo la chiusura della consultazione (12 settembre) con la quale la Commissione europea ha condiviso le sue opinioni sull’attuazione (si attende la pubblicazione dei risultati per fine aprile), la direttiva copyright ormai approvata attende le relative norme nazionali di recepimento. I singoli Stati hanno la possibilità di adattare la normativa alle proprie legislazioni (entro il 7 giugno 2021), ed esiste quindi un margine, anche se limitato, nell’applicazione delle norme. La Commissione europea ha anche tenuto degli incontri (primo, secondo, terzo, quarto, quinto, sesto) con gli stakeholders (trasmessi in streaming) al fine di redigere delle linee guida per aiutare i legislatori nazionale nel difficile compito di attuazione dell’art. 17 della direttiva, il più controverso.

Dai meeting è purtroppo emersa l’intenzione di molti partecipanti di non contribuire realmente al processo costruttivo, quanto piuttosto di mantenere le norme vaghe in modo da favorire applicazioni estremamente discrezionali. Molti partecipanti hanno espressamente chiesto massima libertà contrattuale e invitato la Commissione a non fornire alcun orientamento vincolante. Appare evidente, inoltre, la tendenza a spostare sul piano tecnico l’attuazione delle norme, in modo che l’effettiva rimozione di contenuti più che dipendere dagli articoli di legge dipenderà dalle tecnologie utilizzate e dai parametri impostati (quindi dalle aziende e dalle scelte dei singoli governi).

Al momento risultano proposte di attuazione da parte dei seguenti Stati:

- Francia, che tende ad inasprire le norme della direttiva mostrandosi non particolarmente interessata ad introdurre alcuna ulteriore tutela per i diritti dei cittadini, prevedendo addirittura (causa pandemia) di attuare le norme di cui all’art. 17 tramite decreto (senza discussione parlamentare);

- Germania, che esplora le flessibilità previste dalla direttiva introducendo nuove eccezioni (parodia, usi minimi non commerciali), poi però ridotte in una seconda proposta (gli usi minimi), prevedendo il preflagging per evitare rimozioni di contenuti leciti e sanzioni per i titolari dei contenuti che richiedono rimozioni di contenuti leciti, e quindi in sostanza difficoltà per l’applicazione di filtri automatizzati per la rimozione dei contenuti online;

- Paesi Bassi, il primo paese che ha completato il processo di implementazione (la legge entra in vigore il 7 giugno), attenendosi strettamente alle norme pur evidenziando la possibilità di recepire gli orientamenti della Commissione;

- Finlandia, che ha tenuto un’audizione pubblica sull’implementazione dell’art. 17, aperta a tutti gli interessati (caso più unico che raro), e che invece di limitare l’uso di filtri automatici a un sottoinsieme di caricamenti in cui vi è un'elevata probabilità di violazione, elimina completamente il blocco automatico dei caricamenti degli utenti (ritenendolo in violazione dell’art. 17, par. 9), ma non il rilevamento automatico di potenziali violazioni;

- Austria, che avanza una proposta piuttosto simile a quella tedesca.

Va però puntualizzato che l’originale impianto della proposta della Commissione europea è stato modificato nel corso del tempo. Quello che era un intervento di semplice rafforzamento delle posizioni dei titolari dei diritti (in tema di level playing field, leggi Digital Service Act: l’Europa prepara le nuove regole per le piattaforme online), oggi è diventato un coacervo complesso di norme e disposizioni che serve una serie di obiettivi in contrasto tra loro.

Lobbying, lobbying, lobbying...

È importante non dimenticare che l’approvazione della direttiva ha vissuto momenti drammatici, con il lobbismo dei produttori dei contenuti, degli editori, ma anche delle grandi aziende del web, che ha raggiunto vette mai viste. Addirittura la stessa Commissione europea pubblicò un articolo su Medium nel quale stigmatizzava le critiche all’articolo 17 (all’epoca 13) definendo i critici “The Mob” (come gli oltre 5 milioni di firmatari della petizione) e insinuando che fossero persone stupide che seguivano senza criterio le campagne delle grandi aziende del web, così facendo proprio quanto suggerito dalle campagne lobbistiche dei produttori. L’insinuazione era che chi criticava l’articolo della direttiva era “pagato da Google” così non accettando l’idea che oltre alla posizione dei produttori e quella delle aziende del web ci fosse una terza e distinta posizione di chi valorizza i diritti dei cittadini. L’articolo è stato poi rimosso riconoscendo che “il suo linguaggio e il suo titolo non erano appropriati e ci scusiamo per il fatto che sia stato considerato offensivo”. Analogamente il Parlamento europeo commissionò un video “celebrativo” della direttiva direttamente ad Agence France Press Europe, consentendo a una lobby pro-produttori di diventare la “voce” di un organismo eletto, e tutto coi soldi dei cittadini europei.

L‘intensissima attività di lobbying delle aziende, i titolari dei diritti e le stesse piattaforme, ha avuto un contraltare da parte delle associazioni per i diritti civili dei cittadini, e dei cittadini stessi che hanno inviato petizioni e lettere e sono scesi in piazza. Tutto ciò alla fine ha portato a profonde modifiche della normativa, che adesso include specifici diritti dei cittadini e garanzie per l’attuazione di tali diritti. Una riscrittura in tal senso è stata alla fine obbligata per consentire un’adozione della regolamentazione.

Nel corso dei meeting è emerso, nonostante tutto, l’impegno della Commissione europea a mantenere il difficile equilibrio delle norme, in particolare dell’articolo 17, il più controverso, proponendo soluzioni tese a bilanciare i diritti in gioco, anche accogliendo proposte provenienti dalle parti in causa. L’attuale impegno della Commissione, purtroppo, è stato demonizzato in più occasioni dai titolari dei diritti, ma anche da alcuni Stati, come la Francia il cui governo si è mostrato particolarmente intransigente nell’attuazione delle norme.

Gli elementi chiave sui quali si sono focalizzate le discussioni sono i seguenti:

- L’articolo 17 dovrebbe essere considerato lex specialis rispetto alla direttiva InfoSoc. In tema si è accesa una diatriba, con alcuni autori che sostengono la tesi della lex specialis e altri che ritengono, invece, che solo gli elementi dell’art. 17 siano “speciali” rispetto al resto della normativa europea. Infine altri ritengono che l’art. 17 sia solo un “chiarimento” rispetto alla precedente normativa (per cui i provider avrebbero sempre eseguito atti di comunicazione al pubblico e quindi violato la normativa).

Ma è dirimente la posizione della stessa Commissione europea che considera l’articolo 17 una legge speciale rispetto al diritto di comunicazione al pubblico (direttiva InfoSoc, art. 3). Il punto è che l’art. 17 si occupa di uno specifico problema del settore, usa proprie definizioni, introduce circostanze specifiche e modifica parzialmente la disciplina di cui alla InfoSoc. Non si tratta di una questione meramente tecnica, ma di un aspetto fondamentale. Se l'articolo 17 è lex specialis, infatti, gli Stati europei hanno decisamente maggiore libertà nel decidere come le piattaforme possono ottenere l’autorizzazione per le opere immesse dagli utenti, non essendo vincolati dalla InfoSoc. - L’obiettivo dell’art. 17 è l’autorizzazione, e dovrebbe prevedere esplicitamente forme di autorizzazione differenti dalle licenze, compreso le eccezioni al copyright.

- Le eccezioni al copyright non sono solo quelle previste dalla direttiva, ma dovrebbero essere tutte quelle previste ai sensi dell’art. 5 direttiva InfoSoc e quelle previste a livello nazionale.

- I meccanismi di reclamo successivi non sono sufficienti, ma occorre che le soluzioni implementate dalle piattaforme non impediscano il caricamento di contenuti legittimi. I titolari dei diritti (e il governo francese) sostengono che i meccanismi di reclamo successivi (alla rimozione) sono più che sufficienti (così come era previsto dall’originario art. 13), ma la Commissione sostiene (e con forza) il contrario. Se l’obiettivo è quello di garantire che non sia impedito il caricamento di contenuti legittimi un reclamo successivo (e quindi il ripristino ex post) è insufficiente, occorre che le tecnologie utilizzate (es. filtri di upload) non blocchino contenuti che non sono in violazione del copyright. Cioè i filtri di caricamento possono essere utilizzati solo se non portano alla rimozione di contenuti legittimi (art. 17.7).

The cooperation between online content-sharing service providers and rightholders shall not result in the prevention of the availability of works […] uploaded by users, which do not infringe copyright […], including where such works or other subject matter are covered by an exception or limitation.

- Gli Stati nazionali non dovrebbero imporre soluzioni tecnologiche specifiche (es. filtri di upload) alle piattaforme per ottemperare agli obblighi previsti dall’art. 17. La soluzione della Finlandia, infatti, non prevede filtri di upload preventivi, ma solo una rimozione successiva se il titolare riesce a fornire una motivazione adeguata.

- I caricamenti che non appaiono in violazione dovrebbero essere tenuti online fino al termine della revisione.

I problemi dei sistemi di filtraggio

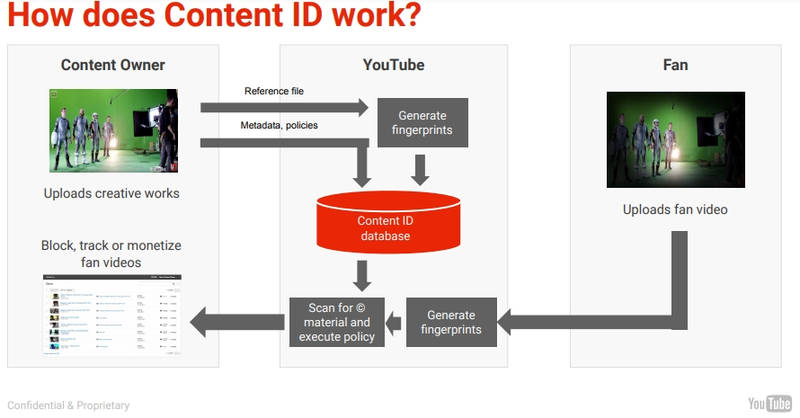

Uno degli elementi fondamentali per l’attuazione dell’art. 17 della direttiva è l’obbligo di non impedire il caricamento di contenuti legittimi, che ovviamente è difficile da conciliare con il filtraggio preventivo dei contenuti. Nel terzo meeting in particolare ci si è soffermati sulle problematiche dei sistemi di filtraggio. Sono state visionate sette presentazioni da parte di aziende che dispongono di tecnologie di riconoscimento dei contenuti interne (YouTube e Facebook) o che offrono tali tecnologie alle piattaforme (Audible Magic, PEX, Videntifier e Smart Protection) e tutte queste società hanno esaltato le virtù dei loro algoritmi di corrispondenza dei contenuti, rivendicando un numero trascurabile di falsi positivi (contenuti erroneamente identificati) e vantandosi delle loro capacità di identificare il contenuto anche quando è stato modificato per evitare il rilevamento. Ma è anche emerso senza ombra di dubbio che gli algoritmi di filtraggio (ACR, automatic content recognition) non sono in grado di comprendere il contesto, ma si limitano a verificare i contenuti immessi dagli utenti con un database di contenuti (nella disponibilità dei soli grandi produttori e spesso non condiviso con altri). Insomma, non sono in grado di verificare se un contenuto è legittimo in base ad una eccezione al copyright.

YouTube: We do not look at the context. … there are no fixed rules, as an engineer there is no rule written that would describe for me that I can tell the machine that this is a copyright exception.

YouTube: non guardiamo al contesto. ... non ci sono regole fisse, come ingegnere non c'è nessuna regola scritta che mi indichi come dire alla macchina che questa è un'eccezione al copyright.

Our matching system is not able to take context into account; it is just seeking to identify whether or not two pieces of content match to one another (Facebook, 16-12-2019)

Il nostro sistema di abbinamento non è in grado di tenere conto del contesto; cerca solo di identificare se due parti di contenuto corrispondono o meno tra loro.

Copyright exceptions require a high degree of intellectual judgement and an understanding and appreciation of context. We do not represent that any technology can solve this problem in an automated fashion. Ultimately these types of determinations must be handled by human judgement (Audible Magic, 16-12-2019).

Le eccezioni al copyright richiedono un alto grado di giudizio intellettuale e una comprensione del contesto. Nessuna tecnologia può risolvere questo problema in modo automatizzato. Alla fine questo tipo di valutazione può essere gestito solo da esseri umani.

Numerosi studi e discussioni sull’efficacia dei filtri hanno evidenziato le seguenti problematiche:

- Informazioni errate sui diritti portano a rimozione di contenuti legittimi.

Le rimozioni conseguenti a errata attribuzione dei diritti sono ampiamente documentate su YouTube (Sony rimuove opera in licenza libera). I sistemi di filtraggio eseguono azioni automatizzate in base agli input (richiesta di rimozione di video con solo “rumore bianco”) inseriti dalle grandi società di produzione che hanno un accesso privilegiato ai contenuti di YouTube (la CBS rimuove contenuti della CBS) potendo rimuovere contenuti direttamente, per cui l'indicazione della titolarità di un’opera determina la rimozione di contenuti senza che questi violino alcun diritto. Le informazioni non sono verificabili in alcun modo non essendoci un database pubblico e quindi il tutto avviene internamente. È anche accaduto che contenuti nel pubblico dominio (NBC e Disney rimuovono contenuti della NASA nel pubblico dominio, leggi Se i filtri del copyright rimuovono anche Beethoven) siano attribuiti erroneamente, con ciò rimuovendo opere del tutto lecite. - I filtri non comprendono il contesto e non riescono a riconoscere gli usi legittimi.

I sistemi di filtraggio, come risulta dai meeting e dallo studio della Commissione JURI (The impact of algorithms for online content filtering or moderation), si limitano a verificare la corrispondenza tra contenuti, e quindi non sono in grado di stabilire se l’uso di quel particolare contenuto è legittimo in quanto basato su un’eccezione al copyright (vedi video di una protesta contro il razzismo rimossi da YouTube a Facebook perché contenevano musiche soggette a diritti). Mentre le aziende tendono a sostenere che il semplice fatto che un’opera sia una “copia” (quindi corrispondente ad una nel catalogo del titolare), in realtà ciò che è illegittimo è l’uso della copia, non la copia in sé. - I filtri in alcuni casi non riescono a differenziare opere molto simili.

In alcuni casi capita che i filtri (che operano su “impronte” delle opere) non riescano a distinguere adeguatamente tra opere molto simili tra loro. Ad esempio nel caso in cui un autore suoni opere nel pubblico dominio (Rhodes che esegue Bach) quando nel catalogo di una major vi è l’esecuzione della stessa opera (ma soggetta a diritti). Ciò porta alla rimozione di opere del tutto lecite, con gravi danni anche economici all’artista.

L’obbligo di non rimuovere contenuti legittimi

Un recente studio, limitato alla Francia, valuta in circa 700mila gli utenti che avrebbero subito una rimozione ingiustificata di contenuti immessi online. In tale prospettiva si sono distinte due proposte, una è quella della Germania, l’altra proviene dalla stessa Commissione europea.

La proposta tedesca (qui la bozza) si basa sul preflagging, cioè gli utenti sarebbero autorizzati a contrassegnare come legittimi i contenuti da loro caricati, in modo che non siano bloccati dai filtri della piattaforma. I contenuti così taggati potrebbero essere bloccati solo se si valuta che il caricamento è in palese violazione delle norme. Questa proposta ha ricevuto critiche non solo dalle associazioni dei titolari dei diritti ma anche dalle stesse piattaforme (Google e Facebook) che hanno fatto notare come sarebbe impraticabile perché porterebbe facilmente ad abusi da parte degli utenti. Per questo la proposta parrebbe abbandonata a favore di una nuova versione molto simile alla proposta della Commissione.

La Commissione europea, invece, suggerisce un meccanismo “match and flag” (proposto da un gruppo di accademici). Se i filtri di upload rilevano la presenza di un’opera di terze parti e l’uso non è ritenuto in “probabile” violazione, sarà inviata una notifica all’autore dell’upload per consentirgli di dichiarare che l’uso è legittimo. L’utente potrà quindi taggare il caricamento come legittimo, e in questo caso la piattaforma dovrà avviare una revisione umana del caricamento, laddove il contenuto rimane disponibile fino al termine della revisione.

Il meccanismo proposto dalla Commissione riconosce che le tecnologie di riconoscimento del contenuto non sono in grado di valutare il contesto, e quindi stabilire se l’uso del contenuto è coperto da una eccezione o uso legittimo. Cioè che fanno è solo verificare se un contenuto corrisponde a un altro. La proposta della Commissione si basa sulla differenziazione tra usi in “probabile violazione” e usi legittimi, purtroppo senza specificare in quali casi si ritiene “probabile” la violazione. La Commissione fa tre esempi per chiarire:

- Un video di 30 minuti di cui 29 corrispondono a un video di un titolare dei diritti potrebbe essere in violazione a meno che non sia di dominio pubblico o l’uso sia stato autorizzato;

- Un video composto da brevi estratti con uno o due minuti di scene diverse da film di terze parti, accompagnato da contenuti aggiuntivi, come commenti dell’utente, potrebbe essere legittimo perché coperto dall’eccezione di citazione;

- Immagini fisse corrispondenti solo parzialmente all'impronta di un’immagine professionale potrebbero essere legittime in quanto parodia o meme.

La proposta match and flag, sia nella versione tedesca che in quella della Commissione, di fatto presuppone che tutte le piattaforme siano in grado di verificare la corrispondenza di contenuti in tempo reale, in modo da informare gli autori dei caricamenti al termine dell’upload. Ma non è chiaro se la capacità di trovare una corrispondenza del contenuto in tempo reale sia nella disponibilità di tutte le piattaforme. Si tratta di una tecnologia piuttosto costosa, e questo potrebbe essere un problema per le piccole aziende. Se i legislatori nazionali imporranno come obbligatori i filtri di caricamento questo potrebbe essere in contrasto con il principio di proporzionalità previsto dall’art. 17, par. 5. Teniamo presente che nel momento in cui la direttiva andrà in vigore gli avvisi riguarderanno non solo i nuovi caricamenti ma anche tutti i contenuti già presenti sui server, laddove la proposta tedesca non prevede la possibilità di flaggare come legittimi contenuti già caricati. Questo porterebbe ad una cancellazione di molti contenuti legittimi (es. in pubblico dominio o licenze libere).

Come sottolineato da Communia Association (in risposta alla consultazione della Commissione) l’approccio utilizzato demanda agli accordi tra piattaforme e titolari dei diritti la fissazione dei parametri e delle tecnologie per la rimozione dei contenuti online, senza alcun obbligo di ascoltare le associazioni dei cittadini, anche se le decisioni delle aziende di fatto finiscono per limitare o cancellare del tutto i diritti fondamentali dei cittadini stessi. La retorica utilizzata (specialmente da parte dei titolari dei diritti) è che se si è contro tali proposte si sarebbe contro ai diritti dei creatori e degli artisti (quando in realtà si discute solo dei diritti delle grandi aziende).

La tecnologia di matching è sostanzialmente basata su un database di impronte detenuto dalle aziende (la cui implementazione è costosa e in genere non viene condiviso con altre aziende, rendendo complicato alle piccole e medie aziende implementare algoritmi di filtraggio), in modo da poter comparare tali impronte a quelle ricavate dagli upload. Sarebbe estremamente utile che il database delle impronte fosse pubblico e ispezionabile per verificare la corretta implementazione. La trasparenza relativamente al numero e ai dettagli delle rimozioni effettuate da algoritmi è un elemento essenziale per il corretto funzionamento del sistema, così come evidenziato dallo studio commissionato dalla Commissione Juri (The impact of algorithms for online content filtering or moderation). Tra le iniziative che richiedono trasparenza degli algoritmi ricordiamo i Santa Clara Principles.

L’impressione purtroppo è che il controllo dell’ecosistema digitale e degli spazi pubblici di discussione (Youtube, Facebook, ecc…) ormai è sempre più demandato alle grandi aziende. Con la direttiva copyright ciò che cambierà è che tali piattaforme dovranno stringere accordi con i titolari dei contenuti (che sono sempre grandi multinazionali) e tra di loro decideranno come gestire gli spazi dell’ecosistema digitale. I diritti dei cittadini saranno sempre più compressi senza una reale possibilità di far sentire la loro voce.

Impatto sulla protezione dei dati personali (GDPR)

Un ulteriore aspetto da non dimenticare è che i sistemi di filtraggio dei contenuti impattano anche sul diritto alla tutela dei dati personali degli individui.

Ai sensi dell'articolo 22 del GDPR, l’utente ha il diritto di “non essere sottoposto a una decisione basata unicamente sul trattamento automatizzato, compresa la profilazione, che produca effetti giuridici che lo riguardano o che incida in modo analogo significativamente sulla sua persona”. Tale norma tutela gli utenti da decisioni prese unicamente da algoritmi che possono danneggiare l’utente.

I contenuti eventualmente rimossi dai sistemi di filtraggio provengono da utenti che generalmente hanno creato un account col servizio online, per cui l’algoritmo tratterà i dati dell’utente. Anche nel caso di contenuti anonimi vi sono i metadati (es. indirizzo IP) che sono comunque soggetti alla normativa europea. Non dimentichiamo che, a differenza di quanto sostengono i titolari di diritti, il processo di valutazione della legittimità della pubblicazione di un contenuto non può mai essere limitato alla banale corrispondenza tra due contenuti ma deve essere considerare se un certo (specifico) utente ha il diritto di pubblicare quel contenuto.

Le linee guida sui processi decisionali automatizzati sviluppate dal WP29 sostengono che l’art. 22 si applica agli algoritmi che valutano i contenuti generati dagli utenti che vengono caricati su una piattaforma. E spiegano che anche quando il giudizio di un filtro non ha un impatto legale, rientra comunque nell'ambito di applicazione dell'articolo 22 del GDPR se il processo decisionale ha il potenziale per influenzare in modo significativo il comportamento della persona interessata, ha un impatto prolungato sull'utente, o porta a discriminazioni nei confronti dell'utente (come potrebbe essere la rimozione di un contenuto pubblicato nell’ambito delle attività lavorative che potrebbe portare a conseguenze economiche, o la rimozione di un video di un artista commissionato da un terzo).

Poiché siamo in presenza di un vero trattamento di dati, occorre stabilire una base giuridica. I filtri automatizzati sono difficilmente giustificabili in quanto “necessario per la conclusione o l'esecuzione di un contratto” (art. 22 GDPR), anche perché l’introduzione di tale clausola finirebbe per violare l’art. 3 della Unfair Contract terms Directive poiché “determina, a danno del consumatore, un significativo squilibrio dei diritti e degli obblighi delle parti derivanti dal contratto” (vedi anche The impact of algorithms for online content filtering or moderation, punto. 4.5). Inoltre, la nuova normativa prevede delle “misure preventive” per garantire la non disponibilità di contenuti protetti da copyright, ma non impone dei sistemi di filtraggio, quindi non si potrebbe nemmeno dire che gli algoritmi sono previsti da una legge.

A giustificare l’utilizzo di sistemi totalmente automatizzati rimarrebbe solo il consenso, il quale deve essere: inequivocabile, libero, specifico, informato, verificabile e revocabile.

Insomma, gli algoritmi producono significativi effetti negativi sugli utenti, e in tal senso devono rispettare anche la normativa in materia di protezione dei dati personali, anche se questo aspetto pare non sufficientemente considerato nelle discussioni sull’attuazione della direttiva.

Le critiche alla proposta della Commissione

Entrambe le proposte (Germania e Commissione) sono state criticate dalle associazioni di categoria dei titolari dei diritti (lettera del settembre 2020) che si dicono preoccupate per il fatto che la Commissione (a loro dire) starebbe andando contro l'originale obiettivo della direttiva, cioè la realizzazione di un alto livello di protezione per i titolari dei diritti e i creatori e quindi un “level playing field” nel Digital Single Market (vedi Digital Service Act: l’Europa prepara le nuove regole per le piattaforme online).

Anche la Francia (risposta alla consultazione della Commissione) ha aspramente criticato la proposta della Commissione sostenendo che starebbe svuotando l’articolo 17 del suo contenuto originario. La Francia, infatti, si è caratterizzata per un’attuazione dell’art. 17 piuttosto intransigente. Ad essa si sono aggiunti altri 6 governi nazionali (Italia, Spagna, Portogallo, Grecia, Danimarca, Croazia).

Il problema è che sia i titolari dei diritti che il governo francese danno una lettura dell’art. 17 della direttiva europea che non è conforme all’articolo medesimo. Il riferimento allo spirito dell’articolo è improprio, perché l’articolo in questione, nato come art. 13, è stato massicciamente modificato nel tempo. Originariamente era, infatti, un intervento di rafforzamento delle posizioni dei titolari dei diritti nei confronti delle piattaforme del web (nell’ottica del level playing field), ma si è trasformato a seguito di una penetrante attività di lobbying di tutte le parti in causa, per diventare qualcosa di completamente diverso. Durante la sua gestazione si è però notato che senza un corretto bilanciamento con i diritti fondamentali dei cittadini l’articolo in questione non avrebbe potuto esistere all’interno dell’ordinamento europeo, per cui oggi, come art. 17, introduce dei nuovi diritti per gli utenti e fornisce garanzie significative perché tali diritti siano preservati.

Insomma, il nuovo articolo 17 è una norma di compromesso, che mira a bilanciare i diritti delle aziende (titolari dei diritti e piattaforme) non solo tra di loro, ma anche con i diritti fondamentali dei cittadini. Nella loro attività di lobbying le aziende non hanno compreso (o voluto comprendere) che non esiste più l’art. 13 come originariamente previsto e voluto. Rievocare l’originario spirito della norma è senza senso, le norme si devono applicare come sono adesso. È abbastanza evidente che l’attività di lobbying delle aziende continua ancora oggi, pretendendo un’applicazione della norma che non è del tutto conforme al testo attuale.

Ad esempio, l’insistenza del governo francese sulla sufficienza di un meccanismo di reclamo successivo (cioè: prima cancella poi discuti) è in contrasto con il nuovo art. 17 che prevede espressamente che i contenuti legittimi non debbano essere bloccati. La proposta francese incentrata su “parametri tecnici” mostra di voler spostare la regolamentazione dal piano giuridico al piano tecnico, così demandandone l’attuazione alle sole aziende (che controllano la tecnologia). Questo è un modo di svuotare la norma del suo reale contenuto (e spirito!).

Sia i titolari dei diritti che le grandi piattaforme del web hanno evidenziato di non essere particolarmente interessati a linee guida sostanziali che offrirebbero garanzie significative per i diritti degli utenti. La mancanza di linee guida però finirebbe per danneggiare le piattaforme più piccole (ed anche gli artisti indipendenti) che non hanno entrate sufficienti per incentivare i titolari dei diritti a collaborare, con ciò determinando una concentrazione del mercato che finirà per essere regolato dagli accordi tra le grandi aziende titolari dei contenuti e le grandi piattaforme del web.

Tanto per rendere l’idea, nel quinto meeting i rappresentanti delle emittenti televisive commerciali hanno sostenuto che le piattaforme dovrebbero rimuovere ogni volta che trovano il logo di una delle stazioni televisive. A parte casi nei quali le stazioni televisive si appropriano di video realizzati da utenti (apponendoci appunto il logo), in ogni caso un logo non è affatto la prova della violazione del copyright. Questo approccio dimostra soltanto che l’intenzione dei titolari del copyright è di perseguire una politica aggressiva di rimozioni disinteressandosi del tutto dei diritti dei cittadini. Nel sesto meeting, invece, i rappresentanti degli studi di Hollywood (MPA) e i produttori cinematografici (FIAFP), insieme alla principali etichette discografiche, hanno ribadito che gli utenti dovrebbero semplicemente fidarsi (in chiara violazione dell’art. 17, par. 9, che prevede che i titolari dei diritti debbano debitamente giustificare i motivi delle loro richieste di rimozione) dei titolari dei diritti (nel frattempo precisando che degli utenti invece non ci si può fidare), confermando la pretesa che i loro interessi prevalgano su quelli degli utenti.

Con la consultazione la Commissione europea ha lanciato un segnale chiaro a tutti gli Stati, e cioè l’obbligo di garantire che gli usi legittimi non siano pregiudicati, e che tale obbligo sia garantito a livello legislativo, e non solo su un piano meramente tecnico e a posteriori. Inoltre, la Commissione ha già respinto l’approccio selettivo degli Stati, che in molti casi hanno preferito non recepire parti della direttiva, come ad esempio l’art. 17.7 e parte del 17.9 (che prevede che la direttiva non pregiudichi gli usi legittimi).

Entro fine aprile (probabilmente il 19) la Commissione presenterà la sua proposta di attuazione dell’art. 17.

Articoli correlati

Leggi anche >> Le criticità della direttiva sul copyright. Analisi dell’articolo più controverso

Leggi anche >> Perché l’accordo sulla direttiva Copyright è pessimo

Leggi anche >> Filtri, link, contenuti degli utenti. Cosa cambia con la riforma del copyright

Leggi anche >> Se i filtri del copyright rimuovono anche Beethoven

Immagine in anteprima: "Free Stock: Copyright sign 3D render", MusesTouch - digiArt & design, licenza CC BY-NC-ND 2.0