Apple, gli abusi sui minori e l’incubo della sorveglianza globale

15 min letturaL'annuncio di Apple

Il 5 agosto Apple annuncia un cambiamento nelle sue politiche da attuare entro la fine dell’anno (inizialmente negli Usa per poi espandere anche ad altri paesi). L’idea è di combattere in maniera più efficace gli abusi sessuali sui minori, e intende farlo in tre modi:

1) sui sistemi operativi Apple la app di ricerca e Siri indirizzeranno le ricerche su argomenti relativi all’abuso sessuale su minori a risorse utili per segnalare eventuali abusi o ottenere aiuto;

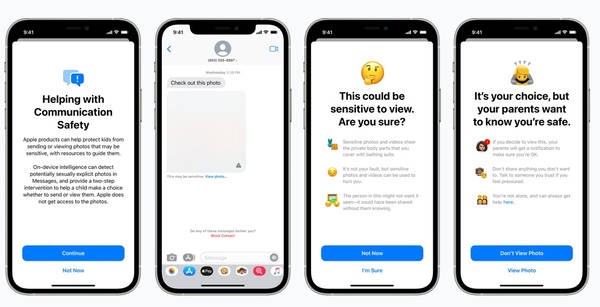

2) alla app Messaggi verrà aggiunto un “controllo parentale”, che oscurerà le immagini sessualmente esplicite per i minori di 18 anni, e sarà inviato ai genitori un avviso se un minore di 12 anni visualizza o invia immagini di questo tipo;

3) le immagini caricate su iCloud Photos saranno scansionate per verificare la presenza di materiale pedopornografico il quale sarà segnalato ai moderatori Apple che potranno trasmetterlo al NCMEC (National Center for Missing and Exploited Children, organizzazione senza scopo di lucro che lavora a fianco delle forze dell'ordine, che usa il software Microsoft photoDNA).

Le modifiche annunciate, secondo le comunicazioni di Apple, sono destinate a proteggere maggiormente i minori da abusi, violenze e sfruttamenti, e Apple sostiene di avere adeguatamente tenuto in considerazione le problematiche di privacy, ma molte voci critiche si sono sollevate contro tali cambiamenti. Al punto che Apple è dovuta tornare più volte a spiegare nei dettagli cosa realmente intende fare, pubblicando ulteriori documenti per fare chiarezza, senza però riuscire a placare del tutto le voci contrarie. Apple alla fine si è appellata alla fiducia dei suoi utenti, ma ci sono troppe problematiche e non possono essere risolte solo con la fiducia.

Vediamo nel dettaglio di che si tratta.

Messages (algoritmo di apprendimento)

Per quanto riguarda la nuova funzione in Messages, questa sarà attivata solo per gli “account famiglie” e se i genitori aderiscono. In tal caso i dispositivi dei minori di 18 anni, collegati all’account “famiglia”, scansioneranno le immagini in entrata e in uscita, alla ricerca di contenuti “sessualmente espliciti”. La scansione avviene sul dispositivo, quindi Apple non ha accesso alle immagini, ma è il dispositivo che stabilisce se l’immagine è “sessualmente esplicita o meno”, tramite un algoritmo (con apprendimento automatico). Sostanzialmente, secondo quanto precisa Apple, è un filtro per la nudità (anche se non è tecnicamente limitato alla nudità), per cui se vengono rilevati contenuti di questo tipo l'immagine viene oscurata e il dispositivo chiede all’utente se davvero desidera visualizzarla o inviarla.

Un’ulteriore funzione (anche questa da attivare espressamente dai genitori) per i minori di 12 anni farà sì che verrà inviata una notifica ai genitori se il minore visualizza o invia (non se semplicemente riceve) un’immagine sessualmente esplicita.

Queste funzionalità hanno ricevuto non poche critiche. Innanzitutto è un algoritmo di machine learning che si occuperà di stabilire se l’immagine è sessualmente esplicita, non si tratta, in questo caso, di paragonare una foto a foto simili, ma semplicemente è l’algoritmo che valuta le caratteristiche della foto, in base a parametri stabiliti in fase di programmazione. È ovvio che un errore di valutazione è sempre possibile. I filtri di questo tipo sono noti per la quantità di errori che commettono (come ad esempio quello di Tumblr) catalogando come contenuti sessuali foto di cuccioli, selfie di persone completamente vestite, oppure statue famose come la Sirenetta di Copenaghen.

Inoltre Kendra Albert della Cyberlaw Clinic di Harvard ha sostenuto che la “protezione minori” potrebbe impattare negativamente sui minori queer. In particolare evidenzia che non sempre i genitori sono le persone più adatte per discutere dei problemi relativi alla sfera sessuale, e sicuramente c’è il rischio che immagini di “transizione” sarebbero segnalate dall’algoritmo di apprendimento.

Apple può permettersi di sostenere che non ci sono problemi di privacy, perché non ha accesso alle immagini, ma in realtà viene demandato il controllo della vita dei minori ai genitori. Se un minore con iPhone senza questa funzionalità attiva invia una foto a un altro minore che ha la funzionalità abilitata, il mittente non riceverà alcuna comunicazione che Messages considera la sua immagine “esplicita” o che i genitori del destinatario saranno avvisati dell’invio. I genitori potrebbero decidere di segnalarli alle autorità, e si tratta di reati decisamente gravi.

Sono noti negli Usa casi di pubblici ministeri eccessivamente zelanti che hanno proceduto per abusi sessuali anche nei confronti di minori che hanno inviato volontariamente (quindi senza sfruttamento del minore) foto di se stessi ad altri soggetti coi quali erano in rapporti sentimentali o semplicemente flirtavano, rischiando fino a 10 anni di carcere e l’inserimento nel registro dei “reati sessuali” (sex offender). Ad esempio nel Minnesota una quattordicenne è stata processata per aver inviato una sua foto in mutande e reggiseno a un ragazzo che le piaceva (The Failure of Sexting Criminalization: A Plea for the Exercise of Prosecutorial Restraint). Dalla documentazione iniziale non è chiaro se fosse previsto fin dal primo momento il limite dei 12 anni per la “notifica” ai genitori, ma tale limite è ora presente nella documentazione pubblicata da Apple.

Finally, it seems obvious that when faced with a dialog that says "we're going to tell your parents", conversation will immediately shift to another platform, potentially Facetime where these mechanisms are all useless. 14/

— David Thiel (@elegant_wallaby) August 6, 2021

Il problema è che le leggi sulla pornografia non differenziano adeguatamente lo sfruttamento commerciale dalla sessualità adolescenziale, applicando regole simili ad entrambi i casi fino ad approcci di tolleranza zero (in Italia in realtà se non c’è sfruttamento del minore non si dovrebbe configurare il reato). Non è questo il luogo per discutere delle problematiche sessuali e educative dei bambini, ma molti sostengono (Not the New Pornographers Protecting Sexting Teens from Overzealous Prosecutors and Themselves) che l’approccio giusto sia di fiducia e consapevolezza verso i figli, non certo di controllo e sorveglianza. Ma del resto quando si tratta di aziende del web, l’unico approccio che conoscono e che applicano è quello della sorveglianza digitale, e purtroppo lo vendono anche ai propri utenti, provando a convincerli che è l’unico approccio possibile.

iCloud Photos (algoritmo di corrispondenza)

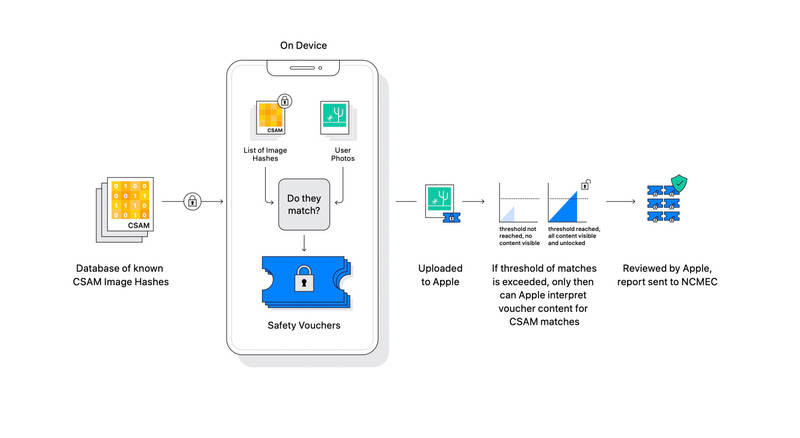

L’altra funzionalità che ha destato numerosi dubbi è il rilevamento della corrispondenza di immagini con il catalogo di immagini pedopornografiche detenuto dal NCMEC. Le cosiddette immagini CSAM (child sexual abuse materiale) sono contenuti di abuso e sfruttamento sessuale dei minori. La nuova tecnologia Apple scansionerà le immagini nel momento in cui queste vengono caricate (sincronizzate) su iCloud Photos anche se eventualmente il caricamento non avviene consapevolmente ma da parte di terze app. E la verifica avviene direttamente nel dispositivo, cioè le immagini sono controllate prima del caricamento sul cloud. L’algoritmo di corrispondenza crea un hash (un numero ricavato dall’immagine) delle immagini e lo confronta con gli hash del database CSAM del NCMEC. Il sistema non verifica le immagini ma solo i codici hash calcolati in base ad esse, e anche il database CSAM non ha in sé immagini ma solo codici hash (quindi può in teoria essere caricato interamente sul dispositivo). Niente di nuovo, è la stessa tecnologia utilizzata da Youtube per verificare le violazioni del copyright.

Se viene rilevata una corrispondenza viene generato un codice (voucher) che viene caricato nel cloud insieme all’immagine. Il sistema non si attiva per una sola immagine, ma solo se l’account cloud supera una soglia di contenuto CSAM noto. Apple inizialmente non ha rivelato la soglia, ma a seguito delle pressanti critiche ha detto che sarebbe di 30 foto (comunque modificabile in seguito). Grazie a tale soglia, secondo Apple, si garantisce che le possibilità di segnalare erroneamente un determinato account sono davvero minime (Apple precisa meno di un trilione di possibilità all’anno). Se si verifica un superamento della soglia un “moderatore” umano controlla effettivamente se esiste una corrispondenza tra l’immagine caricata ed una CSAM nota. Quindi Apple disabilita l’account utente e invia un rapporto al NCMEC. L’utente potrà ovviamente presentare ricorso per il ripristino del proprio account. Invece, se non viene usato iCloud per le foto, il sistema non fa alcuna verifica.

Lo fanno anche gli altri?

Anche le altre aziende operano più o meno allo stesso modo, anche se in realtà con meno trasparenza rispetto a quanto fa Apple (adesso). Il programma CyberTipline è attivo almeno dal 2011, e utilizza il software Microsoft PhotoDNA per la creazione del database CSAM che poi viene fornito alle aziende in formato hash (quindi le aziende non possono verificare quali sono le immagini in esso contenute). Aziende come Google, Facebook, Twitter e Reddit scansionano i file degli utenti, e in molti paesi (es. Regno Unito) sono legalmente obbligate a segnalare casi CSAM al NCMEC.

Leggi anche >> Google, i pedofili e la lettura delle mail

Apple prima di questo annuncio verificava la corrispondenza di immagini CSAM, per lo meno è noto per le mail. In genere per motivi di sicurezza un po’ tutte le aziende scansionano le mail (per lo spam, il phishing ecc...). Alcune aziende lo fanno anche per la personalizzazione degli annunci (Gmail non lo fa più per gli annunci dal 2017, Microsoft lo fa per motivi di sicurezza, Yahoo anche per la personalizzazione degli annunci, Protonmail non fa alcuna scansione delle mail). Per gli altri servizi è più difficile avere delle certezze, ma in linea di massima è bene pensare che ogni azienda che lavora con servizi digitali (che hanno necessità di addestramento tramite grandi quantità di dati) scansioni i contenuti, quanto meno a fini di sicurezza del servizio.

La differenza è che le altre aziende effettuano la verifica delle immagini una volta che queste sono entrate nel cloud, cioè sono state caricate sui server dell’azienda, invece Apple adesso annuncia che tale controllo sarà realizzato interamente sul dispositivo dell’utente, quindi prima che i file siano caricati sul cloud.

Quello che Apple fa di diverso è aggiungere una scansione lato “client”.

Scansione lato “client”

La caratteristica dei sistemi di comunicazione Apple, ma non solo, è la cifratura dei dati per evitare che possano essere letti da terze parti. Le aziende possono decidere di riservarsi le chiavi per decifrare i dati (in modo da poter comunque scansionare i file sempre impedendo a terzi di leggere le comunicazioni se intercettate), oppure decidere di non riservarsi questa possibilità rendendo così illeggibili i dati nella fase di transito, tranne ovviamente al mittente e al destinatario (cifratura end-to-end). Ad esempio Signal non ha le chiavi di decifratura, quindi non può in alcun modo accedere ai contenuti delle comunicazioni dei clienti, anche in caso di richiesta da parte delle autorità di polizia. Messages di Apple utilizza questo tipo di crittografia (come molti servizi di messaggistica), ma per l’iCloud Photos l’azienda si mantiene le chiavi di accesso (come molti servizi di cloud).

Con l’annuncio di agosto Apple si riserva la scansione delle foto prima che esse siano caricate sul cloud, e quindi prima che intervenga una eventuale cifratura end-to-end. Questa è la scansione lato “client”, proposta già dal 2019 (qui l’EFF spiega perché è pericolosa).

Ma, viene da chiedersi, se Apple ha le chiavi di accesso al cloud di foto, perché decide di implementare una scansione lato client, cioè sul dispositivo, invece di farne una lato server (come fanno gli altri), cioè dopo che le immagini sono state caricate sul cloud? Prima di tutto l’analisi sul dispositivo può impedire alle terze parti di accedere ai dati, cosa sempre possibile una volta che questi siano entrati nel cloud. Inoltre, Apple sta pensando di introdurre la crittografia end-to-end anche per gli altri servizi, come il cloud per le foto. Apple in realtà sta lavorando alla versione crittografata end-to-end del cloud già dal 2016 (New York Times e Financial Times), ma non ha mai fatto questo passo per i reclami dell’FBI che ha sostenuto che tale mossa avrebbe ostacolato le loro indagini. Quindi Apple, per evitare problemi con le autorità, inserisce preventivamente quella che alcuni (es. l’EFF) hanno definito “backdoor”, consentendo la scansione e il controllo delle immagini prima che esse siano cifrate con crittografia end-to-end (e quindi non più scansionabili).

Le critiche

Numerose sono le critiche che si sono addensate sulle iniziative di Apple, al punto che su alcune cose sembrerebbe aver fatto dei passi indietro rispetto alle intenzioni iniziali.

Lo sfruttamento minorile è un problema serio, ed è importante tutelare i minori, impedire che siano bersaglio di predatori sessuali. La scansione per immagini CSAM è parte di questa strategia da anni, e praticamente tutte le aziende del web fanno la loro parte. Apple in particolare ha seri motivi per intensificare i suoi sforzi, visto che nel 2020 lo stesso NCMEC ha sostenuto che Apple ha bassissimi tassi di segnalazione di immagini e video CSAM rispetto alle altre aziende del web (Google 3,5 milioni, Yahoo 2 milioni, Apple solo 3000 immagini e nessun video). Questo sembrerebbe riflettere una incapacità di verifica delle immagini attraverso i suoi servizi oppure sforzi insufficienti (dal processo Epic vs Apple sono emersi dei documenti riservati dai quali apparirebbe l'insufficienza di risorse riservate dall’azienda in questa materia). In tal modo l’azienda è posta sotto i riflettori della politica. Il senatore Blumenthal, sponsor della legislazione sulla tutela dei minori, ha definito i numeri di Apple “spaventosi e sorprendenti”, arrivando a sostenere che non si può più fare affidamento sull’autoverifica delle aziende del web. È evidente che a livello politico qualcosa si sta muovendo per irrigidire le norme in materia, e aumentano anche le pressioni della politica contro la crittografia accusata di facilitare le attività delinquenziali.

Il problema qui, però, è che Apple cerca quelle immagini sul nostro telefono, sul dispositivo che noi abbiamo acquistato e gestiamo personalmente e che siamo generalmente convinti (ricordate il motto “What happens on your iPhone stays on your iPhone”?) che sia un luogo sicuro dove tenere le nostre cose, i nostri dati. Secondo Ben Thompson Apple sta compromettendo il nostro telefono. Certo, dice Apple che puoi disabilitare la sincronizzazione dei dati col cloud (non usufruendo più di un servizio comunque pagato) così che la scansione per CSAM non avviene, ma è una decisione politica che potrà essere cambiata in qualsiasi momento, casomai a richiesta di un governo. Quello che ha “inventato” Apple è la possibilità tecnica di raggiungere il dispositivo e fare all’interno dello stesso quello che decide di fare, senza che l’utente abbia alcuna voce in capitolo. Ecco perché molti la definiscono una “backdoor”, un sistema di sorveglianza che funziona direttamente sul nostro telefono ed è potenzialmente in grado di violare qualsiasi crittografia end-to-end. Secondo l’EFF “un voltafaccia scioccante per gli utenti che hanno fatto affidamento sulla leadership dell'azienda in materia di privacy e sicurezza”.

No matter how well-intentioned, @Apple is rolling out mass surveillance to the entire world with this. Make no mistake: if they can scan for kiddie porn today, they can scan for anything tomorrow.

They turned a trillion dollars of devices into iNarcs—*without asking.* https://t.co/wIMWijIjJk

— Edward Snowden (@Snowden) August 6, 2021

Lettera aperta

Una lettera aperta del 6 agosto firmata da numerosi esperti delinea il problema in modo più dettagliato:

- Apple sta aprendo la porta a più ampi abusi (EFF);

- preoccupati che i cambiamenti di Apple creino di fatto nuovi rischi per i bambini e tutti gli utenti e segnino un allontanamento significativo dai protocolli di sicurezza e privacy di lunga data (Center for Democracy and Technology);

- il nuovo rilevatore di materiale pedopornografico (CSAM) di Apple promosso sotto l'egida della protezione e della privacy dei bambini è un passo deciso verso la sorveglianza (Carmela Troncoso, esperto di sicurezza e privacy e professore all'EPFL di Losanna);

- ci stavamo dirigendo gradualmente verso un futuro in cui sempre meno nostre informazioni erano soggette a sorveglianza, ci stavamo riprendendo la nostra privacy, oggi con Apple invertiamo la rotta (Matthew D. Green, esperto di sicurezza e privacy e professore alla Johns Hopkins University di Baltimora);

- se Apple avrà successo nell'introdurre questo, quanto tempo pensi che passerà prima che sia previsto da altri? Prima che il walled garden vieti le app che non lo fanno? Prima che sia sancito dalla legge? Quanto tempo pensi che passerà prima che il database venga ampliato per includere contenuti “terroristici”, contenuti “dannosi ma legali” e la censura specifica dello Stato? (Sarah Jamie Lewis, direttore esecutivo della Open Privacy Research Society);

- Apple vende iPhone senza FaceTime in Arabia Saudita, perché la normativa locale vieta le telefonate crittografate. Questo è solo un esempio dei tanti in cui Apple è piegata alla pressione locale. Cosa succederà quando le normative locali in Arabia Saudita imporranno che i messaggi vengano scansionati non per abusi sessuali su minori, ma per omosessualità o per reati contro la monarchia? (Nadim Kobeissi, ricercatore in questioni di sicurezza e privacy).

Bisogna anche dire che Apple ha ricevuto degli elogi da esperti di privacy e sicurezza come David Forsyth: “Questo sistema probabilmente aumenterà in modo significativo la probabilità che vengano trovate persone che possiedono o trafficano in CSAM. Gli utenti che non lo fanno dovrebbero subire una perdita di privacy minima o nulla”.

Ma il problema principale è che il sistema di corrispondenza non è specifico per i contenuti CSAM. È utilizzato per le violazioni del copyright, è utilizzato per i contenuti terroristici, e il database del NCMEC di fatto è la base per la realizzazione del GIFCT (Global Internet Forum to Counter Terrorism) per i contenuti terroristici. In entrambi i casi quello che è emerso è una preoccupante approssimazione nella supervisione, con il rischio di inserimento di contenuti che hanno ben poco di terrorista (o di abuso sessuale). Ma al di la degli eventuali errori (sopportati per l’importanza della tutela dei minori) il rischio maggiore sta negli abusi volontari da parte delle aziende o dei governi. Ci vorrà ben poco perché i governi autoritari si impongano sulle aziende pretendendo la scansione per altri fini, e nel momento in cui tale scansione viene effettuata nel dispositivo nessun contenuto potrà più sfuggire.

Leggi anche >> Contenuti terroristici online: limiti e rischi del regolamento europeo TERREG

Apple può sostenere di avere la forza di resistere alle imposizioni dei governi, ma è difficilmente credibile che possa resistere ad un ordine di un tribunale. E se anche fosse, non dobbiamo dimenticare che il database CSAM è finanziato dal governo, basterebbe che il governo inserisse gli hash di contenuti del tutto differenti per ampliare l’area di ciò che viene scansionato, e Apple non lo saprebbe nemmeno.

Whoever controls this list can search for whatever content they want on your phone, and you don’t really have any way to know what’s on that list because it’s invisible to you (and just a bunch of opaque numbers, even if you hack into your phone to get the list.)

— Matthew Green (@matthew_d_green) August 5, 2021

Il mio smartphone è davvero mio?

Stiamo gradualmente prendendo coscienza che ciò che è detenuto nel cloud non è realmente di nostra esclusiva proprietà, i dati sono scansionati per motivi di sicurezza o anche semplicemente per stabilire i nostri interessi al fine di venderci annunci personalizzati, l’account può essere chiuso in qualsiasi momento e con scarsissime possibilità di recuperare ciò che è nel cloud, i dati possono essere rubati dai criminali informatici, e così via. Con l’annuncio di Apple facciamo un passo avanti, e dobbiamo cominciare a pensare che anche il nostro smartphone, in fondo, non è poi così tanto nostro, dobbiamo cominciare ad abituarci all’idea che qualcuno potrà entrare nel nostro dispositivo e fare chissà cosa (e non stiamo parlando di regolari indagini delle autorità di polizia).

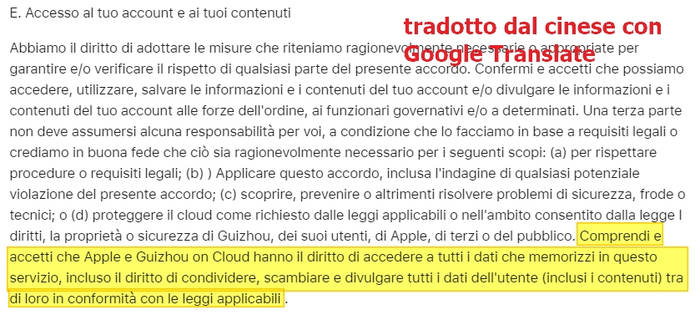

Apple ha contestato questa ricostruzione, in particolare l’uso del termine backdoor, sostiene che si opporrà ai tentativi dei governi di abusare del suo sistema, ma se in passato Apple ha combattuto l’FBI non fornendo i dati contenuti nel dispositivo usato da uno stragista (però fornendo nel contempo quelli sul cloud), occorre anche dire che ha acconsentito a richieste di vari governi. Ad esempio in Cina la legge sulla sicurezza nazionale del 2015 consente alla polizia di imporre alle aziende di aggirare la crittografia per l’accesso ai dati, inoltre la legge sulla sicurezza informatica del 2017 impone alle aziende di conservare tutti i dati su server locali. E Apple, pur di fare affari in Cina, ha acconsentito all’archiviazione locale dei dati in Cina così di fatto consentendo l’accesso ai dati da parte del governo (qui l’annuncio dell’accordo del 2018 con China Telecom), eliminando nel contempo le VPN dall’App Store (che consentivano di eludere la censura) e aggiornando i termini di servizio con l’indicazione che anche il governo cinese (tramite la Guizhou-Cloud Big Data Industry Co. GCBD di proprietà del governo) ha accesso ai dati (i dati sono richiesti direttamente dalla polizia senza necessità di un mandato di un tribunale).

Oppure in Arabia Saudita, dove Apple vende gli iPhone senza FaceTime perché la legislazione locale proibisce chiamate cifrate.

In conclusione i problemi conseguenti all’annuncio di Apple sono decisamente tanti:

- falsi positivi dai filtri CSAM;

- possibili collisioni (immagini con hash corrispondenti a contenuti CSAM);

- abuso da parte di governi (autoritari?);

- ampliamento dei contenuti soggetti a scansione.

Per quanto riguarda la collisione hash, una è stata riprodotta il 18 agosto utilizzando il codice di Apple che, secondo il ricercatore, sarebbe già presente su iOS anche se offuscato. Una collisione hash è la prova che un sistema di crittografia non è sicuro. Apple però asserisce che ulteriori protezioni impediranno lo sfruttamento della collisione.

Infine Alex Stamos, dell’Osservatorio Internet di Stanford, ha lapidariamente sostenuto che Apple si è inserita a gamba tesa nel dibattito internazionale sulla crittografia, rifiutando di partecipare alle discussioni con gli esperti di sicurezza e privacy, e cambiando radicalmente il punto di bilanciamento senza alcun dibattito pubblico.

Fiducia?

Dobbiamo avere fiducia in Apple? Molti sostengono che l’intenzione è buona, ma anche su questo occorrerebbe interrogarsi. In fondo stiamo sempre parlando di una azienda il cui fine ultimo è il profitto, non certo la tutela dei diritti dei cittadini, e quindi è possiamo aspettarci che le sue mosse, anche se presentate come qualcosa di buono per i cittadini, alla fine siano dirette a tutelare interessi primari dell’azienda. Di fatto Apple ha deciso che non vuole che i suoi prodotti siano associati in alcun modo a questo tipo di contenuti e quindi prende posizione contro di essi in maniera chiara e plateale. Del resto è noto che i grandi inserzionisti non vogliono i loro prodotti associati a contenuti discutibili, e per questo sono arrivate a boicottare Facebook e Youtube (cosa che ha provocato un immediato intervento delle due per la rimozione di tali contenuti).

Quasi certamente Apple introdurrà la crittografia end-to-end anche agli altri servizi, ma per placare i governi introduce una backdoor per l’accesso ai dati lasciando libera la possibilità di cooperare con le autorità. Come sostiene Jennifer King, ricercatrice a Stanford, c’è una tensione particolare che non si può ignorare: se le aziende reprimono troppo e buttano tutto fuori dai loro servizi, questi contenuti finiscono nel dark web dove non sempre le autorità hanno gli strumenti giusti per indagare. In un certo senso le autorità hanno bisogno che le aziende non reprimano così tanto.

In ogni caso l’impressione è che ci sia una crescente cooperazione pubblico-privato tra aziende e governi per la governance dell’ecosistema digitale, nelle spire della quale i diritti dei cittadini sono sempre più schiacciati.

Petizione dell'EFF: "di a Apple di non scansionare i nostri smartphone"

Immaginate un software così potente da poter mappare ogni pixel di una foto presente online, un software in grado di identificare gli elementi unici di un volto umano in modo da poter riconoscere una persona in mezzo ad una folla. Questo software può eseguire una scansione di una fotografia e rintracciare la persona ritratta ovunque, e può identificare tutte le fotografie di questa persona caricate online, così realizzandone una dettagliata profilazione: con chi è stato ripreso, dove è stato fotografato....

Adesso immaginate che quel software venga inserito nei vostri smartphone!