Vivere con gli algoritmi

26 min letturaLa no profit berlinese AlgorithmWatch e Bertelsmann Stiftung hanno pubblicato, lo scorso 28 ottobre, il rapporto 'Automating Society 2020', che indaga lo stato dei sistemi che automatizzano i processi decisionali in 16 paesi europei e a livello UE. I testi che seguono, l'introduzione al volume e le raccomandazioni di policy, sono un'anticipazione della sua edizione italiana.

Vita quotidiana nella società automatizzata

Che fare: raccomandazioni di policy

Vita quotidiana nella società automatizzata

I sistemi che automatizzano processi decisionali sono diventati mainstream: che fare?

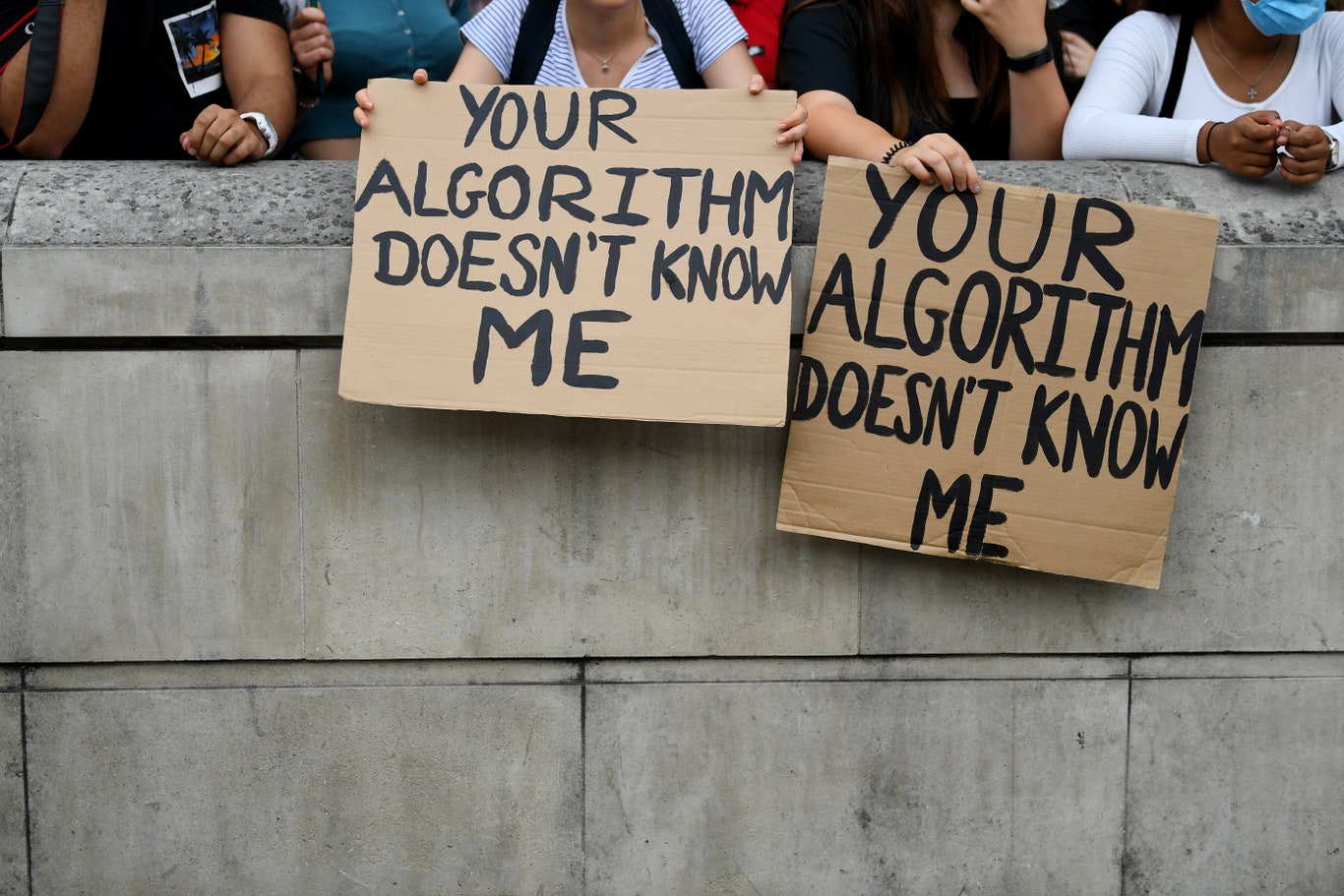

In un grigio pomeriggio di agosto, a Londra, gli studenti erano furiosi. Si erano riversati a centinaia in piazza del Parlamento, in protesta, mostrando nei loro cartelli e slogan di schierarsi allo stesso tempo dalla parte di un inusuale alleato, i loro professori, e contro un altrettanto inusuale bersaglio, un algoritmo.

A causa della pandemia di COVID-19, le scuole erano state chiuse già in marzo, in Gran Bretagna. Consci della diffusione del virus in rapida espansione in tutta Europa durante l’estate del 2020, gli studenti ben sapevano che i loro esami di fine anno sarebbero stati cancellati, e la loro valutazione sarebbe di conseguenza — a qualche modo — mutata. Ciò che non avrebbero potuto immaginare, tuttavia, è che migliaia di loro avrebbero finito per ricavarne voti inferiori a quelli attesi.

Gli studenti riuniti in protesta sapevano a chi dare la colpa, come reso evidente dai loro slogan e canti: il sistema di decision-making automatico (“automated decision-making”, d’ora in avanti “ADM”) adottato dall’Ofqal (Office of Qualifications and Examinations Regulation, l’autorità competente a verificare la correttezza di esami e voti). L’autorità intendeva produrre una migliore valutazione, basata su dati, sia per le valutazioni degli esami per ottenere il GCSE (General Certificate of Secondary Education) che per quelle degli esami “A level” (o General Certificate of Education Advanced Level), in modo che “la distribuzione dei voti segua un andamento simile a quello degli altri anni, così che gli studenti dell’anno in corso non debbano patire uno svantaggio sistemico a seguito delle circostanze presentatesi quest’anno”.

Il governo voleva evitare gli eccessi di ottimismo che, secondo le sue valutazioni, si sarebbero prodotti facendo ricorso al solo giudizio umano: in confronto alle serie storiche, i voti sarebbero risultati troppo alti. Ma il tentativo di essere “il più equi possibile, equi per gli studenti che non hanno potuto dare gli esami quest’estate” aveva invece fallito miseramente, e in quel grigio giorno di protesta d’agosto, gli studenti continuavano ad accorrere, cantare, mostrare cartelli che esprimevano un urgente bisogno di giustizia sociale. Alcuni di loro erano semplicemente disperati, altri si erano lasciati andare al pianto.

“Basta rubarci il futuro”, recitava un cartello, facendo il verso alle proteste per la giustizia climatica di Fridays for the Future. Altri, tuttavia, erano più specificamente tarati sulle falle del sistema di ADM per l’assegnazione dei voti: “Valuta il mio lavoro, non il mio codice postale”, siamo “studenti, non statistiche”, recavano scritto, denunciando così i risultati discriminatori del sistema.

Un canto levatosi in seguito ha finito, tuttavia, per definire il futuro stesso della protesta: intonava “Fuck the algorithm”, “fanculo l’algoritmo”. Terrorizzati che il governo stesse automatizzando con noncuranza — e in modo opaco — il loro futuro, indipendentemente dalle loro reali abilità e sforzi, gli studenti avevano preso a gridare il loro diritto di non vedersi indebitamente restringere le opportunità di vita da un insieme di righe di codice mal programmate. Reclamavano diritto di parola, e ciò che avevano da dire, in effetti, andava ascoltato.

Perché gli algoritmi non sono né “neutrali” né oggettivi, anche se tendiamo a pensarlo. Replicano, invece, gli assunti e le credenze di chi decide di adottarli e programmarli. È sempre un umano dunque, non “gli algoritmi” o i sistemi di ADM, a essere responsabile sia delle buone che della cattive decisioni algoritmiche — o almeno, così dovrebbe essere. La macchina sarà pure sinistra, ma il fantasma al suo interno è sempre umano. E gli esseri umani sono complicati, perfino più degli algoritmi.

Gli studenti in protesta non erano ingenui al punto di credere che tutte le loro preoccupazioni dipendessero esclusivamente dall’algoritmo, in ogni caso. Non stavano intonando cori contro “l’algoritmo” in un raptus di determinismo tecnologico: erano piuttosto motivati dall’urgenza di promuovere e proteggere la giustizia sociale. Da questo punto di vista, le loro proteste ricordano piuttosto quelle dei Luddisti. Proprio come il movimento per i diritti dei lavoratori che, nel XIX secolo, distruggeva telai meccanici e altre macchine da lavoro industriale, gli studenti sanno che i sistemi di ADM sono questione di potere, e non dovrebbero venire scambiati per tecnologie “oggettive”. Per questo cantavano “giustizia alla classe lavoratrice”, chiedendo le dimissioni del ministro della Salute e ritraendo il sistema di ADM incriminato come “classismo in purezza” e “classismo spudorato”.

Infine, gli studenti sono riusciti ad abolire il sistema che avrebbe messo le loro opportunità professionali e di vita in pericolo: in una incredibile giravolta, il governo britannico ha infatti dismesso il sistema di ADM rivelatosi fallace, e deciso di affidarsi al giudizio degli insegnanti.

Ma c’è altro in questa storia, oltre alla vittoria dei manifestanti. L’esempio sottolinea infatti come sistemi mal progettati, implementati e controllati che riproducono bias e discriminazioni umane non possano mettere a frutto i potenziali benefici dei sistemi di ADM, per esempio in termini di comparabilità ed equità.

Più chiaramente rispetto a molte battaglie del passato, questa protesta rivela che non stiamo più solamente “automatizzando la società”, ma che l’abbiamo già automatizzata.

Finalmente, qualcuno se ne è accorto.

Da “Automating Society” alla società automatizzata

Quando, nel gennaio 2019, abbiamo lanciato la prima edizione di questo rapporto, abbiamo deciso di chiamarlo “Automating Society”, cioè “automatizzando la società”, perché allora i sistemi di ADM reperibili in Europa erano principalmente nuovi, sperimentali e sconosciuti. Soprattutto, erano l’eccezione, piuttosto che la norma.

La situazione è cambiata rapidamente. Come mostrato chiaramente nei molteplici esempi raccolti per questo rapporto dal nostro straordinario network di ricercatori, l’adozione di sistemi di ADM è fortemente incrementata in poco più di un anno. I sistemi di ADM riguardano oggi ogni tipo di attività umana e, in particolare, la distribuzione di servizi essenziali a milioni di cittadini europei — nonché il loro effettivo accesso ai propri diritti.

L’opacità testarda che continua a circondare l’uso sempre crescente di sistemi di ADM ha reso anche più urgente moltiplicare, di conseguenza, i nostri sforzi. Per questo abbiamo aggiunto quattro paesi (Estonia, Grecia, Portogallo e Svizzera) ai dodici già analizzati nell’edizione precedente di questo rapporto, portando il totale a sedici paesi. Anche se ben lontana da rappresentare un’analisi esaustiva, ciò ci consente di fornire un ritratto più ampio dello scenario dell’ADM in Europa. Considerando l’impatto che questi sistemi possono avere sulla vita di ogni giorno, e quanto in profondità sfidino le nostre intuizioni — quando non le norme e regole — circa il rapporto tra democrazia e automazione, crediamo si tratti di uno sforzo indispensabile.

Ciò è vero a maggior ragione nel contesto della pandemia di COVID-19, un momento storico in cui abbiamo testimoniato l’adozione (perlopiù affrettata) di una pletora di sistemi di ADM mirati a contribuire alla salute pubblica attraverso dati e automazione. Abbiamo ritenuto il fenomeno talmente importante da farne l’oggetto di un “rapporto-anteprima” (preview report), pubblicato ad agosto 2020 sempre all’interno del progetto ‘Automating Society’.

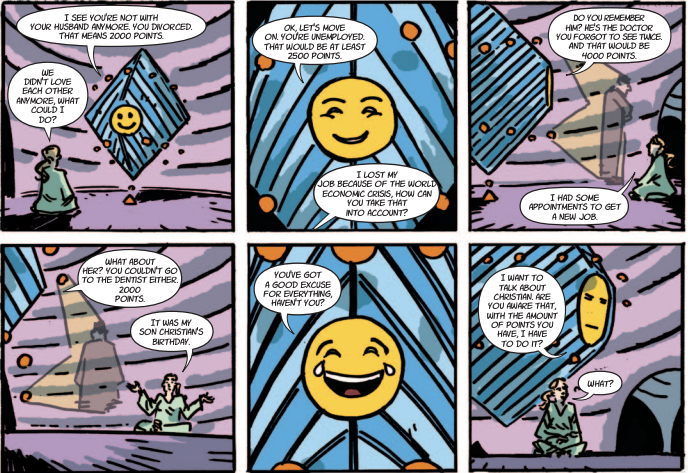

Perfino in Europa, quando si tratta di adottare sistemi di ADM, il limite è la fantasia. Si pensi anche solo ad alcuni dei casi raccontati in questo rapporto, che vanno ad aggiungersi ai tanti — dal welfare all’educazione, dal sistema sanitario a quello giudiziario — di cui abbiamo già dato conto nell’edizione precedente. Nelle pagine che seguono, e per la prima volta, forniremo aggiornamenti e sviluppi su questi casi in tre modi: tramite articoli giornalistici, attraverso una sezione di ricerca che elenca i diversi esempi raccolti, e infine con storie illustrate. Abbiamo ritenuto che questi sistemi di ADM siano — e saranno sempre più — talmente importanti nelle vite di ciascuno di noi da richiedere ogni possibile sforzo per comunicare come funzionino, e cosa ci facciano davvero, così da raggiungere ogni possibile tipologia di pubblico. Dopotutto, i sistemi di ADM ci riguardano tutti.

O almeno, dovrebbero. Abbiamo visto, per esempio, come un nuovo servizio automatizzato, e proattivo, distribuisca i bonus famiglia in Estonia. I genitori non devono nemmeno più fare domanda: lo Stato registra semplicemente tutte le informazioni di un neonato fin dalla nascita, raccogliendole in diversi database. Il risultato è che i genitori ricevono il bonus automaticamente, se ne hanno diritto.

In Finlandia, l’identificazione di fattori di rischio individuali correlati all’esclusione sociale dei giovani è automatizzata attraverso uno strumento sviluppato dal gigante giapponese Fujitsu. In Francia, i dati dei social network possono essere analizzati per addestrare algoritmi di machine learning che vengono impiegati per scovare frodi fiscali.

L’Italia sta sperimentando la “giustizia predittiva”, che fa ricorso all’automazione per aiutare i giudici a individuare, nella giurisprudenza passata, tendenze utili a valutare il caso in esame. E, in Danimarca, il governo ha provato a controllare ogni click di tastiera e mouse sui computer degli studenti durante gli esami di fine anno, causando — anche qui — una considerevole protesta studentesca che ha portato all’abbandono del sistema, per il momento.

È tempo di correggere i torti dell’ADM

In linea di principio, i sistemi di ADM hanno il potenziale di arrecare beneficio alle vite dei cittadini— processando per esempio enormi moli di dati, accompagnando le persone nei loro processi decisionali, e fornendo loro applicazioni personalizzate.

In pratica, tuttavia, abbiamo reperito solo un numero esiguo di casi che dimostri in modo convincente tale impatto positivo.

Per esempio, il sistema VioGén, adottato in Spagna sin dal 2007 per valutare il rischio di violenze domestiche, pur se lontano dalla perfezione mostra “indici di prestazione ragionevoli” e ha contribuito a proteggere diverse donne da abusi.

In Portogallo, un sistema centralizzato e automatico adottato per combattere frodi associate a prescrizioni mediche ha apparentemente ridotto le frodi dell’80% in un solo anno. Un sistema simile, usato in Slovenia contro le frodi fiscali, si è dimostrato utile agli ispettori, a quanto dichiara il fisco sloveno.

Se si amplia lo sguardo allo stato attuale dei sistemi di ADM in Europa, si scopre che gli esempi positivi, che arrecano chiari benefici, sono rari. Nel corso di tutto il rapporto, si descrive piuttosto come la stragrande maggioranza degli usi tenda ad aumentare i rischi per i cittadini, invece di essere loro d’aiuto. Ma, per giudicare davvero i reali impatti positivi e negativi di questi sitemi, abbiamo bisogno di maggiore trasparenza circa i loro scopi, e di più dati sul funzionamento dei sistemi di ADM sperimentati e adottati.

Il messaggio per i decisori politici non potrebbe essere più chiaro. Se vogliamo davvero sfruttare al massimo il potenziale dei sistemi di ADM, rispettando insieme i diritti umani e la democrazia, il tempo di intervenire, renderli trasparenti e correggerne i torti è ora.

Riconoscimento facciale, riconoscimento facciale ovunque

Strumenti diversi stanno venendo adottati in paesi diversi. Una tecnologia, tuttavia, è oramai comune a molti: il riconoscimento facciale. È ciò che può essere definito lo sviluppo più nuovo, rapido e preoccupante tra quelli evidenziati in questo rapporto. Il riconoscimento facciale, quasi assente dall’edizione 2019, sta venendo sperimentato e adottato a ritmi allarmanti in tutta Europa. Nell’anno e poco più trascorso dal nostro ultimo rapporto, il riconoscimento facciale ha fatto il suo ingresso in scuole, stadi, aeroporti, e perfino nei casinò. È stato così usato come strumento di polizia predittiva, per arrestare criminali, contro il razzismo e, in risposta alla pandemia di COVID-19, per garantire il rispetto delle norme di distanziamento sociale, sia via app che attraverso videosorveglianza “intelligente”.

L’adozione di nuovi sistemi di riconoscimento facciale prosegue nonostante il cumularsi delle prove scientifiche circa la loro scarsa accuratezza. E ogniqualvolta emerga un problema, i loro proponenti cercano di trovare un modo di aggirarlo. In Belgio, un sistema di riconoscimento facciale utilizzato dalla polizia è ancora “parzialmente attivo”, anche se un divieto temporaneo è stato emanato da un organo di controllo, l’Oversight Board for Police Information. E, in Slovenia, l’uso di tecnologie di riconoscimento facciale da parte della polizia è stato legalizzato cinque anni dopo che gli agenti avevano cominciato a utilizzarle.

Questa tendenza, se incontrastata, rischia di normalizzare l’idea di essere costantemente osservati senza avere alcuna trasparenza su chi osserva, finendo così per cristallizzare uno status quo di sorveglianza di massa pervasiva. Ecco perché, su questo, molti all’interno della comunità delle organizzazioni per i diritti civili avrebbero accolto con favore una risposta politica molto più aggressiva da parte delle istituzioni europee.

Perfino il proprio sorriso è ora parte di un sistema di ADM sperimentato in alcune banche polacche: più l’impiegato sorride, migliore è la ricompensa. E a essere sotto controllo non sono solo i volti. In Italia, un sistema di sorveglianza sonora è stato proposto come strumento anti-razzismo in tutti gli stadi di calcio.

Le scatole nere sono ancora scatole nere

Un risultato allarmante del nostro rapporto è che, mentre le cose sono rapidamente cambiate per quanto riguarda il tasso di adozione dei sistemi di ADM, lo stesso non si può dire della loro trasparenza. Nel 2015, il docente della Brooklyn Law School, Frank Pasquale, popolarizzò l’idea che una società connessa basata su sistemi algoritmici opachi fosse una “black box society”, ossia una società fatta di “scatole nere”, i cui contenuti e dinamiche di funzionamento sono inconoscibili. Cinque anni dopo, sfortunatamente, la metafora ancora regge — e si applica a tutti i paesi studiati in questo rapporto, senza eccezioni: non c’è abbastanza trasparenza sui sistemi di ADM, né nel settore pubblico, né in quello privato. La Polonia addirittura obbliga all’opacità, con la legge che ha introdotto il suo sistema automatizzato per riconoscere conti bancari usati per attività illegali (“STIR”). La legge stabilisce che rivelare gli algoritmi e gli indicatori di rischio adottati può comportare fino a cinque anni di carcere.

Se da un lato rigettiamo l’idea che tutti questi sistemi siano intrinsecamente malvagi — abbracciamo, al contrario, una prospettiva pragmatica, basata su fatti ed evidenze scientifiche (evidence-based) — è dall’altro indubbiamente male essere incapaci di valutarne il funzionamento e l’impatto sulla base di conoscenze accurate e fattuali. Anche solo perché l’opacità ostacola gravemente la capacità di raccogliere prove necessarie a formulare un giudizio informato sull’adozione stessa dei sistemi di ADM.

Quando vi si aggiungono le difficoltà che entrambi i nostri ricercatori e giornalisti hanno incontrato nell’accedere a qualunque dato realmente significativo su questi sistemi, si comprende quanto lo scenario dipinto sia problematico per chiunque desideri tenerli sotto controllo, e garantire che lo sviluppo dei sistemi di ADM sia compatibile con i diritti fondamentali, lo stato di diritto, e la democrazia.

Sfidare lo status quo algoritmico

Di fronte a tutto questo, come sta reagendo l’Unione Europea? Anche se i documenti strategici prodotti dalla Commissione UE, sotto la guida di Ursula Von der Leyen, fanno più generico riferimento all’“intelligenza artificiale” piuttosto che parlare direttamente di sistemi di ADM, ciò non significa che non contengano lodevoli intenzioni, a partire da quella di promuovere e realizzare una “AI degna di fiducia” (“trustworthy AI”) che veda al centro la persona umana (“people first”).

Eppure di fatto, come descritto nel capitolo sull’UE, l’approccio complessivo dell’Unione dà la priorità all’imperativo, commerciale e geopolitico, di guidare la “rivoluzione dell’AI” piuttosto che a quello di assicurarsi che i suoi prodotti siano coerenti con le tutele democratiche, una volta adottati come strumenti di policy.

Questa mancanza di coraggio politico, specialmente evidente nella decisione di accantonare l’idea di una moratoria sull’uso di tecnologie di riconoscimento facciale dal vivo in luoghi pubblici nel suo pacchetto di norme sull’AI, è sorprendente, in particolar modo in un frangente storico in cui diversi stati membri stanno testimoniando un numero crescente di cause — e sconfitte — giudiziarie per sistemi di ADM da loro adottati troppo frettolosamente, finendo per impattare in modo negativo sui diritti dei cittadini.

Storico è un caso proveniente dall’Olanda, dove degli attivisti per i diritti civili sono riusciti a portare in giudizio un sistema automatizzato opaco e invasivo, chiamato SyRI, che avrebbe dovuto individuare casi di frode al sistema del welfare, e vincere. Non solo, infatti, a febbraio 2020 la corte dell’Aia ha sospeso il sistema, ritenendolo in violazione della Convenzione europea dei diritti dell’uomo. Il caso ha anche istituito un precedente: secondo la sentenza, i governi hanno la “speciale responsabilità” di salvaguardare i diritti umani, qualora adottino tali sistemi di ADM. Fornire la tanto agognata trasparenza algoritmica ne è considerata parte cruciale.

Più in generale, dall’uscita del nostro primo rapporto, i media e gli attivisti della società civile si sono imposti quali forze trainanti verso la responsabilizzazione dei sistemi di ADM. In Svezia, per esempio, sono stati dei giornalisti a forzare la pubblicazione del codice del “sistema Trelleborg”, creato per prendere decisioni completamente automatizzate in relazione a domande di sussidi sociali. A Berlino, il progetto-pilota per un sistema di riconoscimento facciale nella stazione ferroviaria di Südkreuz non ha condotto a una vera e propria implementazione in tutto il paese solo grazie alla rumorosa opposizione degli attivisti — talmente rumorosa da influenzare le posizioni dei principali partiti e, da ultimo, l’agenda politica del governo.

Gli attivisti greci di Homo Digitalis hanno dimostrato che nessun reale viaggiatore ha mai partecipato alle sperimentazioni del sistema chiamato ‘iBorderCtrl’, un progetto finanziato dall’UE il cui obiettivo era utilizzare sistemi di ADM per i controlli ai confini, chiarendo così che le effettive capacità di molti tra questi sistemi sono di frequente grandemente esagerate. Nel frattempo, in Danimarca, un sistema di profilazione per l’identificazione precoce di rischi associati a famiglie e figli con “fragilità” (il cosiddetto “modello Gladsaxe”) veniva a sua volta fermato grazie al lavoro di accademici, giornalisti e dell’Autorità nazionale per la protezione dei dati personali (DPA).

Le Authority per la privacy hanno giocato un ruolo importante anche in altri paesi. In Francia, la DPA nazionale ha stabilito che due progetti per la sorveglianza sonora e il riconoscimento facciale negli istituti scolastici superiori fossero entrambi illegali. In Portogallo, ha rifiutato di approvare l’adozione di un sistema di videosorveglianza nelle città di Leiria e Portimão, perché ritenuto in violazione del principio di proporzionalità, e perché avrebbe costituito l’equivalente di un “monitoraggio sistematico su larga scala”, un “tracciamento delle persone e delle loro abitudini e comportamenti”, e di una “identificazione degli individui a partire da dati correlati a caratteristiche fisiche”. In Olanda, poi, l’autorità Garante dei dati personali ha chiesto più trasparenza circa gli algoritmi predittivi utilizzati dalle agenzie governative.

Da ultimo, alcuni paesi hanno fatto ricorso alla figura del difensore civico (ombudsperson), a caccia di consigli. In Danimarca, il suo supporto ha contribuito a sviluppare strategie e linee guida per un uso etico dei sistemi di ADM nel settore pubblico. In Finlandia, il vice-difensore civico parlamentare ha considerato illegale la valutazione automatica del livello di tassazione.

E ciononostante, data la continua diffusione di tali sistemi in tutta Europa, viene da chiedersi: questo livello di controllo è sufficiente? Quando per esempio il difensore civico polacco ha messo in discussione la legalità del sistema di riconoscimento dei sorrisi adottato in una banca (e menzionato sopra), la decisione non ha impedito una ulteriore e successiva sperimentazione nella città di Sopot, né raffreddato l’interesse di diverse aziende, ancora decise ad adottarlo.

Mancano auditing, conseguenze, capacità e spiegazioni

L’attivismo è principalmente una misura reattiva. Il più delle volte, gli attivisti possono reagire solo quando un sistema di ADM sta già venendo sperimentato, o è addirittura già stato adottato. Nel tempo necessario a organizzare una risposta, i diritti dei cittadini rischiano di essere già stati indebitamente intaccati. Ciò può accadere perfino in presenza delle forme di protezione garantite, in molti casi, dalla normativa europea e degli stati membri. È per questa ragione che garanzie proattive — e preventive, anteriori alla loro sperimentazione e adozione — sono così importanti per l’effettiva salvaguardia dei diritti dei cittadini.

Eppure, perfino nei paesi in cui una qualche forma di legislazione che includa tutele proattive è in vigore, l’effettiva applicazione della legge, molto semplicemente, non si verifica. In Spagna, per esempio, l’“azione amministrativa automatizzata” è codificata per legge, con annessi obblighi in termini di controllo qualità e supervisione, così come di auditing del sistema informatico e del suo codice sorgente. La Spagna si è anche dotata di una legge per l’accesso all’informazione (freedom of information). Eppure, nonostante queste leggi, solo raramente, scrive il nostro ricercatore, gli organi pubblici condividono informazioni dettagliate circa i sistemi di ADM che utilizzano. Allo stesso modo, in Francia esiste una legge che dal 2016 obbliga alla trasparenza algoritmica ma, di nuovo, senza esito.

Nemmeno portare un algoritmo di fronte a una corte giudiziaria, sulla base di specifiche disposizioni contenute in una legge per la trasparenza algoritmica, è abbastanza per proteggere davvero i diritti degli utenti. Come dimostrato dal caso francese dell’algoritmo di Parcoursup per la selezione di studenti universitari, le eccezioni per mettere al riparo una amministrazione pubblica da ogni forma di accountability si possono ricavare a piacimento.

Ciò è particolarmente problematico quando vi si aggiunga un contesto caratterizzato dalla endemica mancanza, nella pubblica amministrazione, di capacità e competenze riguardanti i sistemi di ADM da tempo lamentata da molti dei nostri ricercatori. E come potrebbero i pubblici ufficiali spiegare o fornire alcuna reale trasparenza su sistemi che non comprendono?

Di recente, alcuni paesi hanno tentato di affrontare il problema. L’Estonia, per esempio, ha predisposto un centro per competenze (competence center) rilevanti per i sistemi di ADM, per meglio comprendere come potrebbero venire usati per sviluppare nuovi servizi pubblici e, più nello specifico, informare le operazioni del Ministero per gli Affari economici e le comunicazioni, e della Cancelleria di Stato per lo sviluppo dell’e-government. Anche la Svizzera ha proposto la creazione di una “rete di competenze” (competence network) all’interno della più ampia cornice della strategia nazionale, chiamata “Svizzera Digitale”.

Ma ciononostante, la ben nota mancanza di alfabetismo digitale resta un problema per buona parte della popolazione in diversi paesi europei. Per di più, è difficile chiedere il rispetto di diritti che non si sa di avere. Le proteste in Gran Bretagna e altrove, insieme a diversi scandali pubblici a base di sistemi di ADM, hanno di certo contribuito a innalzare il livello di consapevolezza sia dei rischi che delle opportunità derivanti dall’automatizzazione della società. Ma per quanto in crescita, questa consapevolezza muove ancora solo i primi passi in molti paesi.

I risultati della nostra ricerca sono chiari: per quanto i sistemi di ADM già influenzino ogni sorta di attività e giudizio, è ancora loro concesso di essere principalmente adottati senza alcun reale dibattito democratico. Inoltre è la norma, piuttosto che l’eccezione, osservare meccanismi di tutela e controllo in palese ritardo rispetto all’adozione dei sistemi che dovrebbero controllare — se e quando esistono.

Nemmeno lo scopo di questi sistemi viene comunemente giustificato o spiegato alle popolazioni che ne sono affette, né tantomeno vengono illustrati i benefici che ne dovrebbero loro derivare. Si pensi al servizio proattivo “AuroraAI” in Finlandia: dovrebbe identificare automaticamente gli “eventi di una vita” (life events), come riportano i nostri ricercatori finlandesi. Nella mente dei proponenti dovrebbe funzionare come una sorta di “tata”, capace di aiutare i cittadini a soddisfare i loro bisogni di servizi pubblici in concomitanza con precisi eventi della propria vita — per esempio, cambiare residenza, cambiare stato nelle relazioni familiari, etc. Una forma di spiacevole “spinta gentile” (nudging) potrebbe essere all’opera in questo caso, scrivono i ricercatori, stando a dire che, invece di avvantaggiare le persone, il sistema potrebbe finire per fare l’esatto opposto, suggerendo alcune decisioni o limitando le opzioni a disposizione di un individuo già con il proprio design o la sua stessa architettura.

È di conseguenza anche più importante sapere cosa, più di preciso, stia venendo “ottimizzato” in termini di servizi pubblici: “è massimizzato l’uso del servizio, sono minimizzati i costi, o viene migliorato il benessere del cittadino?”, chiedono i ricercatori. “Su quale insieme di criteri si basano queste decisioni, e chi li stabilisce?” Il semplice fatto che non si abbiano risposte a queste fondamentali domande la dice lunga sul reale grado di partecipazione e trasparenza concesso, perfino per un sistema di ADM tanto invasivo.

La trappola tecno-soluzionista

C’è una più ampia giustificazione ideologica per tutto questo. È chiamata “soluzionismo tecnologico”, e affligge ancora in profondità il modo in cui i sistemi di ADM vengono studiati e sviluppati. Anche se il termine è da tempo criticato come sinonimo di una ideologia fallace, che concepisce ogni problema sociale come un “bug” in attesa di essere aggiustato (“fix”) tramite la tecnologia, questa retorica è ancora ampiamente sfruttata — sia nei media che in ambienti di policy — per giustificare l’adozione acritica di tecnologie di automazione nella vita pubblica.

Quando dipinti come “soluzioni”, i sistemi di ADM fanno immediatamente ingresso nei territori meglio descritti dalla Terza Legge di Arthur C. Clarke: quelli in cui sono indistinguibili dalla magia. Ed è difficile, se non impossibile, imporre delle regole alla magia, così come renderla trasparente o spiegarla. Ciò che si vede è la mano frugare nel cappello e, di conseguenza, l’apparire di un coniglio, ma il procedimento è e deve rimanere una “black box”, inconoscibile.

Diversi tra i ricercatori coinvolti nel progetto ‘Automating Society’ hanno individuato in questa ideologia l’errore fondamentale che informa la logica con cui vengono concepiti i sistemi di ADM descritti nel rapporto. Ciò implica anche, come mostrato nel capitolo sulla Germania, che gran parte delle critiche a tali sistemi vengano descritte come puro e semplice rigetto dell’“innovazione” tutta, mentre i sostenitori dei diritti digitali non sarebbero che “neo-luddisti”. Ciò tuttavia non solo dimentica la realtà storica del movimento luddista, che si occupava di politiche del lavoro e non di mere tecnologie, ma minaccia inoltre, in un senso perfino più elementare, di compromettere l’efficacia dei meccanismi di controllo ipotizzati.

In un frangente storico in cui l’industria dell’AI sta testimoniando l’emergenza di un settore lobbistico particolarmente “vitale”, a partire dalla Gran Bretagna, ciò potrebbe tradursi nell’adozione di comodo di mere linee guida per l’etica (“ethics-washing”, il tentativo di prevenire norme e regole con un surplus di autoregolamentazione volontaria) e in altre risposte di policy inefficaci e strutturalmente inadeguate ad affrontare le implicazioni sui diritti umani dei sistemi di ADM. Ciò significherebbe, in ultima analisi, sposare l’assunto secondo cui siamo noi esseri umani a doverci adattare ai sistemi di ADM, molto più che questi ultimi a dover essere modellati secondo i principi delle società democratiche.

Per contrastare questa narrativa, non dovremmo trattenerci dal porre domande fondamentali: per esempio, se i sistemi di ADM siano compatibili con la democrazia e possano essere impiegati per arrecare beneficio alla società tutta, e non solo ad alcuni. Potrebbe darsi, infatti, che certe attività umane — per dirne una tipologia, quelle collegate al welfare — non debbano essere assoggettate ad automazione, o che certe tecnologie — a partire dal riconoscimento facciale dal vivo in luoghi pubblici — non debbano essere incentivate nella ricerca, senza fine, della “leadership sull’AI”, ma al contrario messe al bando.

Anche più importante è rigettare qualunque cornice ideologica ci impedisca di porre simili domande. Al contrario: ciò di cui abbiamo bisogno ora è che cambino alcune scelte politiche concrete — così che sia consentito un più approfondito scrutinio di questi sistemi. Nella sezione successiva elencheremo le principali richieste emerse dai nostri risultati di ricerca. Speriamo che siano ampiamente dibattute, e infine implementate.

Solo attraverso un dibattito informato, inclusivo, basato su evidenze scientifiche — un dibattito davvero democratico, dunque — riusciremo a trovare il giusto bilanciamento tra i benefici che i sistemi di ADM posso arrecare — e arrecano — in termini di rapidità, efficienza, equità, migliore prevenzione e accesso ai servizi pubblici, e le sfide che pongono ai diritti di tutti.

Che fare: raccomandazioni di policy

Alla luce dei risultati dettagliati nell’edizione 2020 del rapporto ‘Automating Society’, consigliamo ai policy-maker nel Parlamento Europeo e nei Parlamenti degli stati membri, alla Commissione UE, ai governi nazionali, ai ricercatori, alle organizzazioni della società civile (organizzazioni di advocacy, fondazioni, sindacati, etc.), e al settore privato (aziende e associazioni commerciali) di adottare il seguente insieme di interventi di policy. Queste raccomandazioni hanno l’obiettivo di meglio assicurare che i sistemi di ADM attualmente adottati e in via di adozione in tutta Europa siano effettivamente coerenti con il rispetto dei diritti umani e delle regole democratiche.

1. Più trasparenza per i sistemi di ADM

Senza la possibilità di sapere precisamente come, perché e a quali fini i sistemi di ADM vengano adottati, tutti gli altri sforzi per riconciliarli con i diritti fondamentali sono destinati a fallire.

— Creare registri pubblici per i sistemi di ADM utilizzati nel settore pubblico

Chiediamo, di conseguenza, che venga adottata una legge di rango europeo che obblighi gli stati membri alla creazione di registri pubblici per i sistemi di ADM usati nel settore pubblico.

Dovrebbero inoltre essere accompagnati da obblighi di legge, per i responsabili dei sistemi di ADM, riguardanti la trasparenza e la documentazione dello scopo del sistema, una spiegazione del modello adottato (logica inclusa), e informazioni su chi l’ha sviluppato. Tutte queste informazioni devono essere rese disponibili in formati facilmente leggibili e accessibili, inclusi dati digitali strutturati e basati su protocolli standardizzati.

Le autorità pubbliche dovrebbero avere la responsabilità specifica di rendere trasparenti le componenti operative dei sistemi di ADM adottati nelle amministrazioni pubbliche — come sottolineato da un recente reclamo amministrativo in Spagna, che argomenta che “ogni sistema di ADM usato da un’amministrazione pubblica dovrebbe essere reso pubblico di default”. Se confermato, il giudizio potrebbe diventare un precedente, in Europa.

— Introdurre schemi legalmente vincolanti per l’accesso ai dati, a supporto della ricerca nell’interesse pubblico

Aumentare il grado di trasparenza fornito non richiede solamente la divulgazione di informazioni circa scopo, logica e creatore di un sistema, né la capacità di analizzarne nel dettaglio, e mettere alla prova, gli input e gli output. Richiede infatti anche che i dati attraverso cui i suoi algoritmi vengono addestrati, e i risultati da loro prodotti, siano resi accessibili a ricercatori indipendenti, giornalisti e organizzazioni della società civile, nell’interesse pubblico.

Ecco perché suggeriamo l’introduzione di schemi solidi e legalmente vincolanti per l’accesso ai dati, esplicitamente mirati a supportare e promuovere la ricerca a fini di pubblico interesse, e nel pieno rispetto della normativa sulla protezione dei dati e la privacy.

Facendo tesoro delle migliori esperienze (best practices) a livello nazionale ed europeo, questi schemi a più livelli dovrebbero includere sistemi di sanzioni, di tutele (checks and balances), e revisioni periodiche. Come illustrato dalle partnership per la condivisione dei dati con soggetti privati, ci sono legittime preoccupazioni in termini di privacy degli utenti e di possibile deanonimizzazione di certe tipologie di dati.

I policy-maker dovrebbero fare propri gli insegnamenti derivanti dai modelli di condivisione dei dati sanitari, così da rendere più semplice dare accesso privilegiato a certe tipologie di dati, più granulari, e al contempo garantire che i dati personali siano protetti in modo adeguato (per esempio, attraverso ambienti operativi sicuri).

E se ottenere uno schema di responsabilizzazione efficace richiede di certo un accesso trasparente ai dati in possesso delle piattaforme, quest’ultimo è un requisito indispensabile anche all’efficacia di svariati approcci di auditing.

2. Creare uno schema per una reale responsabilizzazione in tema di sistemi di ADM

Come dimostrato da quanto documentato per Spagna e Francia, perfino quando la trasparenza di un sistema di ADM diventa norma di legge e/o delle informazioni al suo riguardo vengono effettivamente divulgate, ciò non necessariamente comporta reale accountability. Affinché disposizioni di legge e altri requisiti vengano effettivamente rispettati, servono passi ulteriori.

— Sviluppare e adottare approcci per un effettivo audit dei sistemi algoritmici

Per garantire che la trasparenza sia reale, c’è bisogno di completare il primo passo — la creazione di un registro pubblico — con processi che consentano un effettivo audit dei sistemi algoritmici.

Il termine “auditing”, in italiano associato a “revisione”, “verifica” e “controllo”, è di largo utilizzo, ma non c’è consenso intorno a una sua comune definizione. Per noi, in questo contesto va compreso in accordo con la definizione dell’ISO: un “processo sistematico, indipendente e documentato per ottenere evidenze oggettive e valutarle oggettivamente, così da determinare in che misura i criteri dell’audit sono stati rispettati”.

Non disponiamo ancora di risposte soddisfacenti per tutte le complesse domande sollevate dall’auditing dei sistemi algoritmici. Tuttavia, i nostri risultati mostrano chiaramente il bisogno di trovarle attraverso un ampio processo di coinvolgimento dei portatori di interesse, e tramite un lavoro di ricerca approfondito e specifico.

Dovrebbero essere sviluppati sia criteri che processi appropriati a costruire un sistema di auditing efficace, attraverso un approccio multi-stakeholder che tenga attivamente in considerazione l’effetto sproporzionato che i sistemi di ADM hanno sui gruppi sociali più vulnerabili — e ne solleciti, di conseguenza, la partecipazione.

Chiediamo ai policy-maker, di conseguenza, di dare inizio a questi processi con i portatori di interesse, così da chiarire le domande illustrate, e rendere disponibili le fonti di finanziamento necessarie a consentire la partecipazione degli stakeholder finora non rappresentati in modo adeguato.

Chiediamo inoltre la predisposizione di risorse adeguate a supportare e finanziare progetti di ricerca sullo sviluppo di modelli efficaci di auditing per i sistemi algoritmici.

— Promuovere le organizzazioni della società civile a watchdog dei sistemi di ADM

I risultati della nostra ricerca indicano chiaramente che il lavoro delle organizzazioni della società civile è cruciale per sfidare efficacemente l’opacità dei sistemi di ADM. Attraverso ricerca e attivismo, e spesso in cooperazione con istituzioni accademiche e giornalisti, tali entità sono negli ultimi anni ripetutamente intervenute nei dibattiti politici su automazione e democrazia, riuscendo in molti casi ad assicurare che l’interesse pubblico e i diritti fondamentali fossero debitamente tenuti in considerazione, sia prima che dopo l’adozione di sistemi di ADM, in diversi paesi europei.

La società civile dovrebbe essere dunque supportata, in qualità di “cane da guardia” (watchdog) della società automatizzata. Come tale, la società civile è parte integrante di qualunque schema di accountability dei sistemi di ADM voglia dirsi efficace.

— Mettere al bando il riconoscimento facciale capace di sorveglianza di massa

Non tutti i sistemi di ADM sono ugualmente pericolosi, e un approccio regolatorio basato sul rischio, come quello tedesco o della UE, lo riconosce correttamente. Ma se l’intento è fornire reale accountability per sistemi identificati come rischiosi, vanno insieme creati meccanismi efficaci di controllo e implementazione. Ciò è anche più importante per sistemi considerati “ad alto rischio” di violare i diritti degli utenti.

Un esempio cruciale, emerso dai risultati della nostra ricerca, è il riconoscimento facciale. I sistemi di ADM che sono basati su tecnologie biometriche, incluso il riconoscimento facciale, si sono rivelati una minaccia particolarmente seria per l’interesse pubblico e i diritti umani, visto che aprono la strada a forme di sorveglianza di massa indiscriminata — in particolare modo quando, come ora, vengono adottati perlopiù in modo non trasparente.

Chiediamo che gli usi pubblici di tecnologie di riconoscimento facciale capaci di sorveglianza di massa siano strettamente, e urgentemente, proibiti fino a data da destinarsi, a livello europeo.

Tali tecnologie potrebbero perfino essere considerate già illegali nell’UE, almeno per certi usi, se impiegate senza “consenso specifico” dei soggetti inquadrati. Questa lettura legale è stata suggerita dalle autorità in Belgio, quando hanno emesso una prima, storica multa per l’indebita adozione di un sistema di riconoscimento facciale nel paese.

3. Accrescere l’alfabetismo algoritmico e rafforzare il dibattito pubblico sui sistemi di ADM

Maggiore trasparenza sui sistemi di ADM può essere realmente utile solo se chi la deve realmente affrontare — legislatori, governi, organi di settore — è in grado di confrontarsi con l’impatto di tali sistemi in modo responsabile e prudente. Inoltre, coloro i quali subiscono quell’impatto devono poter essere in grado di comprendere quando, perché e come quei sistemi siano stati adottati. È per questa ragione che dobbiamo accrescere l’alfabetismo algoritmico, a tutti i livelli, sia tra i più importanti portatori di interesse che nel pubblico generalista, e rafforzare i dibattiti pubblici sui sistemi di ADM e il loro impatto sulla società, rendendoli maggiormente plurali.

— Creare centri di competenze sull’ADM indipendenti

Insieme alle nostre richieste sull’auditing algoritmico e il supporto alla ricerca, chiediamo vengano costruiti dei centri di competenze sull’ADM indipendenti, a livello nazionale, per monitorare, valutare e condurre ricerca sui sistemi di ADM. Tali centri dovrebbero insieme fornire consigli al governo e al settore privato, in coordinamento con legislatori, società civile e accademia, circa le conseguenze per la società e i diritti umani derivanti dall’uso di tali sistemi. Il ruolo complessivo di questi centri è la creazione di un sistema funzionante di accountability, oltre alla formazione di competenze specifiche.

I centri nazionali di competenze dovrebbero coinvolgere le organizzazioni della società civile, i gruppi dei portatori di interesse, e gli organismi di enforcement attualmente esistenti, tra cui le Autorità per la protezione dei dati personali (DPAs) e gli organismi nazionali deputati al rispetto dei diritti umani, così da arrecare il massimo beneficio all’intero ecosistema e promuovere fiducia, trasparenza, e cooperazione tra tutte le parti in causa.

In qualità di organismi indipendenti, questi centri di expertise avrebbero un ruolo centrale nel coordinare gli sviluppi di policy e le strategie nazionali correlate all’ADM, così come nel contribuire all’ampliamento delle competenze e abilità esistenti tra legislatori, governi e organi di settore, in risposta all’aumentato utilizzo dei sistemi di ADM.

Tali centri non dovrebbero disporre di poteri regolatori, ma piuttosto fornire le competenze necessarie a proteggere i diritti umani degli individui, e impedire danni sociali e alla collettività. Dovrebbero, per esempio, aiutare le piccole e medie imprese a soddisfare i loro obblighi in termini di “due diligence” sui diritti umani, incluse le valutazioni sui diritti umani e di impatto algoritmico, e l’iscrizione al registro pubblico dei sistemi di ADM sopra discusso.

— Promuovere un dibattito democratico plurale e inclusivo sui sistemi di ADM

Oltre a rafforzare abilità e competenze di chi adotta i sistemi di ADM, è altrettanto vitale promuovere l’alfabetismo algoritmico nel pubblico generalista attraverso un più ampio dibattito e programmi pluralisti.

I nostri risultati suggeriscono non solo che i sistemi di ADM restino opachi al pubblico quando sono già utilizzati, ma che perfino la decisione di adottare o meno un sistema di ADM venga di norma presa a insaputa e senza alcuna partecipazione della cittadinanza.

C’è dunque un urgente bisogno di includere il pubblico (e l’interesse pubblico) nei processi decisionali sui sistemi di ADM fin dal principio.

Più in generale, c’è bisogno di un dibattito pubblico maggiormente plurale sugli impatti dell’ADM. Dobbiamo andare oltre il semplice relazionarsi a gruppi di esperti, e garantire invece che la questione risulti più accessibile a un pubblico più ampio. Ciò significa parlare una lingua diversa da quella meramente tecno-giudiziaria, ingaggiare il pubblico, e stimolarne la curiosità.

Per riuscirci, dovrebbero essere predisposti programmi dettagliati per fare e promuovere alfabetismo digitale. Se l’obiettivo è un dibattito pubblico informato per la creazione di vera autonomia digitale per i cittadini europei, dobbiamo cominciare a costruirlo, e promuoverlo davvero, con una attenzione specifica alle conseguenze sociali, etiche e politiche dell’adozione dii sistemi di ADM.

(Illustrazioni di Lorenzo Palloni, Samuel Daveti e Alessio Ravazzani, via Automating Society 2020)