Chat Control 2: l’Europa vuole introdurre la sorveglianza globale affidata ai privati

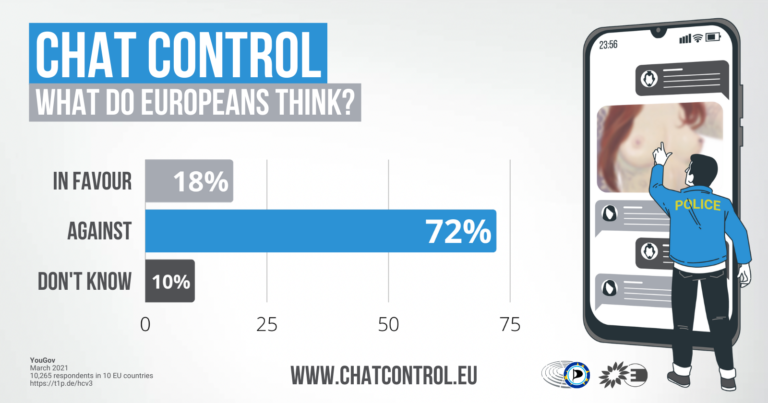

11 min letturaL’11 maggio 2022 la Commissione Europea ha presentato un disegno di legge (Regulation laying down rules to prevent and combat child sexual abuse) che prevede l’obbligo per i fornitori di servizi di hosting e di comunicazione (chat, posta elettronica, messaggistica) di installare tecnologie di rilevamento automatico del materiale pedopornografico (CSAM, cioè immagini di abusi sessuali sui minori). Il motivo di tale intervento starebbe in un rapporto del 2017 del Parlamento europeo, dal quale si evince che i paesi europei non hanno adottato misure adeguate per affrontare la problematica degli abusi e dello sfruttamento sessuale dei minori. È da notare che gli studi in materia si soffermano generalmente sulla crescita del fenomeno online (che in realtà potrebbe essere dovuta anche al fatto che ormai tutto si sta progressivamente spostando online) e sulle conseguenze sui bambini (dovute anche al permanere delle immagini online).

Direttiva CSEA, art. 2: «pornografia minorile» o «materiale pedopornografico»:

i) il materiale che ritrae visivamente un minore in atteggiamenti sessuali espliciti, reali o simulati;

ii) la rappresentazione degli organi sessuali di un minore per scopi prevalentemente sessuali;

iii) il materiale che ritrae visivamente una persona che sembra un minore in atteggiamenti sessuali espliciti, reali o simulati, oppure la rappresentazione per scopi prevalentemente sessuali degli organi sessuali di una persona che sembra un minore; oppure

iv) immagini realistiche di un minore in atteggiamenti sessuali espliciti o immagini realistiche degli organi sessuali di un minore, per scopi prevalentemente sessuali;

Secondo la Commissione europea, infatti, l’individuazione del materiale CSAM attualmente avviene solo in maniera volontaria da parte delle piattaforme del web (il 95% delle segnalazioni viene da Facebook). E in questa ottica la progressiva introduzione di forme di crittografia sempre più sicure per le comunicazioni interpersonali minerebbe la capacità delle forze di polizia di perseguire i crimini sui minori. Sono note, infatti, le pressioni politiche contro la crittografia accusata di favorire le attività delinquenziali (report 2021 di Europol).

La proposta si inserisce sulla scia di un provvedimento del 2021 (Regolamento 2021/1232, anche definito Chat Control) che introduce una deroga temporanea (scade ad agosto 2024) ad alcune disposizioni della direttiva 2002/58/CE (Direttiva ePrivacy), con riferimento all’uso di tecnologie di controllo sui contenuti da parte dei fornitori di servizi di comunicazione interpersonali. Il provvedimento ammette l’uso di tali tecnologie purché le scansioni delle comunicazioni siano solo per finalità di verifica della presenza di contenuti CSAM (art. 5 Convenzione 108+). Il provvedimento fu criticato anche dall'EDPS europeo per l’assenza di prove della sua necessità e proporzionalità, ma la Commissione europea si giustificò sostenendo che le aziende non potevano più scansionare le conversazioni degli utenti, così determinando una sorta di emergenza. Questo perché il 21 dicembre 2020 era intervenuto l'European Electronic Communications Code (EECC) a seguito della quale alcuni fornitori di servizi di comunicazione (voip, messaggistica, email service) rientravano nell’applicazione della Direttiva ePrivacy (prima erano soggetti alla Direttiva eCommerce). Interessante però è che gli stessi legislatori ammisero che le norme sono “giuridicamente viziate” e che potrebbero “sgretolarsi dinanzi a un tribunale”.

Quindi la proposta di legge finirebbe per essere la cristallizzazione della deroga temporanea del 2021, da cui la definizione di Chat Control 2.0.

Per la normativa in materia, in particolare per il provvedimento del 2021, si era anche mosso anche l’attore Ashton Kutcher, oggi investitore tecnologico che è entrato nel mercato della sorveglianza privata con Thorn. Nel 2020 la sua azienda ha lanciato Safer, la “prima piattaforma completa di rilevamento di CSAM di terze parti”. Thorn si presenta come un’organizzazione di beneficenza che combatte gli abusi sui minori, ma nel contempo sponsorizza il proprio software di rilevamento di immagini e contenuti CSAM verso la Commissione europea, con la quale ha ottenuto vari incontri.

Sul suo sito web vanta 20 incontri con i legislatori europei solo nel 2021. Ed è anche una delle principali voci contro l’adozione di tecnologie di crittografia forte (end-to-end). EDRi riporta che nel marzo del 2021 ha incontrato anche il commissario Johansson, responsabile della nuova proposta legislativa dell'UE, anche se non è dato sapere cosa si sono detti, in quanto la divulgazione “avrebbe un impatto negativo sul processo decisionale interno” della Commissione.

Obblighi per le aziende

I servizi soggetti all’obbligo della proposta di legge sono: servizi di telefonia, posta elettronica, messaggistica, videoconferenze, hosting, social media, streaming video, file hosting e cloud, compreso gli spazi di archiviazione personale non condivisi (come iCloud di Apple). Sono compresi anche i servizi crittografati end-to-end, nel qual caso i fornitori dovranno scansionare i messaggi direttamente sugli smartphone o dispositivi, cioè prima della cifratura dei contenuti (scansione lato client).

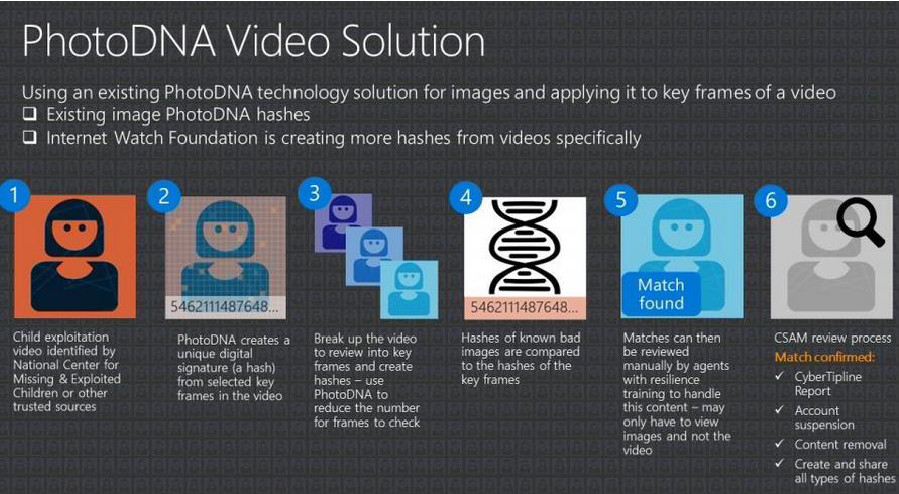

In sintesi si prevede l’obbligo di monitoraggio dei sistemi di comunicazione interpersonale come le chat o i sistemi di messaggistica. Quindi testi, immagini e video (il contenuto quindi, non solo i metadati) dovranno essere scansionati al fine di cercare materiale pedopornografico. I contenuti sospetti sono segnalati alla Polizia. In realtà i fornitori possono essere obbligati a scansionare sulla loro piattaforma o servizio solo se richiesti da un'autorità, ma sembra solo un escamotage della Commissione per evitare di dover imporre direttamente degli specifici obblighi di questo tipo alle aziende private. Infatti le piattaforme dovranno condurre una valutazione del rischio relativamente alle tecnologie utilizzate per mitigare il rischio che gli abusi siano facilitati dalla loro piattaforma. Se nella loro valutazione dei rischi non riescono a dimostrare che non sussiste rischio residuo di facilitare gli abusi, le piattaforme potranno essere costrette dalle autorità ad introdurre misure aggiuntive. Sarà l’EUCSA (centro europeo per gli abusi sessuali sui minori, di stanza all’Aia, vicino all’Europol) che fornirà le opzioni tecnologiche di rilevamento e gestirà il database dei materiali CSAM che sarà poi utilizzato dai fornitori durante la verifica dei contenuti e fungerà da facilitatore per la autorità e le piattaforme nazionali.

La proposta prevede inoltre che i fornitori di accesso a Internet possono essere obbligati a bloccare l'accesso a immagini e video vietati e non rimovibili ospitati al di fuori dell'UE mediante il blocco degli URL. Come ulteriori obblighi gli App Store dovranno verificare l’età per le app di comunicazione e archiviazione. Tutti i servizi di comunicazione o le app (es. appuntamenti ma anche giochi con chat di comunicazione) che possono essere utilizzati in modo improprio per lo sfruttamento di minori devono essere verificati e eventualmente bloccati per i minori.

Problemi della proposta

Monitoraggio del flusso di dati online

La proposta di legge parte dalla considerazione che l’interesse alla tutela dei minori è superiore rispetto ad altri diritti fondamentali, e deve avere una considerazione primaria (CSEA Directive del 2011). In tale ottica si prevede il monitoraggio di tutte le comunicazioni e dei sistemi di messaggistica, al fine di verificare se sono presenti materiali di sfruttamento o abuso di minori. Non si tratta solo di un controllo basato sulla corrispondenza di immagini (cioè la comparazione tra l’immagine online e un database di immagini già valutate dalle autorità – o in alcuni casi dalle aziende stesse - come pedopornografiche, comparazione che, non dimentichiamolo, comporta il trattamento di dati biometrici) rispetto al database CSAM (da child sexual abuse material), ma anche tramite l’uso di sistemi di intelligenza artificiale per la ricerca di abusi sconosciuti (cioè nuovo materiale), e potenziali “adescamenti di bambini” (grooming), cioè l’utilizzo di sistemi di apprendimento automatico (che notoriamente sono soggetti ad errori). Ma non sono previsti obblighi di trasparenza sugli algoritmi né verso il pubblico né verso la comunità scientifica, cioè gli algoritmi non saranno accessibili e quindi non sarà verificabile il tasso di errore degli stessi. Il rischio è che si traducano in enormi quantità di false segnalazioni.

Il controllo del flusso dei dati è automatizzato, quindi anche le foto di nudo più intime, le chat di sesso, messaggi di flirt e sexting, potrebbero finire nelle mani del personale dell’azienda privata (questo perché la segnalazione può danneggiare gravemente i soggetti segnalati, e quindi non può essere basata solo su una valutazione di un processo decisionale automatizzato), e della polizia, anche se non ci sono veri e propri reati. Pensiamo, ad esempio, alle persone LGBTQI, agli attivisti democratici, ai giornalisti, a persone trans che cercano informazioni sulle fasi di transizione, minori che cercano informazioni sulle tecniche di contraccezione, vittime di abusi che cercano conforto da altre persone che hanno subito le stesse vicende, ecc... Kendra Albert della Cyberlaw Clinic di Harvard ha sostenuto che la “protezione minori” potrebbe impattare negativamente sui minori queer, e sicuramente c’è il rischio che immagini di “transizione” sarebbero segnalate dall’algoritmo. Le leggi sulla pornografia non differenziano adeguatamente lo sfruttamento dalla sessualità adolescenziale, applicando regole simili ad entrambi i casi fino ad approcci di tolleranza zero (in Italia in realtà se non c’è sfruttamento del minore non si dovrebbe configurare un reato).

Leggi anche >> Gli adolescenti e l’educazione sextuale

La crittografia sicura è necessaria per proteggere le minoranze, invece con Chat Control 2 la segretezza della corrispondenza sarà cancellata, e anche la crittografia end-to-end sarà pesantemente minata, visto che l’intero flusso di dati dovrà essere analizzato comunque. E lo sarà, solo che l’analisi avverrà prima che i dati siano cifrati, e il monitoraggio avverrà direttamente sul dispositivo (lato client). In tal modo la proposta scoraggerà l'uso della crittografia end-to-end e incoraggerà fortemente i fornitori ad adottare le misure più intrusive possibili al fine di evitare conseguenze legali. Tale interferenza con la crittografia renderà ovviamente i telefoni e in genere i dispositivi più vulnerabili agli attacchi di attori malintenzionati.

Infine, il monitoraggio dei sistemi di messaggistica, producendo falsi positivi, inonderebbe di segnalazioni per lo più irrilevanti (es. le foto delle vacanze con bambini seminudi che giocano in spiaggia) gli investigatori danneggiando irrimediabilmente la loro capacità di indagine (già oggi purtroppo piuttosto ridotte per carenze di risorse).

Verifica dell’età dei soggetti (cancellazione dell’anonimato)

La verifica dell’età dei soggetti porrebbe fine alle comunicazioni anonime, obbligando le piattaforme all’identificazione di tutti i soggetti.

Blocco della rete

La proposta include l'obbligo per i fornitori di servizi Internet di bloccare l'accesso a contenuti specifici sui siti web su ordine delle autorità nazionali. Ma il blocco della rete è tecnicamente inefficace e facile da aggirare e si traduce nella costruzione di un'infrastruttura di censura tecnica.

Valutazione del rischio

Il sistema è strutturato in modo che gli obblighi più stringenti non siano applicabili di default. Se dalle valutazioni di rischio che effettuano obbligatoriamente le piattaforme, residua un rischio di facilitare gli abusi sui minori tramite i propri servizi, le piattaforme sono soggette agli ordini delle autorità che possono imporre delle misure aggiuntive. In sostanza le piattaforme saranno fortemente incentivate ad aggiungere di loro iniziativa il maggior numero di misure di mitigazione, quindi dei sistemi di filtraggio dei contenuti che scansionino tutti i contenuti che fluiscono sui loro server, proprio per non dover soggiacere a misure imposte per ordine delle autorità.

Questo anche perché i metodi tecnici imposti dalle autorità (il centro UE) potrebbero comportare rischi per la sicurezza dei sistemi, per cui le aziende private saranno incentivate a introdurre volontariamente sistemi di scansione automatizzata dei contenuti per poter dimostrare di aver “mitigato” i rischi.

Il precedente di Apple

In questo quadro è degno di nota che Apple qualche tempo fa aveva avviato i piani per introdurre una scansione del materiale CSAM sui propri dispositivi.

Leggi anche >> Apple, gli abusi sui minori e l’incubo della sorveglianza globale

Apple voleva introdurre la possibilità tecnica di raggiungere il dispositivo e fare all’interno dello stesso quello che decide di fare, senza che l’utente abbia alcuna voce in capitolo. Ecco perché molti lo hanno definito una vera e propria “backdoor”, un sistema di sorveglianza che funziona direttamente sul nostro telefono ed è potenzialmente in grado di violare qualsiasi crittografia end-to-end. Secondo l’EFF “un voltafaccia scioccante per gli utenti che hanno fatto affidamento sulla leadership dell'azienda in materia di privacy e sicurezza”.

A seguito delle critiche, i dubbi sull’efficacia del progetto in relazione agli obiettivi (la tutela dei minori) e il pesante impatto sui diritti dei cittadini, i piani di Apple sono stati sospesi.

Critiche alla proposta di legge

La proposta di legge appare forzare l’uso di tecnologie che possono minare le basi della nostra stessa società, e cioè la privacy e la sicurezza delle comunicazioni (e in un periodo di guerra con attori stranieri questi dovrebbero essere tutele primarie).

Numerose voci critiche si sono sollevate contro questa proposta. L’Associazione tedesca per la protezione dell’infanzia sostiene che la scansione delle comunicazioni private è sproporzionata e inefficace, in quanto la maggior parte del materiale pedopornografico viene condiviso non tramite mail o servizi di messaggistica, bensì tramite piattaforme e forum segreti autogestiti. Gli abusatori in genere caricano anche immagini e video come archivi cifrati (gli algoritmi non sono in grado di scansionare gli archivi cifrati) condividendo link e password. Ed è dello stesso avviso il Ministro degli Interni federale tedesco, Nancy Faeser, che ha precisato: “Le immagini di abuso vengono condivise e commercializzate principalmente nei forum e sulle piattaforme Darknet. Dobbiamo tenerli costantemente d'occhio, condannare gli autori e chiudere le piattaforme. Pertanto dobbiamo dare risorse aggiuntive alla polizia e alle forze dell'ordine e attrezzature tecniche adeguate". Ad esempio le investigazioni sottocopertura sono una risorsa rilevante per scovare le reti di pedofili e produttori di immagini pedopornografiche.

Anche l’Associazione tedesca per la protezione dell’infanzia ha sottolineato la necessità di maggiori risorse per le forze dell’ordine, con maggiore presenza in rete. Questo è un aspetto essenziale, perché dagli studi (es. indagine in Germania) emerge chiaramente che moltissime immagini CSAM rimangono in rete e non vengono rimosse anche dopo le segnalazioni alla Polizia. Quindi la Polizia non ha risorse sufficienti per seguire tutte le segnalazioni già oggi, figuriamoci nel caso in cui le segnalazioni dovessero più che decuplicarsi con l’introduzione di Chat Control.

L’Associazione tedesca sottolinea, inoltre, l’importanza della depenalizzazione del materiale autoprodotto tra i giovani.

L’associazione per i diritti civili EDRi ritiene che questa proposta “consentirebbe la scansione diffusa delle comunicazioni private delle persone e delle nostre conversazioni più intime” e “richiede inevitabilmente l'uso di strumenti di scansione basati sull'intelligenza artificiale notoriamente imprecisi”. EDRi sostiene che la strategia dell’UE sembra quella di lanciare una rete pericolosamente ampia per vedere cosa abbocca, proponendo misure che costringono tutti i fornitori di servizi di comunicazione e hosting di monitorare attivamente tutte le trasmissioni. Tali obblighi finiscono per confliggere con i diritti fondamentali dei cittadini. Invece occorrerebbero misure più mirate, oltre che proporzionate agli obiettivi.

Verso la sorveglianza globale

Con questa proposta di legge tutti i cittadini sarebbero sospetti e controllati senza aver nemmeno commesso un reato. Il monitoraggio sarebbe del tutto automatizzato, e non verificato da giudici.

Il testo prevede che tali tecnologie debbano essere “efficaci”, “sufficientemente affidabili”, “allo stato dell’arte nel settore”, e le “meno invadenti”, ma non sono previsti standard a livello europeo per misure di prevenzione efficaci, non è prevista trasparenza per i sistemi automatizzati, non sono previsti nemmeno tetti per i tassi di errore sopportabili dal sistema.

Nella sostanza l’intero progetto di legge è intriso di paternalismo, e mina la fiducia nelle istituzioni, prendendo la strada della sorveglianza di massa indiscriminata, del controllo e del monitoraggio di tutte le conversazioni e scambi di dati online (come se alla Posta aprissero tutte le lettere e i pacchi), arrivando sostanzialmente a eliminare del tutto le comunicazioni anonime, che sono alla base della sicurezza di molte categorie di soggetti. Nella società odierna tutti noi dipendiamo dalla sicurezza delle comunicazioni, ma anche dalla riservatezza, perché solo nel momento in cui siamo certi di non essere ascoltati possiamo realmente esplicare la nostra identità. Ma soprattutto tantissime categorie di persone devono poter contare su comunicazioni riservate e anonime, come ad esempio le vittime di abusi, le categorie discriminate, le minoranze, gli stessi giornalisti. Le vittime di violenze sessuali in particolar modo hanno necessità di spazi sicuri e anonimi nei quali poter comunicare in modo confidenziale, per cercare consulenza e supporto, oltre a comunicare coi loro terapeuti o avvocati. Un monitoraggio delle loro conversazioni li scoraggerebbe dal cercare aiuto e sostegno.

Non è questo il luogo per discutere delle problematiche sessuali e educative dei bambini, ma molti sostengono (Not the New Pornographers Protecting Sexting Teens from Overzealous Prosecutors and Themselves) che l’approccio giusto sia di fiducia e consapevolezza verso i figli, non certo di controllo e sorveglianza (specialmente se delegato ad aziende private che sono mosse dal puro profitto economico).

La cosa più grave è che questa tecnologia privatizzerà la giustizia penale, mettendo nelle mani di aziende private il controllo dei messaggi e quindi lo stabilire chi è che commette un reato. Si tratta di una tecnologia che può essere facilmente utilizzata per finalità ulteriori (lo dice espressamente l'EDPS europeo: se adottata finirebbe per essere la base per ulteriori legislazioni dello stesso tipo), ad esempio per la verifica di violazioni del copyright (cosa ne dite di un sistema che cancella un film direttamente sul vostro dispositivo?), ma anche per identificare i sovversivi e i dissidenti. Stiamo aprendo la strada ad un sistema di controllo sociale senza alcun precedente al mondo che cancellerà la privacy, un diritto che è la chiave di volta per la libertà di parola, l'autodeterminazione e l'autonomia. La cancellazione della privacy di fatto danneggerebbe proprio coloro che questa proposta di legge afferma di voler proteggere.

Per ulteriori informazioni si consiglia il sito del parlamentare Patrick Breyer.