Digital Services Act: cosa prevede il testo del Parlamento europeo

11 min letturaIl Parlamento europeo approva il suo testo del DSA

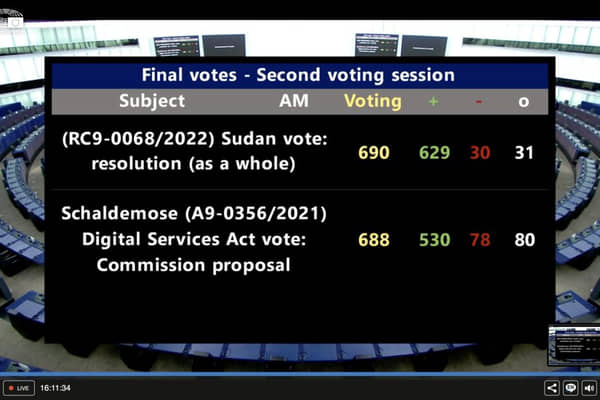

Il 20 gennaio 2022 il Parlamento europeo ha adottato il suo testo per il Digital Services Act (DSA), la legge sui servizi digitali. Da questo momento possono, quindi, partire i triloghi tra Parlamento, Commissione e Consiglio per la redazione del testo definitivo.

Il DSA è la madre di tutte le leggi sulle piattaforme, si inquadra in quella fase di scrittura di una sorta di costituzione europea in particolare con riferimento alla regolamentazione degli spazi digitali. Il DSA avrà il compito di regolamentare, tra le altre cose, la responsabilità per tutte le attività illegali online, da Facebook ai forum di discussione. Avrà il compito di definire le regole di base di tutti gli spazi digitali, quindi anche il quadro entro il quale si potranno muovere i termini di servizi e le condizioni generali dei siti web. Il tutto per rafforzare i diritti degli utenti contro eventuali decisioni arbitrarie.

A detta di molti il DSA è una buona proposta. Ma a osservarlo nei dettagli emergono immediatamente delle problematiche. Innanzitutto, come rileva Paul Keller, policy director di Open Future, l’approccio è ancora principalmente economico. Negli ultimi anni questo tipo di approccio è dominante, abbiamo regole per il mercato digitale, regole per il diritto d’autore nel mercato digitale, tutte iniziative che vedono il “mercato” come regola e il resto come eccezione. Il Single Digital Market di fatto ha sostituto la Società dell’Informazione. Insomma è evidente che la percezione da parte del legislatore europeo dello spazio digitale è a senso unico, si tratterebbe di un luogo quasi esclusivamente commerciale, e come tale andrebbe regolato. Quindi molte delle problematiche sociali legate alla digitalizzazione vengono inquadrate esclusivamente in termini di mercato. Il problema è che l’eccezione alla “regola mercato” sono le istituzioni, le iniziative civiche, gli attori non di mercato, insomma tutti quei soggetti che sono fondamentali per la società contemporanea, quei soggetti che creano dibattito pubblico, politico, sociale, culturale. Se le istituzioni sono le pietre miliari di una società democratica, è giusto che siano trattate come l'eccezione in un mercato? È giusto che debbano ritagliarsi uno spazio retto da regole economiche?

Non è un problema da poco, perché nei fatti le istituzioni nello svolgimento delle loro funzioni devono saltare gli ostacoli dettati dalla regole “economiche” del mercato digitale. Pensiamo alle limitazioni stabilite dalle norme in materia di copyright. O anche ai rischi che corrono nella gestione degli spazi digitali che sono rischi analoghi a quelli delle piattaforme commerciali.

Un ulteriore problema riguarda la scala, per così dire, della regolamentazione. Il DSA è stato scritto per le grandi aziende, tenendo a mente i modelli di business e l’organizzazione aziendale delle grandi compagnie tecnologiche come Meta (Facebook), Google o TikTok. Ma sarà comunque applicato a tutti, siano essi piattaforme no-profit o comunque rette da comunità online. Il responsabile di Wikimedia Foundation, Jan Gerlach, precisa che Wikipedia ha consentito la condivisione di conoscenza su scala globale grazie a un modello del tutto diverso da quello commerciale delle grandi piattaforme, un modello incentrato sull’autogestione dei volontari. Il DSA si incentra eccessivamente sulla rimozione dei contenuti illegali, ma considera unicamente un approccio top-down, laddove esistono molte altre realtà online che hanno approcci diversi, come la rimozione attraverso un rodato processo di decisioni della comunità che condivide standard precedentemente concordati insieme. L’approccio del DSA invece sarà sostanzialmente unico (one solution fits for all) con l'applicazione di una soluzione per tutti, cosa che difficilmente sarà in grado di adattarsi a tutti gli ambienti digitali, portando al rischio di soffocamento di un ambiente diversificato e fiorente di comunità non commerciali.

Infine il solito problema, derivante dalla non completa comprensione da parte dei politici delle questioni strettamente pratiche, ha portato ad una normativa vaga, per la quale è sostanzialmente impossibile prevedere le conseguenze effettive della sua applicazione. Il risultato e le problematiche le avremo, probabilmente, tra decenni, dopo una serie di decisioni giudiziarie.

Analisi delle principali previsioni

Analizziamo nel dettaglio le principali norme del testo, anche ove possibile raffrontando la previsione con le analoghe dei testi della Commissione e del Consiglio. Teniamo presente che il testo è stato redatto dalla Commissione IMCO (Mercato interno e protezione consumatori, qui la relazione sul testo finale), ma sono stati votati anche alcuni emendamenti che lo hanno modificato in parte.

Monitoraggio utenti e uso anonimo dei servizi digitali

L’articolo 7 vieta agli Stati membri di limitare l’offerta di servizi crittografati end-to-end e di limitare l’uso anonimo dei servizi degli intermediari. La previsione è che i fornitori di servizi digitali debbano fare ogni ragionevole sforzo per consentire l’uso e il pagamento dei loro servizi senza raccogliere dati personali del destinatario. Quindi si conferma il diritto di utilizzare i servizi online in modo anonimo (da non confondere con l’identificabilità da parte delle forze dell’ordine, in genere sempre possibile), in contrasto con gli obblighi di “nome effettivo” che ogni tanto provengono dai singoli Stati.

Inoltre i fornitori non possono essere obbligati a conservare “generalmente e indiscriminatamente” i dati personali degli utenti, in quanto l'eventuale conservazione dei dati deve essere motivata da un provvedimento giudiziario.

No esenzioni per i media

Come già detto in un precedente articolo, c’era la previsione di un’esenzione (specificamente richiesta dai grandi editori) per le “pubblicazioni di stampa” e per i “servizi di media audiovisivi” dalle regole applicabili alle piattaforme. Ciò avrebbe portato all’assurdo che anche la pubblicazione (es. su Facebook) di disinformazione (fake news) da parte di un giornale online non sarebbe stata soggetta a rimozione. Tale norma è stata eliminata a seguito di specifica richiesta da parte di giornalisti, fact-checkers e ricercatori sulla disinformazione. Si è trattato della questione più discussa. Un emendamento ha previsto, in alternativa, da parte delle piattaforme l’obbligo di rispetto della libertà e il pluralismo dei media.

Divieto di pubblicità mirata in alcuni casi

Non è stato previsto un divieto assoluto di pubblicità targettizzata o mirata, anche se è stato discusso nelle commissioni. Rispetto al testo redatto dalla Commissione IMCO sono stati però votati alcuni emendamenti. Il testo già prevedeva il divieto di utilizzo di dati personali per pubblicità personalizzata inviata a minori, ed anche i “dark pattern”. Inoltre, con gli emendamenti la normativa adesso prevede:

- divieto di cookie wall: se un utente rifiuta di dare il consenso ai cookie o ad essere tracciato dovrà comunque poter accedere al servizio;

- divieto di targeting con dati di minori o ex art. 9 GDPR: è vietata la pubblicità mirata che usa i dati dei minori o quelli che una volta erano definiti sensibili (oggi ex art. 9 GDPR).

Il cookie wall potrà essere utilizzato solo se viene fornito un servizio alternativo le cui condizioni di accesso siano eque e ragionevoli sia per gli utenti regolari che per quelli occasionali. Le piattaforme devono inoltre informare correttamente e in maniera trasparente gli utenti sui trattamenti a cui sono sottoposti i loro dati personali, fornendo informazioni anche su come i loro dati saranno monetizzati. Il rifiuto al consenso deve essere possibile a condizioni semplici come l’accettazione. In caso di rifiuto gli utenti devono avere opzioni alternative per l’accesso ai servizi, a condizioni eque e ragionevoli.

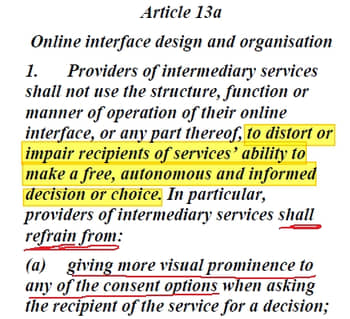

Ai fornitori di servizi online è poi vietato (art. 13 a) l’utilizzo delle loro interfacce online in modo da incidere sulle decisioni degli utenti limitando il diritto a una libera scelta, ad esempio dando risalto visivo a una opzione di consenso rispetto ad altre, e dovrebbero astenersi dal chiedere insistentemente il consenso al trattamento dei dati quando è stato già negato.

Il testo del Parlamento appare meno ambizioso delle proposte che sono già venute dall’EDPS e dall’EDPB, nei loro pareri sul DSA, che consistono in una graduale eliminazione della pubblicità personalizzata.

The EDPB also considers that online targeted advertising should be regulated more strictly

in the DSA in favour of less intrusive forms of advertising that do not require any tracking of

user interaction with content and urges the co-legislature to consider a phase-out leading to

a prohibition of targeted advertising on the basis of pervasive tracking10 while the profiling

of children should overall be prohibited.

In sostanza il cammino sembra tracciato a favore della pubblicità contestuale, eliminando gli strumenti di tracciamento online. Detto questo dobbiamo osservare che il DSA presenta soluzioni parziali e nemmeno tanto valide. Innanzitutto (vedi cookie wall) si prevede un consenso, laddove nessun valido consenso può essere fornito per la pubblicità personalizzata in quanto mancano evidentemente gli strumenti di trasparenza (a chi vanno i miei dati?) e di controllo (se i miei dati sono finiti a tutte le aziende, migliaia, di un circuito pubblicitario, come posso fare per revocare il mio consenso?). Quindi l’approccio del DSA è un divieto in alcuni casi della pubblicità se utilizza dati “sensibili”. È un divieto inutile perché può essere facilmente raggirato utilizzando proxy data (es. invece del targeting sulla religione, il targeting basato sull’interesse per una religione, invece del dato razza il dato localizzazione se un soggetto vive in un quartiere di soli neri, ecc....).

Leggi anche >> Il potere degli algoritmi sulle nostre vite

Leggi anche >> Protezione dei dati personali: l’intero sistema di pubblicità online viola la legge

Leggi anche >> Il futuro della pubblicità online è nei dati in poche mani e nelle piattaforme chiuse

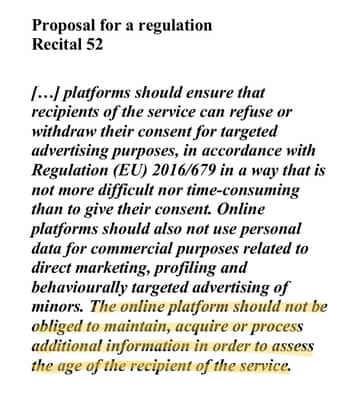

Un’ultima annotazione riguarda i minori. In passato si è talvolta discusso dell’introduzione di meccanismi per identificare i minori al fine di concedere loro una maggiore protezione nell’utilizzo dei servizi digitali. Ebbene il DSA contiene una previsione (Considerando 52) che vieta alle piattaforme di raccogliere dati ulteriori al solo fine di stabilire se un soggetto è minorenne o meno.

Moderazione dei contenuti

L’articolo 12 obbliga le piattaforme a far rispettare i propri termini di servizio (TOS, Condizioni generali, eccetera). La norma trova la sua ragione di essere nella considerazione che spesso online sono pubblicati e diffusi contenuti (es. hate speech) che non violano alcuna norma di legge ma sono contrari ai termini di servizio delle piattaforme. Purtroppo i TOS sono generici, poco trasparenti, spesso applicati in maniera arbitraria. Certe volte esistono due livelli, i TOS pubblici generici e poco comprensibili, e poi manuali e linee guida forniti ai soli moderatori (non resi pubblici quindi) che elencano casi pratici e come regolamentarli. Ovviamente una regolamentazione che lascia decidere alle grandi piattaforme cosa può essere rimossi online può portare ad abusi.

In maniera piuttosto simile a un recente approccio proposto negli USA, il contributo del DSA a una maggiore tutela per la libertà di espressione si presenta sotto forma di garanzie procedurali. Piuttosto che stabilire regole per il discorso il DSA preferisce fissare garanzie per il processo di regolamentazione del discorso. Quindi: chiarimenti per le procedure di notifica e rimozione, maggiore trasparenza, ricorsi effettivi e regole chiare e inequivocabili applicate in modo proporzionato. L’utente bloccato dovrà conoscerne il motivo ed essere informato della possibilità di appellarsi alla decisione, compreso un ricorso giurisdizionale.

Purtroppo, come potete notare sono tutti termini piuttosto generici e privi di reale contenuto. È difficile immaginare regole di equità sostanziale, che richiedono un trattamento equo di tutti i punti di vista. In sostanza saranno le piattaforme a decidere, fino a quando un contenuto effettivo non sarà stabilito a seguito di ricorsi ai tribunali.

Per quanto riguarda quest’ultimo aspetto (la delega ai privati) occorre tenere presente che probabilmente tale approccio deriva anche da considerazioni pratiche. Se fosse il governo ad assumere il controllo della regolamentazione dell’ambiente digitale, passeremmo semplicemente dalla rabbia della gente contro le piattaforme alla rabbia contro il governo, dato che la moderazione dei contenuti online è un compito semplicemente impossibile da fare bene. Sarebbe come se volessimo estirpare tutti i reati dal mondo.

Leggi anche >> Per una regolamentazione delle piattaforme digitali

Infine, l’approccio che insiste eccessivamente sulla rimozione di contenuti rischia di alimentare il ricorso a sistemi di moderazione algoritmica che sono (Algorithmic content moderation: Technical and political challenges in the automation of platform governance) estremamente opachi nelle loro scelte e ben poco responsabili. In tale prospettiva il rischio è che finiscano per esacerbare alcuni problemi sociali piuttosto che eliminarli o ridurli.

Moderazione dei contenuti dei politici

Il Parlamento non ha approvato una proposta (493) per un obbligo di pubblicazione (must carry) a favore dei contenuti forniti dai politici, in base alla quale la piattaforma non avrebbe potuto cancellare tali tipi di contenuti.

Leggi anche >> Trump, Twitter e la moderazione dei contenuti online

Conoscenza effettiva dei contenuti illegali

L’art. 14 del testo riguarda la "conoscenza effettiva” di contenuti illegali, dalla quale dipende la responsabilità delle piattaforme online. Il principio rimane ma la proposta DSA sembra propendere per l’idea che la “conoscenza effettiva” si avrebbe ogni volta che si riceve un avviso. Il testo attuale (Consiglio e Parlamento) invece prevede che le piattaforme abbiano la libertà di valutare gli avvisi prima che siano legalmente obbligati ad agire.

Rimozioni contenuti illeciti

Gli ordini di rimozione emessi da autorità giudiziarie o amministrative saranno efficaci solo negli Stati membri, a meno che il contenuto non sia illegale ai sensi del diritto dell’UE o i diritti in questione richiedano una più ampia protezione. Inoltre il Parlamento introduce un ricorso giurisdizionale effettivo contro le rimozioni, che può portare al ripristino dei contenuti erroneamente ritenuti illeciti.

Rinunce (esenzioni)

L’articolo 16 prevede delle esenzioni. In particolare il testo del Parlamento prevede che le piattaforme senza scopo di lucro possono chiedere alla Commissione europea di essere esentate (nel testo waiver, cioè rinuncia) da alcune regole previste dal DSA, purché non rappresentino un “rischio sistemico”. Tale norma si ha perché, come detto sopra, il DSA è scritto per la grandi piattaforme, e sarebbe difficile prevede esenzioni specifiche per molti casi. Ovviamente il tutto renderà più complicato per le organizzazioni no-profit (es. Wikipedia, Internet Archive) la gestione delle esenzioni, e anche per gli utenti sapere quali regole si applicano ai casi singoli.

Autorità di supervisione

L’articolo 40 regolamenta l’autorità alla quale sarà demandata la supervisione sull’applicazione del DSA. Secondo il Parlamento dovrebbero essere autorità nazionali, mentre il Consiglio vuole che la Commissione si occupi almeno delle grandi piattaforme.

Cosa accade adesso

I triloghi tra Parlamento, Consiglio e Commissione dovrebbero cominciare tra pochi giorni e terminare entro aprile. I testi (qui il testo del Consiglio) non sono molto differenti tra loro, per cui è possibile un’adozione di un testo condiviso in poco tempo, forse anche entro fine anno.

Le differenze maggiori riguardano l’autorità di supervisione, e la regolamentazione della pubblicità personalizzata.

Conclusioni

Il DSA non è la panacea di tutti i mali, anzi sotto certi aspetti è carente perché, come abbiamo già detto, l’approccio è unico ed è basato sulla premessa che l’ambiente digitale sia popolato da grandi aziende commerciali, con ciò non considerando tutte le realtà no-profit, le piccole realtà, insomma tutti i soggetti che fanno di internet un qualcosa di estremamente diversificato. L’applicazione di una soluzione unica e uguale per tutti, eccessivamente incentrata sulla rimozione dei contenuti potrebbe portare a conseguenze negative pesanti per tutto ciò che non è una realtà commerciale, laddove sono proprio queste realtà “minori” a fornire strumenti e spazi di discussione per la crescita sociale. Il DSA dovrebbe proteggere questi spazi, ma non lo fa, e questo è un serio problema che rischia di impattare negativamente proprio su ciò che rende migliore la nostra società.

Il problema è che la rete internet finora è stata lasciata alla regolamentazione dei privati (come è già accaduto in passato alla televisione), e l’avvio di una stagione di nuove norme (sovra)statali si rivolge ad un ambiente già consolidato e modellato in base all’incentivo economico. Proprio per questo le normative che vengono dall’Europa finiscono spesso per delegare alle grandi aziende (che fungono da grandi editori del web) la regolamentazione dei contenuti online. In tutto ciò tutto quello che non è “commerciale” avrà grosse difficoltà a mantenere i propri spazi.

Immagine in anteprima via pixabay.com