La proposta UE per regolamentare l’intelligenza artificiale: un testo che potrebbe cambiare la storia o quasi nulla

18 min letturaÈ un documento straordinariamente ambizioso, quello prodotto dalla Commissione Europea per creare un primo, storico quadro normativo di riferimento per l’intelligenza artificiale (AI). Un tentativo senza precedenti che l’Europa ha consapevolmente inteso non solo come strumento per regolare un insieme di tecnologie sempre più presenti e invasive nelle vite quotidiane di milioni di persone nel Continente, ma anche — forse soprattutto — come strumento geopolitico, per marcare una distanza dall’AI usata per il controllo sociale (sul modello cinese) e dalla retorica dell’innovazione privata a ogni costo (secondo quello statunitense).

Con la sua Proposta al Parlamento Europeo e al Consiglio Europeo (d’ora in avanti, la Proposta), l’UE intende dunque porsi come modello a livello globale, con l’obiettivo dichiarato — qui sta l’ambizione — di realizzare una “AI degna di fiducia” (“trustworthy AI”). Coniugando al meglio una (difficile) leadership internazionale nello sviluppo e adozione di sistemi a base di AI con il rispetto dei diritti umani e delle libertà fondamentali. E stabilendo, così, un insieme “armonico” (harmonised) di regole valido in tutto il mercato interno UE, così che se ne possa continuare a garantire il “corretto funzionamento”.

L’amministrazione Von der Leyen, al suo insediamento l’aveva, in un impossibile slancio di entusiasmo, promesso nei primi cento giorni; ma il fatto che produrre un testo dettagliato abbia richiesto molto più tempo non è necessariamente un male. Anzi. Nel frattempo, infatti, l’UE ha cominciato a incentivare un sano e lungimirante dibattito sulle tante incognite che si accompagnano all’adozione, fortunatamente sempre meno acritica, di tecnologie di intelligenza artificiale nelle nostre società.

Il ‘White Paper’ pubblicato il 19 febbraio 2020, il tronco da cui si dipartono i tanti rami della proposta di regolamentazione attuale, è stato per esempio sottoposto a consultazione pubblica fino a giugno dello scorso anno, ottenendo 1215 contributi dai diversi portatori di interesse. E dal 2018 la Commissione si è anche servita di un panel di 52 esperti, l’High-Level Expert Group on AI, per implementare la propria strategia sull’AI. Ma anche il Parlamento UE e il Consiglio Europeo, oltre al Garante europeo per la privacy, si sono ripetutamente espressi in materia di regolamentazione dell’AI, consentendo di complicare e rendere più sofisticato uno scenario che rischia altrimenti, nelle mani della sola Commissione, di vedere le priorità del business travolgere quelle dei cittadini, a partire dai loro diritti di base.

Perché è vero che, come ha detto la vice-presidente Margrethe Vestager, “non c’è posto per la sorveglianza di massa” in Europa, ma è altrettanto vero che per molto tempo — e anche nel testo che stiamo per analizzare, qua e là — i vertici del governo UE sono stati molto più espliciti nel promuovere l’idea che sia indispensabile adottare strumenti di AI in ogni ambito dell’attività umana, per realizzarne i molteplici benefici — che non mancavano mai di elencare — piuttosto che nel mostrare preoccupazione, e di conseguenza intervenire, contro i rischi sempre più di frequente documentati dalla cronaca e dagli studiosi del settore.

Parallelamente, tuttavia, è emersa con sempre maggiore chiarezza anche la necessità di proteggere le società democratiche dai problemi causati dall’AI. Ed è a questo secondo corno del dilemma che si rivolge la Proposta di regolamentazione presentata il 21 aprile, le cui 107 pagine — più 16 di allegati — sono in buona parte dedicate proprio a definire, comprendere e regolamentare i diversi rischi presentati dai sistemi a base di intelligenza artificiale.

La Proposta è ancora in bozza, e dovrà essere discussa dal Parlamento e dal Consiglio Europeo. Va ad aggiungersi ad altre norme UE (il GDPR e la Law Enforcement Directive, per esempio) e si integra, modificandole, a norme di settore (Machinery Directive, General Product Safety Directive) i cui aggiornamenti sono a loro volta in fase di definizione.

La Proposta è stata anche sottoposta a una valutazione d’impatto (“impact assessment” ), realizzata (e poi licenziata con parere positivo) dal Regulatory Scrutiny Board, prima di venire finalizzata nel draft attuale.

L'impianto di fondo: innovazione, ma a misura di diritti

Ma come si “promuove lo sviluppo, l’uso e l’adozione di sistemi di AI nel mercato interno” garantendo, al contempo, “un alto livello di protezione degli interessi pubblici, come per esempio salute, sicurezza e protezione dei diritti fondamentali”?

Come si regola un settore così invasivo, anche in Europa, nelle vite e nei diritti delle persone — dalla sanità al welfare, dalla giustizia al policing — limitando insieme le regole “ai requisiti minimi necessari a far fronte ai rischi e ai problemi collegati all’AI”, senza interferire indebitamente nello sviluppo e nell’adozione di AI in Europa?

E come si coniugano i diritti con la promessa di assicurare il “libero scambio di beni e servizi a base di AI”, e dunque impedire agli Stati membri di porre “restrizioni a sviluppo, marketing e uso di sistemi di AI, a meno che non siano esplicitamente autorizzati” dalla Proposta?

L’approccio dell’UE è sistematico, e parte dalle fondamenta. Prima di tutto, viene fornita una definizione di ogni termine tecnico adottato, inclusi diversi delicati e finora privi di una collocazione normativa ben definita “dati biometrici”, “sistema di riconoscimento delle emozioni”, “sistema di identificazione biometrica da remoto” (sia “in tempo reale” che “post”), e — non ultima — la stessa “AI”, di cui non esiste una definizione condivisa in letteratura. Ma di cui, tramite la Proposta, esiste ora una definizione condivisa nell’UE a livello normativo: AI è quell’insieme di tecniche (elencato nell’Allegato I) che, “a partire da un insieme di obiettivi definiti da esseri umani, genera output come contenuti, predizioni, raccomandazioni o decisioni che influenzano gli ambienti con cui interagiscono”.

Definition of an "artificial intelligence system" from the @EU_Commission Proposal for a Regulation on a European approach for Artificial Intelligence https://t.co/yXwlLiCeYH pic.twitter.com/OuInJKKicy

— Chris Yiu (@clry2) April 21, 2021

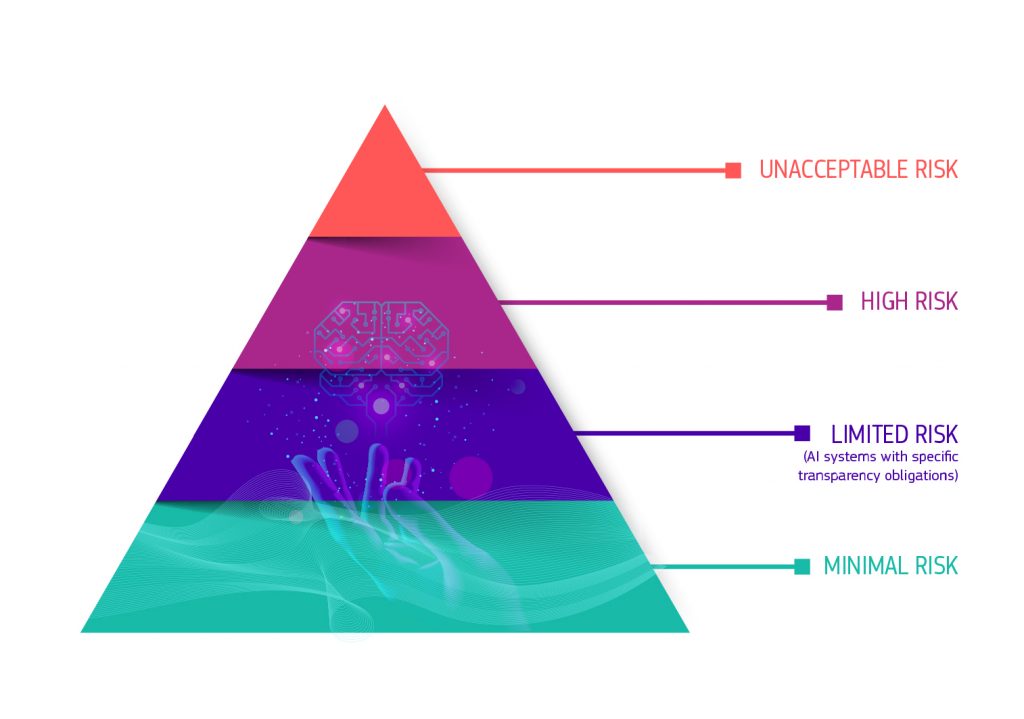

Come si vede da quest’ultima definizione molto ampia e vaga, o da altre non meno problematiche, non sempre il lavoro definitorio della Commissione pare centrato. Resta, tuttavia, un buon indicatore dell’ambizione del testo, che vuole fornire un vero e proprio insieme di regole di fondo per categorizzare diversi sistemi di AI in diversi livelli di rischio. E costruire, così, norme e requisiti la cui severità sia proporzionale al rischio presentato da ogni sistema di AI utilizzato.

Ora alcune applicazioni dell'AI si possono proibire

Resta dunque la logica di fondo (regole proporzionate al rischio) del ‘White Paper’ dello scorso febbraio, solo che ora le diverse categorie di rischio si riempiono di contenuto. Soprattutto, grazie probabilmente alla faticosa opera di convincimento della società civile, esiste ora una categoria di applicazioni dell’AI talmente rischiosa da dover essere proibita.

Si rompe dunque, ed è il primo aspetto fondamentale, il pregiudizio — chiaro spesso nelle parole di von der Leyen in passato — per cui ogni sistema di AI, se debitamente regolato, potrebbe produrre conseguenze benefiche, e dovrebbe avere quindi diritto di esistenza all’interno del mercato unico europeo: secondo il nuovo impianto regolatorio alcuni invece, semplicemente, sono troppo pericolosi per essere adottabili, e sono quindi giudicati radicalmente incompatibili con i valori di una società democratica.

Che questo principio sia passato, pur se come vedremo in modo gravemente lacunoso e imperfetto, è forse la vittoria più importante dei difensori dei diritti fondamentali. Perché ora correggerlo e meglio informarlo non richiederà più lo stravolgimento dell’impianto di fondo: la proibizione è invece già parte dell’impianto di fondo, nel riconoscimento che al vertice della piramide dei rischi sta un divieto. Il salto necessario non sarà più qualitativo, ma quantitativo: prevedere i giusti divieti, non che debba esistere un divieto.

L’articolo 5 della Proposta dettaglia, infatti, proprio una serie di sistemi di AI a cui proibire l’ingresso nel mercato UE, perché in contraddizione con “i valori dell’Unione”, e in particolare con il “rispetto della dignità umana, della libertà, dell’uguaglianza, della democrazia e dello stato di diritto”, nonché con “i diritti fondamentali nell’Unione, incluso il diritto alla non discriminazione, la protezione dei dati, la privacy e i diritti dell’infanzia”.

Si tratta dei “sistemi intesi alla distorsione del comportamento umano, da cui è probabile derivino danni fisici o psicologici”, si legge: sistemi che adottano componenti subliminali per manipolare comportamenti in modo tale da arrecare danno (divieto che tuttavia non dovrebbe riguardare la ricerca in materia); e sistemi di “scoring” sociale, per “valutare o classificare l’affidabilità di una persona sulle base dei comportamenti sociali esibiti in contesti multipli o sulla base di tratti personali e della personalità conosciuti o previsti”. Anche qui, il riferimento geopolitico alla Cina e ai suoi sistemi pervasivi a punteggio algoritmico è tutt’altro che velato.

Troppe eccezioni sul riconoscimento facciale

Ma il divieto comprende tutte le categorie che andrebbero, effettivamente, vietate? Purtroppo no.

Si prenda il caso più controverso: quello delle tecnologie di identificazione biometrica, e in particolare il riconoscimento facciale. Se usato da remoto in tempo reale, in luoghi pubblici e dalle forze dell’ordine, dev’essere anch’esso vietato, secondo l’articolo 5. In sostanza: la polizia non dovrebbe, in linea generale, poter usare strumenti che identifichino volti in una folla, per esempio in un evento sportivo o una protesta, e li confrontino in tempo reale con i database a loro disposizione.

O almeno, così sembrerebbe. Perché subito dopo la norma, cominciano le eccezioni. E sono ampie, troppo ampie. Le forze dell’ordine possono infatti comunque usare sistemi di riconoscimento biometrico da remoto in luoghi pubblici qualora sia “strettamente necessario”:

- Per trovare potenziali vittime per un crimine (ammesso la ricerca sia essere “targeted” e su “specifiche” potenziali vittime, compresi “bambini scomparsi”);

- Per affrontare alcune “minacce sostanziali e imminenti” all’incolumità personale (per esempio, per attacco terroristico);

- Per il riconoscimento, la localizzazione, l’identificazione o la conduzione di indagini contro colpevoli e sospetti per crimini che comportino una pena detentiva (per un minimo di tre anni).

Serve, in ogni caso, che una legge nazionale ne autorizzi l’utilizzo, oltre a “espressa e specifica autorizzazione di un’autorità giudiziaria o di un’autorità amministrativa indipendente di uno Stato membro” (“in via di principio”, ottenuta “prima dell’uso”), per verificare proporzionalità, necessità e applicazione in uno dei casi previsti — a meno che, ed è un grosso caveat, non ci si trovi in situazioni d’emergenza, in cui l’adozione può avvenire senza autorizzazione giudiziaria.

Insomma: anche senza addentrarsi troppo nei commi si comprende che il divieto fa acqua da tutte le parti.

Non solo: il divieto, anche così labile, viene stabilito solo per gli usi da parte delle forze dell’ordine. Come non hanno mancato di notare diverse organizzazioni della società civile, niente di tutto ciò vale per i sistemi di riconoscimento biometrico utilizzati da privati o perfino da altri rami dell’attività governativa. Visto il proliferare di questi sistemi in ogni ambito della vita pubblica (e non), e visto l’accumularsi di prove circa loro abusi ed esiti discriminatori, sorprende una posizione tanto debole della Commissione in materia.

Sembrano insomma essere state perlopiù inascoltate le voci della società civile, degli accademici, delle migliaia di firmatari della petizione #ReclaimYourFace — nonché il parere del Garante europeo (EDPS), che infatti non ha tardato a farsi sentire, ribadendo, a poche ore dall’emanazione del testo, di essere favorevole a una moratoria vera e propria su tali strumenti.

E diventa difficile per la Commissione reclamare un primato globale in materia, quando diverse amministrazioni locali negli Stati Uniti hanno già cominciato a mettere in atto divieti ben più severi ed estesi.

I sistemi di AI ad "alto rischio": condizioni (e problemi)

Il gradino immediatamente sottostante i sistemi da proibire, nella piramide UE dei rischi dell’AI, spetta ai sistemi di AI ad “alto rischio”. Ed è il gradino che occupa la maggior parte degli articoli della Proposta, che cercano prima faticosamente di individuarli (o meglio, elencarli), e poi di creare una rete di condizioni — di trasparenza, controllo e affidabilità — il cui rispetto, da parte dei fornitori dei sistemi di AI e di altri soggetti coinvolti, è obbligatorio.

La definizione di sistema ad “alto rischio” è tuttavia a dir poco contorta. Secondo l’art. 6 della Proposta, infatti, è ad “alto rischio” un sistema che rientra nell’ambito normativo specificato dall’Allegato II (due pagine di norme) e insieme abbisogna di una “valutazione di conformità” — cioè, di una verifica del rispetto delle condizioni stese nella Proposta — da parte di un soggetto terzo. Una definizione in parte vaga e in parte circolare, che sostituisce criteri ben precisi per individuare le caratteristiche generali di un sistema ad “alto rischio” con una lista, stilata nell’Allegato III, di applicazioni concrete dell’AI definite (o meglio: assunte) essere ad “alto rischio”.

E anche quando ci sia un timido tentativo di entrare più nel dettaglio, come per i sistemi di AI “stand alone”, non si sfugge dalla circolarità della definizione: “è appropriato”, si legge, “classificare ad alto rischio” i sistemi che “alla luce del loro scopo dichiarato pongono un alto rischio di danni alla salute, la sicurezza o i diritti fondamentali delle persone”. È insomma ad “alto rischio” ciò che è ad alto rischio.

Più utile è la nota, subito successiva, che bisogna prendere in considerazione “la severità del possibile danno e la probabilità del suo verificarsi”. O l’art. 7.2, che raccomanda, per aggiornare la lista dei sistemi ad “alto rischio”, di valutarne 1) Scopo dichiarato, 2) Utilizzo, 3) Danni già prodotti, 4) Danni potenziali, 5) Possibilità o meno delle persone di sottrarvisi o loro dipendenza dai risultati prodotti dal sistema senza "opt-out", 6) Danni a categorie vulnerabili, 7) Reversibilità del danno, 8) Reale possibilità di appellarsi alle decisioni del sistema secondo la normativa UE.

Ma è troppo poco, specie considerando che si tratta del concetto fondamentale che regge l’intero impianto della Proposta.

Bisogna dunque affidarsi alla lista dell’Allegato III per capire cosa intenda la Commissione per sistemi di AI ad “alto rischio”:

- Le infrastrutture informatiche critiche, il cui malfunzionamento può mettere a repentaglio la salute delle persone e dell’economia;

- Il riconoscimento biometrico da remoto, sia “real time” (in tempo reale) che “post” (a elaborazione in un momento successivo), che è dunque in generale permesso, come detto, al di fuori del contesto delle forze dell’ordine — ammesso rispetti le condizioni previste;

- Sistemi usati in ambito educativo per valutare test, determinare l’accesso a una struttura scolastica o formativa;

- Sistemi per il reclutamento e la selezione del personale, decidere promozioni o licenziamenti, stabilire compiti o per il monitoraggio e la valutazione sul posto di lavoro;

- Sistemi di scoring e affidabilità creditizia — che potrebbero condurre a forme di “discriminazione di persone o gruppi, e perpetuare dinamiche discriminatorie già esistenti”;

- Sistemi di AI usati dalle forze dell’ordine per riconoscere “deepfakes” (manipolazioni realistiche di video a base di deep learning), lo stato emotivo di una persona (sistemi per cui la società civile aveva chiesto invece, in blocco, un divieto) o l’affidabilità di una prova all’interno di un processo penale. In questi casi “accuratezza, affidabilità e trasparenza” diventano “particolarmente importanti” per evitare impatti negativi. Ma anche qui si applica un caveat piuttosto pesante: “sistemi di AI specificamente intesi per un utilizzo all’interno di procedure amministrative da autorità doganali o amministrative”, si legge, “non dovrebbero essere considerate ad alto rischio. Una posizione quantomeno singolare visto il disastro scatenato su migliaia di famiglie già vulnerabili da un algoritmo di riconoscimento delle frodi fiscali in Olanda;

- Sistemi di AI usati in contesti di controllo ai confini e gestione dei flussi in ingresso in un paese membro — compresi sistemi che “riconoscono lo stato emotivo” (e che sono, come già raccontato su Valigia Blu, estremamente invasivi, nonché basati su pseudoscienza);

- Sistemi applicati in ambito giudiziario a supporto delle decisioni delle autorità giudiziarie, a meno che non si tratti di attività di mero supporto amministrativo.

Anche qui come si vede ci sono diverse scappatoie, tra maglie già piuttosto larghe, e che includono anche sistemi — come quelli per il riconoscimento emotivo — per cui sarebbe legittimo sostenere l’opportunità di un divieto, più che di condizioni di utilizzo.

Ma quali sono le condizioni a cui deve sottostare uno qualunque dei sistemi individuati come ad “alto rischio” dalla Proposta, per avere accesso al mercato unico europeo?

Tra le principali figurano:

- L’uso di dati di alta qualità per addestramento, valutazione e test del sistema;

- La redazione di una serie di documenti tecnici e istruzioni per l’uso; tali istruzioni, dice l’art. 13.3, devono precisare l’obiettivo dichiarato del sistema, il livello di robustezza, accuratezza e cyber-sicurezza fornito, ogni “circostanza nota o prevedibile” in cui dall’uso possa derivare danno ai diritti fondamentali, quali misure di controllo (umano) sono previste, il ciclo di vita previsto del prodotto/servizio;

- Mantenere un’attività di documentazione del funzionamento del sistema, per tutto il suo ciclo di vita, e includendo informazioni circa “le caratteristiche generali, dotazione e limiti del sistema, algoritmi, dati, addestramento, fase di test e processi di validazione usati, così come la documentazione circa il sistema di gestione del rischio” utilizzato; va inoltre registrata ogni attività compiuta tramite il sistema, e tali “log” devono contenere, nel caso dei sistemi di identificazione biometrica, a) data e ora di inizio e fine di ogni utilizzo; b) database di riferimento, c) dati di input, d) riferimenti delle persone responsabili della verifica dei risultati prodotti;

- Requisiti di trasparenza all’utente, che deve essere in grado di comprenderne il funzionamento (per poterlo usare correttamente) e deve essere esplicitamente informato circa rischi e pericoli per i diritti fondamentali derivanti dall’uso del sistema;

- Supervisione umana, inclusa la possibilità per i supervisori umani di decidere che un sistema ad alto rischio non debba essere usato, o che ne debba essere ignorato o rovesciato un risultato.

Come si nota facilmente, è questa la parte più dettagliata del testo. E le pagine seguenti non sono da meno, stabilendo obblighi precisi per tutte le tipologie di soggetti a vario titolo coinvolti nella gestione dei sistemi di AI: fornitori, distributori, importatori — e sì, perfino gli utenti stessi, a cui viene chiesto di usarli secondo le istruzioni, monitorarne il funzionamento durante l’uso, e perfino mantenere i log delle attività compiute tramite il sistema, qualora possibile.

Ma funzionerà?

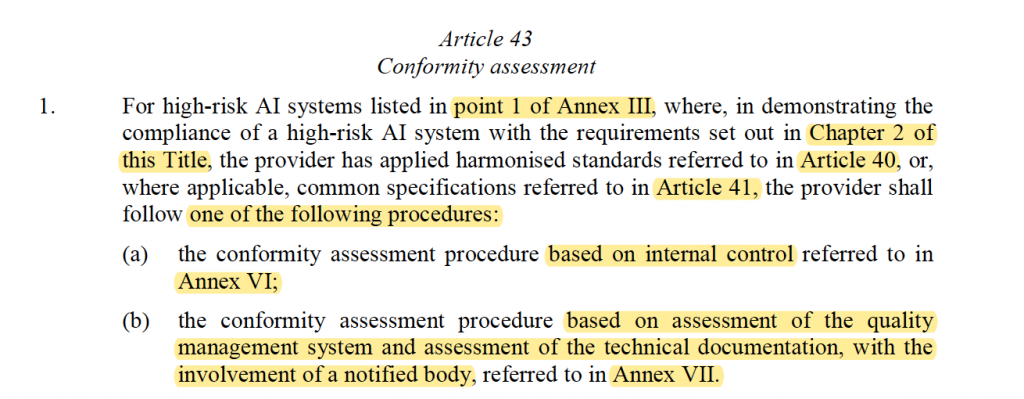

Il dettaglio lascia però presto il posto a una certa confusione, quando si passa ai meccanismi per garantire che l’impianto normativo così definito per i sistemi ad “alto rischio” venga poi effettivamente utilizzato — a partire dalla già citata “valutazione di conformità”, una sorta di analisi di impatto delle conseguenze derivanti dall’uso di un sistema ad alto rischio, da compiersi prima che venga effettivamente utilizzato.

Anche su questo aspetto, centrale, la Proposta presenta un testo a dir poco oscuro: si veda il dettato dell’art. 43.

La sostanza, a quanto si comprende, è che, per tutti i sistemi di AI definiti ad “alto rischio” nella lista precedentemente vista, vale una procedura di controllo “interna”: deve essere chi realizza il sistema di AI, in sostanza, a garantire che il suo funzionamento sia compatibile con le regole previste dalla Proposta, e sia dunque ammissibile nel mercato europeo. Spetta infatti ai fornitori di sistemi di AI stendere dichiarazione di conformità alle regole UE, e affiggere (in modo “visibile, leggibile e indelebile”, recita l’art. 49) un marchio CE ai sistemi ad alto rischio che siano conformi.

Per il solo riconoscimento biometrico da remoto, al contrario, serve l’intervento di un organo terzo (“notified body”) — anche qui, con alcuni caveat (contenuti negli artt. 40 e 41).

La procedura andrebbe poi ripetuta ogni volta che un sistema muti in modo significativo o venga utilizzato per uno scopo diverso da quello originario.

Anche con questo intervento minimale (in 7 categorie di sistemi ad "alto rischio" su 8 avviene internamente), si crea comunque una pletora di soggetti il cui coinvolgimento coordinato e coerente è indispensabile per l’effettiva applicazione della Proposta. Secondo l’art. 30, infatti, ogni Stato membro deve individuare una “notifying authority” responsabile della preparazione ed esecuzione delle procedure necessarie a valutare la conformità di un sistema AI ad alto rischio alle presenti regole. Tale autorità dovrà operare secondo “oggettività” e “imparzialità”, non avere conflitti di interesse, non fornire servizi consulenziali su base concorrenziale o commerciale, e salvaguardare la confidenzialità delle informazioni trattate.

Non solo. L’art. 33 dettaglia le caratteristiche e i requisiti dei “notified bodies”, ossia dei soggetti che dovranno verificare la conformità di un sistema biometrico con le regole UE. Anche di questi si dice che dovranno “disporre in modo permanente di sufficiente personale amministrativo, tecnico e scientifico dotato di expertise e conoscenze in materia di tecnologie di AI”, nonché giuridiche, sulla Proposta stessa. Potrebbe essere non banale soddisfare questa condizione, visto che uno dei principali, annosi problemi nel mercato dell’AI è proprio la scarsità di competenze in materia.

È poi previsto anche il coinvolgimento delle autorità di sorveglianza del mercato — che possono peraltro, seguendo l’ennesima eccezione, autorizzare l’ingresso nel mercato di un sistema AI ad alto rischio anche in assenza di una valutazione di conformità, nel caso ritenessero che quel sistema rispetti i requisiti della Proposta. Questo deve però valere solo “per un limitato periodo temporale”, al termine del quale deve comunque essere presentata la valutazione di conformità.

Dettaglio non di poco conto in termini di trasparenza: tali autorità hanno, “quando necessario” dice l’art. 64, accesso anche al codice sorgente del sistema di AI ad alto rischio considerato.

Altre novità: il Board europeo sull'AI, e un registro dei sistemi ad "alto rischio"

Un ultimo soggetto coinvolto, interamente nuovo, è l’ipotizzato “European Artificial Intelligence Board”, responsabile di una serie di funzioni consultive — tra cui fornire “opinioni”, “raccomandazioni”, “consigli” o “guida” in tutto ciò che riguarda l’implementazione delle nuove regole, di cui contribuisce a garantire uniforme applicazione in tutta l’UE. Composto dalle autorità di supervisione nazionale e dall’European Data Protection Supervisor (EDPS), è presieduto dalla Commissione, e tra le funzioni più utili figura forse quella di documentare e condividere best practices sull’effettivo uso di sistemi di AI.

Ma oltre ai dettagli vale il quadro generale, che rischia di affollarsi di una pletora di procedure e soggetti la cui operatività è minata da fondamenta incerte, definizioni vaghe, e troppe eccezioni.

Del resto, l’intera Proposta si regge sulla possibilità di riconoscere il livello di rischio di un sistema di AI. E non è una differenza solo formale. Tutt’altro.

Per i sistemi a livello “moderato” o “basso”, infatti, non vale alcuna delle condizioni finora stabilite. Si parla piuttosto dell’adozione volontaria di un codice di condotta che ricalchi i principi adottati per i sistemi ad alto rischio; la Commissione scrive all’art. 69 che dovrebbe “incoraggiare e semplificare” le cose per chi volesse scriverlo davvero, ma niente altro. E un fornitore avrebbe, piuttosto, ogni interesse a cercare di dipingere un sistema rischioso come a “basso” rischio, dato che ciò consente di evitare norme e orpelli.

Si pensi per esempio a quanto previsto all’art. 60: l’obbligo di iscrivere un sistema di AI ad “alto rischio” presso un “database” europeo, gestito dalla Commissione e contenente diverse informazioni utili a individuare un sistema di AI, e venire a conoscenza del suo utilizzo. Per quale motivo limitare questa elementare richiesta di trasparenza — da tempo avanzata da organizzazioni come quella di cui faccio parte, AlgorithmWatch — ai soli sistemi rischiosi?

Il pubblico non ha diritto di sapere quali soluzioni automatizzate vengono utilizzate da un’amministrazione pubblica, rischiose o meno che siano? Una risposta negativa appare bizzarra, quantomeno, visto che è la Proposta stessa a prevedere una sorta di obbligo di notifica di interazione con un sistema di AI ogni volta che si sia in presenza di sistemi di AI — ad alto o basso rischio, non conta — “pensati per interagire con le persone”.

Significa che, nell’UE, ho diritto di sapere di stare interagendo con un bot, o che il video che sto guardando è un deepfake, ma non che una decisione riguardante il mio inquadramento nel sistema del welfare per esempio, è presa da un sistema automatizzato? Si fatica a comprenderne il motivo.

Un aspetto mancante dal White Paper era quello delle sanzioni per la mancata applicazione delle regole proposte. Il testo in esame vi pone rimedio, immaginando due classi di sanzioni: una per violazioni degli articoli 5 e 10 (ossia: usare un sistema proibito, o farlo con dati di scarsa qualità), e una per le altre violazioni.

Nel primo caso sono previste sanzioni amministrative fino a 30 milioni di euro o il 6% del fatturato globale nel precedente anno fiscale (quale dei due è superiore); nel secondo, la somma scende a 20 milioni e la percentuale del fatturato al 4%. Ma anche qui, la norma precisa che in realtà la decisione ultima in materia spetta ai singoli Stati. E anche questo apre dei margini di ambiguità: le cifre scritte dalla Commissione sono solo un suggerimento, dunque, o sono cogenti?

Un primo, sommario bilancio: l'UE sta facendo la storia, ma deve farla nel modo giusto

Insomma, se da un lato l’esistenza stessa di un qualunque impianto normativo del genere rappresenta un punto di svolta storico nel rapporto tra tecnologia e politica — una svolta che sta venendo, con molta meno sistematicità, perseguita a vario titolo anche negli USA (specie dalla FTC) e perfino in Cina — dall’altro, dopo una dettagliata analisi del dettato normativo, si comprende anche perché la Proposta sia stata criticata anche duramente da diverse organizzazioni della società civile che si occupano di diritti digitali.

“Per le persone con il maggior rischio di subire le conseguenze di sorveglianza discriminatoria”, ha scritto Sarah Chander di EDRi, la Proposta “semplicemente non è abbastanza. Lungi dall’essere un approccio “umano-centrico””, come da sempre ribadito dalla Commissione UE, “la bozza nella sua forma attuale corre il rischio di consentire la realizzazione di stati di sorveglianza orwelliani”.

Sempre EDRi, nel suo più ampio giudizio della bozza, ha fatto riferimento anche a un certo soluzionismo di fondo, indispensabile a ritenere che i produttori delle tecnologie di AI siano anche i soggetti più adatti a verificarne opportunità e legalità.

AlgorithmWatch ha poi evidenziato la non inclusione del “predictive policing” tra i sistemi da proibire, limitandosi a definirlo ad “alto rischio” — oltre al fatto, piuttosto singolare visto il proposito di von der Leyen di mettere “al primo posto le persone”, che a mancare è proprio la prospettiva di chi più subisce i danni dei cattivi sistemi di AI: le persone, a partire dalle più vulnerabili.

Altre critiche riguardano l’opportunità di ragionare per liste di sistemi di AI, piuttosto che per criteri generali (la discriminazione di genere o razziale, nota il direttore dell’Institute for Ethics in AI di Oxford, John Tasioulas, può verificarsi in “sostanzialmente tutti i domini di applicazione dell’AI”), la sostanziale “privatizzazione” del proposto sistema di controllo e supervisione (come sostenuto da Alexandra Geese, parlamentare europea dei Verdi), o il fatto che sia prevista l’aggiunta di ulteriori applicazioni ad “alto rischio”, ma non da proibire (Access Now).

Insomma, ci sarà tempo per discutere, emendare, migliorare. E, nonostante alcune buone premesse, dovrà essere fatto davvero, in alcuni punti in modo sostanziale. Non si può ammettere in UE l’utilizzo di sistemi pseudoscientifici di riconoscimento emotivo; non si può derubricare il problema rappresentato dall’identificazione biometrica da remoto a una questione di forze dell’ordine (quando è invece una questione eminentemente democratica); e non si può creare un sistema di enforcement delle norme di cui permane il sospetto sia più facile identificare le scappatoie che il rigore.

Ma, pur con tutti i dubbi e le mancanze del caso, non si può che accogliere il tentativo dell’UE con favore. Vista la loro pervasività anche nella società europea, un quadro di regole serio e ragionato, per le applicazioni dell’AI è, oramai, effettivamente indispensabile. La sfida è fare in modo rappresenti un modello virtuoso per il resto del mondo in un frangente storico in cui tutte le regole della nostra convivenza digitale sono in fase di ridiscussione profonda, troppo spesso a detrimento dei diritti e delle libertà di tutti.

Immagine in anteprima: Foto di Gerd Altmann via pixabay.com