Il Parlamento europeo vota no al filtraggio dei contenuti online

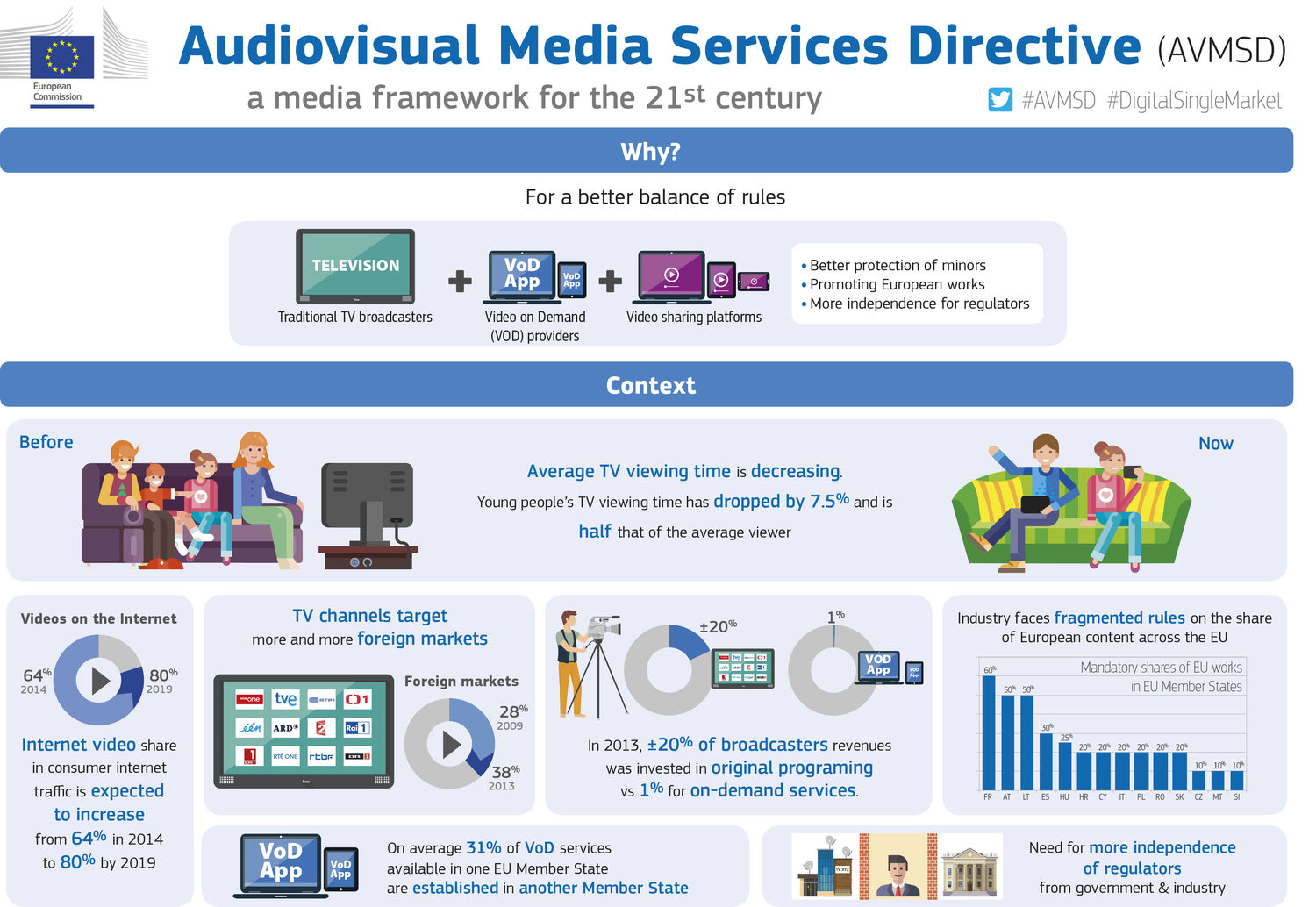

4 min letturaEra molto atteso il voto della Commissione CULT (cultura) del Parlamento dell'Unione europea sulla proposta di direttiva Audio Visual Media Services (AVMS), che si è tenuto il 25 aprile scorso. La direttiva, originariamente progettata per la Tv satellitare e per le piattaforme di video on demand, e quindi in relazione a soggetti che hanno un controllo editoriale su ciò che pubblicano, si occupa di disegnare le regole anche per le piattaforme di video-sharing e social media, quindi soggetti senza un controllo editoriale. Ciò avviene con definizioni generiche che rendono già difficile comprenderne l’ambito di applicazione e le scelte sottostanti. Ad esempio, si occupa della regolamentazione delle immagini in movimento, compreso le GIF quindi, non copre però le sezioni video complementari ai giornali o siti di notizie online, presentando ovvie contraddizioni.

Abbiamo già dato conto (leggi Internet e filtri: una forma di censura che mette a rischio le democrazie) del contenuto della proposta di direttiva presentata dalla Commissione europea, in particolare del fatto che la bozza contenesse norme per il contrasto online del razzismo, la xenofobia, l’incitamento alla violenza e all'odio e la tutela dei minori.

Lo strumento immaginato dalla Commissione per gestire queste problematiche online è l’onnipresente take down, la rimozione dei contenuti online, ma stavolta addirittura una rimozione preventiva con l’attuazione, da parte degli intermediari della comunicazione cioè le grandi aziende del web, di appositi filtri che si occuperanno di impedire la pubblicazione di tali contenuti o rimuoverli.

Dopo mesi di tentativi di trovare un compromesso tra le esigenze di rimozione di contenuti pericolosi e i diritti dei cittadini (si veda il Considerando 31), la Commissione CULT del Parlamento ha espresso parere negativo sull'introduzione di appositi filtri dei contenuti online. Non si tratta di non concordare sulla necessità di impedire la pubblicazione di contenuti pedopornografici, per fare un esempio tra i più facili da comprendere, quanto piuttosto di capire che si cerca di risolvere problematiche molto differenti tra loro con il medesimo strumento (si ragiona come se avessimo solo il martello, per cui tutto va considerato un chiodo). Si tratta di comprendere che hate speech, incitamento alla violenza online e cyber bullismo, non hanno definizioni concordi, ed è difficile prevedere sanzioni per qualcosa che non è ancora ben definito, addirittura ancora non ben compreso. E lì, sullo sfondo, in attesa, già si palesa la troppo enfatizzata discussione sulle fake news, un’altra categoria che definire generica è un eufemismo.

La bozza di direttiva prevede che i provider dovrebbero tenere i bambini lontani da contenuti in grado di “mettere in pericolo il loro sviluppo fisico, mentale o morale”. Ed ancora, proteggere il pubblico da forme di incitamento in grado di minare la dignità umana (leggi l’articolo su EDRi), e da forme di incitamento all'odio come conseguenza di "altre opinioni". Le definizioni sono troppo ampie, e quindi non in grado di aiutare concretamente nella selezione dei contenuti da eliminare, e lasciano mano libera a chi deve dargli un contenuto, definizioni in grado di prestare il fianco ad abusi, di essere strumentalizzate e quindi che danno un potere enorme a chi controlla, chi verifica, chi decide. E, non dimentichiamolo, a decidere sarebbero le poche grandi aziende del web, quali veri e propri sceriffi del web. Forse i termini di servizio (TOS) sono migliori delle leggi? Forse le aziende private hanno miglior giudizio di un giudice?

Si tratta, in fin dei conti, di norme in palese violazione del principio di certezza del diritto, intesa come precisione e intelligibilità della norma giuridica, del precetto legislativo. È uno dei cardini fondamentali di una democrazia, perché se la norma non è precisa, il precetto (ciò che la legge chiede al cittadini di fare o di non fare) non è comprensibile, e quindi il cittadino è facilmente soggetto agli abusi di chi ha il compito di interpretare la regola.

Con questa recente ondata di norme e regolamentazioni in materia di hate speech, fake news, ecc…, ormai ci siamo incamminati verso una rigida limitazione della libertà di espressione online, con l’apposizione di sempre più paletti all'ambiente digitale, e l’attuazione delle norme, data la loro genericità, comporterà necessariamente che il cappio alla gola della democrazia sarà sempre più stretto. Fino al punto di non ritorno.

Per fortuna la Commissione Cultura ha ben compreso la pericolosità del momento e ha detto no (il voto si è concluso 17 a 9), no ai filtri, no alle norme che istituiscono gli sceriffi del web con privatizzazione dei diritti online. Questa sarà la posizione del Parlamento nelle prossime discussioni col Consiglio d'Europa sulla proposta di direttiva.

Esistono altre norme che si occupano di questi problemi, molto discussi e molto sentiti nella società moderna, ci sono altre sedi per discuterne e possibilmente strumenti diversi, migliori rispetto ad un mero take down. La realtà è che oggi nessuno sa se queste rimozioni funzionano, a parte forse per le violazioni del copyright, ma lì il discorso è completamente diverso. A ben vedere non sono sanzioni per contenuti illeciti o dannosi quanto piuttosto la predisposizione di illeciti amministrativi per le piattaforme online (un modo per controllare i controllori?). L’unico effetto certo è la restrizione degli spazi di discussione online e la centralizzazione del controllo dei contenuti.

Per un governo è più facile controllare mille siti e blog online, oppure quattro aziende del web? E in quest’ultimo caso, dato il potere negoziale delle quattro aziende, i governi dovrebbero scendere a patti con loro, dando qualcosa in cambio del controllo dell’informazione, in un patto faustiano che potrebbe considerare le tutela delle libertà dei cittadini un mero accidente di percorso.

Immagine anteprima via www.eud.eu